非接触操作によるUIは万能か? NUI実現における注意点:モーションセンサーで組み込み機器はどう変わる?(2)(3/3 ページ)

NUIを実現するためのガイドライン

ここまで、インタラクティブサイネージの実証実験から得た経験を基に、NUIの本質である“誰でも直感的かつ自然に”を実現することの難しさを説明しました。では、NUIを実現するためには、具体的にどのようなことに注意すればよいのでしょうか?

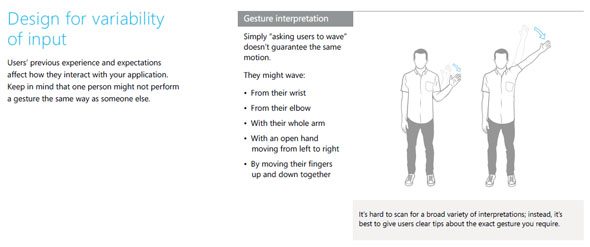

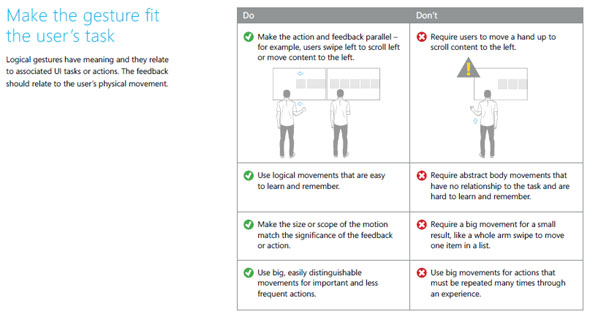

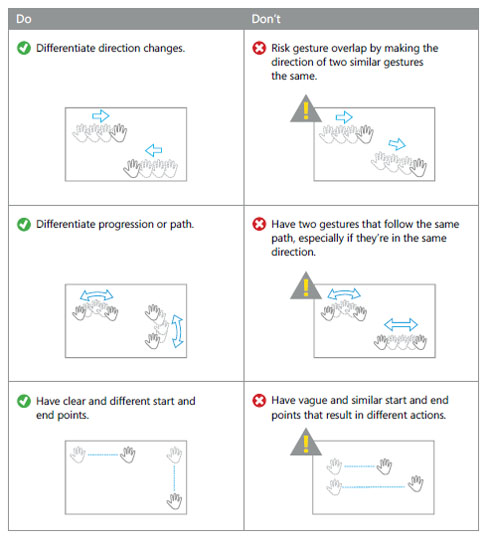

例に挙げたように、単純なジェスチャーでも人それぞれで動作に“違い”があります。「開発者なら上手く操作できるが、他の人が使うと反応しない」ではダメなのです。そうならないためには、多くの人の行動パターンをサンプリングし、それを分析した上で、誰が操作しても同じ結果になるように機能を実装することが必要です。

Kinectの開発元であるMicrosoft社からは、NUIを実現するためのガイドラインを示した資料が公開されています。この資料は、Kinect for Windows Developer Toolkitの中にある「Human Interface Guidelines(HIG)」からダウンロード先のURLに遷移するか、http://msdn.microsoft.com/en-us/library/jj663791.aspxから入手できます。この資料の中では、どのような点に注意してジェスチャーを実装すべきかが詳しく解説されていますので、ぜひご覧ください。

NUIの課題は操作感のフィードバック

モーションセンサーデバイスによる非接触操作を実現するに当たり、操作者に対する“フィードバック”をどのように返すかも課題となります。

例えば、ジェスチャーによって何かしらの操作をした際、そのジェスチャーが認識されたかどうかを操作者に返す(フィードバックする)仕組みが必要です。例えば、ジェスチャーを認識したタイミングで音を鳴らしたり、画面上でエフェクトをかけたりといった、聴覚や視覚に対してフィードバックを返す方法があります。

また、タッチパネルを搭載するスマートフォンなどでは、画面内のボタン操作を行った際にバイブレーションを発生させたり、ゲームのコントローラーなどでは、フォースフィードバック(Force Feed Back)といった触覚をフィードバックしたりする仕組みが存在します。

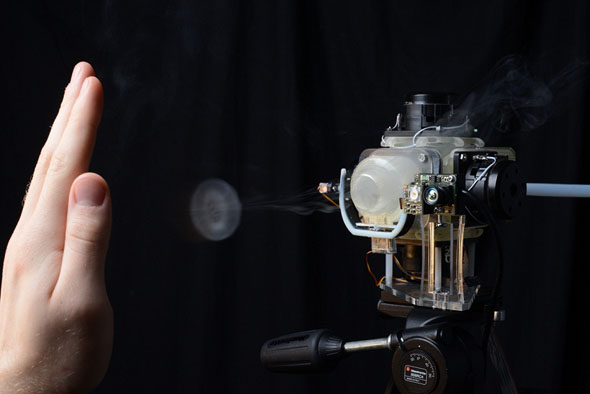

では実際に、非接触操作をしながら触覚のフィードバックを実現できたらどうでしょうか? これはとても難しい技術のように感じますが、既にDisney Researchの「Aireal」では、肌に圧縮した空気の輪当てて“感触を返す”仕組みを実現していますし、超音波で触覚を再現する「超音波集束装置」なども登場しています。つまり、触覚のフィードバックは夢や未来の話ではなく、実現可能なレベルにまできているのです。

こうした触覚をフィードバックする技術を上手く組み合わせれば、より操作感が得られやすくなり、さらに一歩進んだNUIを実現できるのではないでしょうか。

3次元の出力装置について考える

モーションセンサーデバイスは、「縦」「横」「奥行」の3次元情報を入力できます。そのため、空中ディスプレイやHMD(Head Mounted Display)といった3次元の出力デバイスとの組み合わせにも注目が集まっています。ここでは、その一例を紹介します。

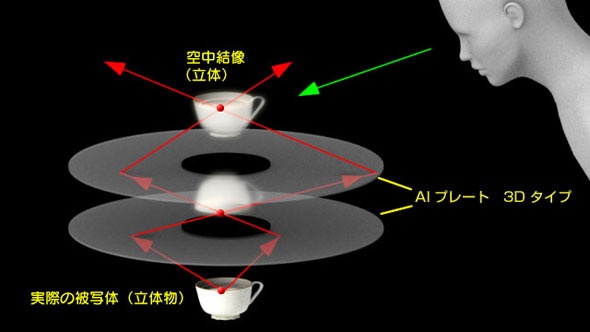

アスカネットの「AI(Aerial Imaging)プレート」は、被写体の実像をリアルタイムに空中に写し出すことができる特殊なプレートです。このAIプレートとモーションセンサーデバイスを組み合わせることで、目の前の空中に投影された立体像を、実際に触っているかのように操作できます。

| 参考リンク: | |

|---|---|

| ⇒ | アスカネット エアリアルイメージング |

2013年10月に開催された「CEATEC JAPAN 2013」の会場では、アスカネットが空中ディスプレイとモーションセンサーデバイスを組み合わせて、空中に映し出された3Dモデルを手でつかんで操作したり、空中でATMのメニュー操作を行ったりと、さまざまなデモを披露し、多くの来場者の注目を集めていました。

このように、モーションセンサーによる3次元の入力デバイスと、空中ディスプレイのような3次元の出力デバイスはとても相性が良く、双方が融合することで、これまでにない“新しいユーザー体験”を提供できるのです。

さて、連載第2回では、モーションセンサーデバイスのUIとしての活用例や、NUIを実現するに当たっての注意事項を解説しました。

モーションセンサーデバイスは、今回紹介したようなUI以外の活用として、例えば、空間演出や動作分析、計測などさまざまなシーンで広がっています。次回は、こうしたUI以外の場面での活用事例を紹介するとともに、モーションセンサーデバイスをどのような場面で使うのが最適かを解説します。お楽しみに! (次回に続く)

筆者紹介:

茂出木裕也(もでき ゆうや)

東京エレクトロン デバイス エンベデッドソリューション部

フィールドアプリケーションエンジニア

山形県出身。Microsoft Windows Embedded MVP(Most Valuable Professional)アワード受賞者。x86アーキテクチャ・ファームウェア開発(BIOS)のプログラマー職を経て、現在はWindows Embedded OSの技術サポートに従事。組み込み業界でのKinectの可能性にも注目し、各種イベントやセミナーではスピーカーを務める。

Windows Embedded コーナー

関連キーワード

ユーザーインタフェース | Windows Embedded 関連 | NUI(Natural User Interface) | ジェスチャー | モーションセンサー | Windows | Kinect for Xbox 360 | Kinect for Windows | デジタルサイネージ | Windows Embedded | タッチパネル | 実証実験 | ディスプレイ | 触覚 | インタフェース | 組み込み | モーションセンサーで組み込み機器はどう変わる?

関連記事

- >>「モーションセンサー活用」

Kinect センサーで夢と魅力にあふれるアプリを“創造”しよう!

Kinect センサーで夢と魅力にあふれるアプリを“創造”しよう!

「Kinect for Windows センサー」によるアプリケーション開発のための“超”入門。本格的な開発を始める前に絶対に知っておきたい、Kinect for Windows センサーの特長やXbox 360版との違い、開発時の注意点、応用例などをまとめて紹介する。 マイクロソフトがUIの進化を語る、NUIの発展を牽引するKinectとMSRの研究事例

マイクロソフトがUIの進化を語る、NUIの発展を牽引するKinectとMSRの研究事例

マイクロソフトのモーションセンサーデバイス「Kinect for Windows センサー」が発売されてから間もなく1年がたとうとしている。発売当初から、次世代のユーザーインタフェース「NUI」を手軽に実現できるデバイスとして注目を集め、既に多くの開発プロジェクトが始動している。本稿では、日本マイクロソフトが披露したKinect for Windows センサーを活用した事例およびMicrosoft Researchによる最新の研究成果を紹介する。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

コーナーリンク

図5 Kinect for Windows Developer Toolkitにある「Human Interface Guidelines」

図5 Kinect for Windows Developer Toolkitにある「Human Interface Guidelines」

図6 Human Interface Guidelines(HIG)によるNUIのガイドライン

図6 Human Interface Guidelines(HIG)によるNUIのガイドライン 図7 Disney Research - Aireal

図7 Disney Research - Aireal 図8 AIプレート3Dタイプ 空中映像結像の仕組み

図8 AIプレート3Dタイプ 空中映像結像の仕組み 図9 CEATEC JAPAN 2013に出展したアスカネットの展示ブース

図9 CEATEC JAPAN 2013に出展したアスカネットの展示ブース