音声認識の覇権を握る「Amazon Alexa」、逆転の余地はまだある?:IoT観測所(30)(1/3 ページ)

「CES 2017」で一躍存在感を高めた音声認識インタフェース「Amazon Alexa」。既に覇権を握りつつあるという見方も多い。それでも競合他社にとってまだ逆転の余地は残されているようだ。

「CES 2017」で一躍存在感を高めたのが音声認識インタフェース「Amazon Alexa」。1年前の「CES 2016」でもその傾向はちょっと見られた、という話は吉岡佐和子氏の記事にもあるが、今回はそれどころではなく、700を超える機器がAlexaを組み込む形で展示を行っていたという報道もあるほど。

三木泉氏の記事にもその様子がちょっと触れられているから、ご存じの読者も居られよう。そんな訳で今回はAlexaの紹介をしたいと思う。

Alexaはそもそも何か? というと、Amazonのクラウド「AWS」ベースの音声認識サービスというのが一番正確な表現だろう。もともとAlexaは「Amazon Echo」を支える仕組みという形で紹介されており、Echoが米国内で限定的に販売された2014年11月の時点では、Alexaはあくまでも脇役という位置付けにあった。

これが主役の座に躍り出てきたのは2015年6月25日のことである。この日、Amazonはサードパーティーに対して「Alexa Skills Kit」というSDKと「AVS(Alexa Voice Services)」というAPIを公開した。加えて、これらのSDKやAPIを利用して開発者が自身のサービスをAlexaベースで提供できるようにするために、総額1億ドルもの「Alexa Fund」まで用意するという周到さである。

この時点でEchoとAlexaは完全に別のものになった。というよりも、「Echoを支える仕組みのAlexa」、という位置付けから「Alexaを利用したアプリケーション例としてのEcho」という逆転現象が起きたと言ってもいい。もっともこれは、あくまで外部から見たスタンスであって、Amazon内部では当初からのロードマップ通りだったのかもしれないが。

その後、Echoに続き「Echo dot」と「Amazon Tap」が2016年3月に発売された。このEcho dotの説明画像(写真1)を見ると、まずAlexaがありき、という位置付けになっていることが明確である。そしてここからサードパーティーによるインプリメントが始まる。CES 2016の時点ではまだ数は少なかったが、CES 2017で700ものサービスが出てきたというのは、初期から手掛けていたサードパーティーによるインプリメントがほぼ完了した、という流れと考えて良いだろう。Amazon純正では、この後「Amazon Fire TV」にもAlexaが実装されており、要するに音声認識が必要なところには全てAlexaが使われる形だ。

「Alexa」の中身、「AVS」と「Alexa Skills Kit」

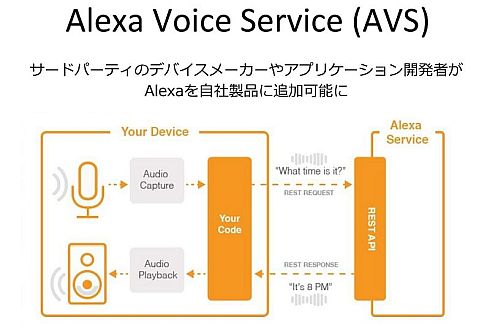

さてそのAlexaの中身、というかAVSとAlexa Skills Kitをもう少しご紹介したい。

まずAVSであるが、これはある意味単純な構図である(写真2)。音声をキャプチャー後、それをREST Requestの形でAVSに投げると、最終的な結果がREST Responseとして帰ってくる。最低限、このAVSへのRequest/Responseの処理だけをデバイス側に実装すれば、それでAlexaが利用できるようになる。

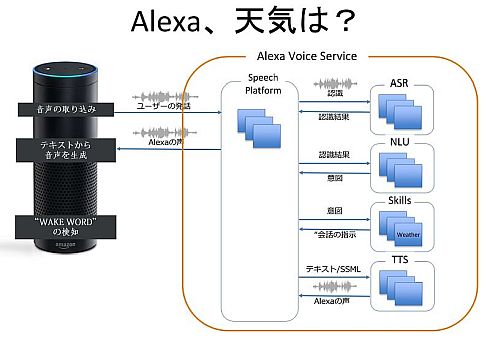

これに比べてより重要なのがAmazon Skills Kitだ。例えば、Echoを利用する場合、AVSの内部ではこんな動き方になる(写真3)。ここでASR(Automatic Speech Recognition)は音声を認識し、それを幾つかの英単語に分ける機能を持つ。

次いでその英単語はNLU(Natural Language Understanding)という自然言語認識エンジンに送られる。NLUの中では、単語の組み合わせから「意図」を検出して返す。NLUで抽出された「意図」は、Skillsに送られることになる。

このSkillsで実際に行うべき処理(例えば天候の問い合わせという「意図」であれば、現在地における天候を他のサービスから取得し、この結果から「返答」を作成した上で、会話の指示を返す。

最後がTTS(Text To Speech)で、これは「返答」のテキストを音声に変換するものだ。

これら4種類のService全体を包括するのが「Speech Platform」で、ここがそもそものデバイスからのリクエストを受けて、ASR/NLU/Skills/TTSに順次問い合わせを行い、その結果を次のServiceに投げるといった処理を行った上で、最終的な音声をデバイスに返す仕事を行う。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- チップレットでASIL Dを支援する車載SoC技術を開発

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

コーナーリンク