スーパーコンピュータを活用し、AI学習を容易に高速処理する技術を開発:製造ITニュース

富士通は、スーパーコンピュータを活用して、大規模なAI学習を簡単かつ高速に処理するソフトウェア技術を開発した。大規模な日本語AIモデルに適用して検証した結果、従来1個のGPUで数カ月要した演算を短時間で学習することに成功した。

富士通は2021年11月24日、スーパーコンピュータを活用して、大規模なAI(人工知能)学習を簡単かつ高速に処理できるソフトウェア技術を開発したと発表した。高性能な自然言語処理AIモデルの学習環境を、大規模コンピュータ上に容易に準備する技術で、世界トップクラスの高速演算性能と認識精度を実現できるという。

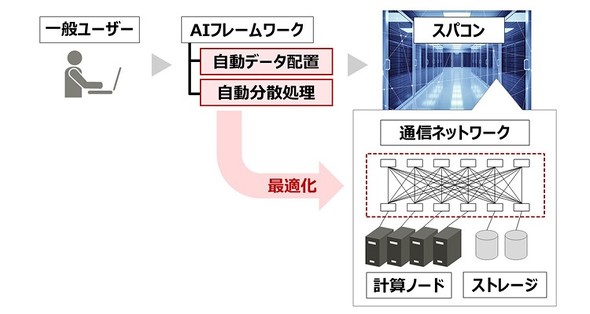

同技術では、スーパーコンピュータのシステムに応じた最適化技法をHPC(High Performance Computing、高性能コンピューティング)の専門家が最適化し、ユーザーが実行するジョブに対して、自動データ配置と自動分散を適用する。これにより、AIフレームワークによる環境はそのままで、計算基盤を容易にスーパーコンピュータへ移行できる。

スーパーコンピュータは、ネットワーク構成やファイルシステムなどの環境が異なっており、効率的なデータ参照にはシステムの知識と技術が必要とされる。今回開発した自動最適化技術を適用することで、専門知識や技術を持たなくてもAIフレームワークが利用可能になる。

同技術を大規模な日本語AIモデルに適用して検証した結果、従来1個のGPUで数カ月要した演算を短時間で学習することに成功。パラメーターの要素数が約12億個のBERT-XLargeと約39億個のBERT-3.9Bの巨大モデルを適用したところ、768個のGPUを用いてXLargeを4.7時間、BERT 3.9Bを約16時間で学習できることを確認した。また、大規模化によって、日本語自然言語モデルとしては最高の精度を達成した。

関連記事

スーパーコンピュータ「富岳」が完成

スーパーコンピュータ「富岳」が完成

富士通と理化学研究所が共同で開発、整備を進めてきたスーパーコンピュータ「富岳」が完成した。学術、産業分野向けに広く提供するため、理化学研究所と高度情報科学技術研究機構は富岳の共用を開始した。 富岳がスパコン性能ランキングなど4部門で4期連続世界1位を獲得

富岳がスパコン性能ランキングなど4部門で4期連続世界1位を獲得

富士通と理化学研究所が共同開発したスーパーコンピュータ「富岳」が、国際的なランキング「TOP500」「HPCG」、性能ベンチマーク「HPL-AI」、機械学習処理ベンチマーク「MLPerf HPC」でそれぞれ世界1位を獲得した。 PFNが首位奪還、スパコンの省電力性能ランキングGreen500発表

PFNが首位奪還、スパコンの省電力性能ランキングGreen500発表

Preferred Networks(PFN)は2021年6月28日、神戸大学と共同開発した深層学習用プロセッサを搭載したスーパーコンピュータ「MN-3」が省電力性能ランキング「Green500」において世界第1位を獲得したことを発表した。 フォークボールはなぜ落ちる? スパコンによる空力解析で謎を初めて解明

フォークボールはなぜ落ちる? スパコンによる空力解析で謎を初めて解明

野球のピッチャーの決め球、フォークボールはなぜ落ちるのか? これまでボールの回転数が少ないことで自然落下による放物線に近い軌道を描くとされていたが、東京工業大学 学術国際情報センター 教授の青木尊之氏を代表とする研究チームがスーパーコンピュータ「TSUBAME3.0」による数値流体シミュレーションを実施し、その謎を初めて解明した。 NVIDIAの「英国最速」AIスーパーコンピュータが正式稼働

NVIDIAの「英国最速」AIスーパーコンピュータが正式稼働

NVIDIAは2021年7月6日(現地時間)、「英国で最速」(同社)のスーパーコンピュータ「Cambridge-1」が正式稼働を開始したことを発表した。AIを活用したバイオテクノロジーや医療分野での研究活動を支援する。 スーパーコンピュータ京がGraph500で8期連続世界第1位を獲得

スーパーコンピュータ京がGraph500で8期連続世界第1位を獲得

理化学研究所らによる国際共同研究グループは、大規模グラフ解析に関するスーパーコンピュータの国際的な性能ランキングGraph500にて、スーパーコンピュータ「京」による解析結果が8期連続で第1位を獲得したと発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

製造マネジメントの記事ランキング

- DXの先を見据えたQXに取り組む東芝 量子社会の実現に向けた“痛みを伴う歩み”

- AI駆動開発を支援するIBM Bobとは何か

- finalはなぜASMR専用イヤホンを展開するのか、目指す“音を感じる世界”の拡張

- ナノイー技術で花粉症状を緩和、パナソニックがヒト臨床試験で実証

- テスト実行期間を最大80%短縮する、24時間稼働のAIエージェント

- ロッキード マーティンと富士通、量子やAIなどデュアルユース技術開発を共同加速

- ASMRなどで広がる音楽以外の“音”の世界とイノベーション

- 日立がCIセクターの体制を刷新、新たなセクターCEOにCOOの網谷憲晴氏が就任

- 製造業に求められる人材戦略とは 鍵を握る「スキルデータ管理」

- 平均在庫回転日数を11%削減、ライオンがDX活用でSCM基盤を高度化

コーナーリンク