思い出した音を脳波から復元する技術を開発:医療技術ニュース

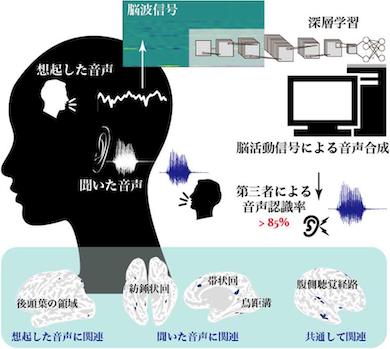

東京工業大学は、頭皮で記録された脳波信号から、音声を直接再構築する手法を開発した。聞いた音声を想起した時に記録されたEEGを利用し、畳み込みニューラルネットワーク(CNN)によって音源のパラメーターを推定した。

東京工業大学は2021年1月8日、頭皮で記録された脳波信号(EEG)から、音声を直接再構築する手法を開発したと発表した。同大学科学技術創成研究院 准教授の吉村奈津江氏らによる成果だ。

今回の研究では、聞いた音声を想起した時に記録されたEEGを利用し、機械学習法の1つである畳み込みニューラルネットワーク(CNN)によって音源のパラメーターを推定した。

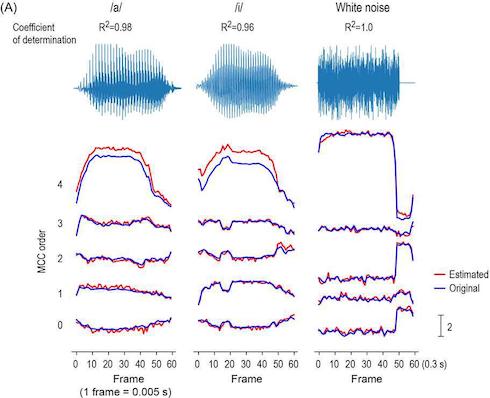

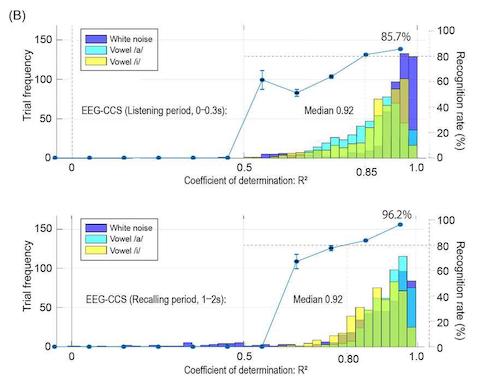

具体的には、32カ所のEGG電極から、2つの母音「ア」「イ」と白色雑音を聞いている時、それらの音を思い出している時の脳波信号を記録し、CNNを用いて音源のパラメーター信号を推定して音源を復元した。復元した「ア」「イ」の音声の聞き取り判別試験では、元の音声を聞いていない人を含む全参加者の8割程度が判別できた。

また、CNNが音源推定に利用した脳の領域を調べたところ、脳内の聴覚処理において何の音かを特定するための信号を処理する「Whatストリーム」という脳領域群であることが判明した。さらに、音を聞いている時と音を思い出した時では、CNNが抽出した脳領域は異なり、個人間の差異も見られた。

近年、脳情報を利用して脳とコンピュータをつなげるブレイン・コンピュータ・インタフェースに関する研究が進められている。音声情報の読み出しでは、皮質脳波信号(ECoG)を利用した音声合成が試されているが、聞き取りやすい音声の合成は困難な状況にある。

今回、聴取性能の高い音声をEEGから再構成できたことで、脳内聴覚や音声、言語処理の客観的な評価に脳波を利用できる可能性がある。他に、脳のどの領域が聴覚、音声、言語処理に関係しているかの理解を深め、ブレイン・コンピュータ・インターフェイスなどの開発につながることが期待される。

- 既存薬が効きにくいがんにも光、BNCT用ホウ素薬剤を開発

- 不公平な提案を受諾する際の脳内抑制メカニズムを解明

- 新型コロナ向け「ワクチン接種パッチ」の実用化へ前進、自己接種も可能に

- なぜPM2.5で花粉症がひどくなる? スズと粘液の反応によるメカニズムを発見

- 先天性の「足の臭い」、長島型掌蹠角化症の原因菌と有効治療法を発表

- ナノイー技術で花粉症状を緩和、パナソニックがヒト臨床試験で実証

- 赤色レーザーダイオードで光合成速度が最大2割向上、植物工場での活用へ

- 健康な社会づくりを目指すミラノ・コルティナ2026とイタリアのAI/サイバー政策

- 卵の段階でひよこの性別を選別する画像認識AIを開発

- 早期乳がんに対する根治的重粒子線治療の有効性と安全性を確認

関連記事

聴覚だけを頼りに音源の位置や動きを判断する時、大脳は2つの情報を個別処理する

聴覚だけを頼りに音源の位置や動きを判断する時、大脳は2つの情報を個別処理する

京都大学は、大脳皮質において、互いに矛盾する2つの聴覚情報は統合して処理するのではなく、別々の状態のまま扱われていることを確認した。 視覚と聴覚で異なる時間判断の仕組みの一端を解明

視覚と聴覚で異なる時間判断の仕組みの一端を解明

産業技術総合研究所は、脳内の処理時間や処理経路の異なる感覚情報がどのように統合されて主観的な現在が構築されるのか、その仕組みの一端を明らかにした。 薬の濃度・効果を生きた動物の脳や内耳からリアルタイムに計測するセンサー

薬の濃度・効果を生きた動物の脳や内耳からリアルタイムに計測するセンサー

新潟大学は、針状のダイヤモンド電極センサーを用いた薬物モニターシステムを開発し、生きた動物の脳や内耳の狭い空間でのさまざまな薬の濃度と作用をリアルタイム計測することに成功した。 1秒以下の短い時間を知覚・判断するメカニズムを解明、時計は脳の右半球に

1秒以下の短い時間を知覚・判断するメカニズムを解明、時計は脳の右半球に

九州大学は、聴覚の錯覚を用いて時間知覚/判断に対応するヒト脳内での神経活動を解明し、ネットワークモデルを提唱したと発表した。新しいリアルタイム処理技術や、脳機能診断検査への応用が期待される。 タンパク質の動きを捉える世界最小の人工バネ

タンパク質の動きを捉える世界最小の人工バネ

理化学研究所は、世界最小のコイル状人工バネ「ナノスプリング」を開発し、それを用いて聴覚に関わるメカノセンサータンパク質の動きを捉えることに成功した。タンパク質に力を加えながら、分子構造や動態を観察できる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

医療機器の記事ランキング

- おむつかぶれや尿路感染を防ぐ、体外式カテーテルに新製品

- 3DとAIで数十万の細胞を解析する「自律型デジタル細胞診」システムを開発

- 既存薬が効きにくいがんにも光、BNCT用ホウ素薬剤を開発

- 「入れ歯」専用の次世代3Dプリンタ、2027年市場投入へ

- 減らすだけでは効果なし、完全禁酒/禁煙で食道がん治療後の発生リスクが5分の1に

- 不公平な提案を受諾する際の脳内抑制メカニズムを解明

- 対象所見を10種類に拡充した胸部単純X線画像病変検出ソフトの提供を開始

- 体温の日内制御、恒温動物と変温動物で共通の仕組みを発見

- 新型コロナ向け「ワクチン接種パッチ」の実用化へ前進、自己接種も可能に

- なぜPM2.5で花粉症がひどくなる? スズと粘液の反応によるメカニズムを発見

コーナーリンク