CPUで動く超軽量モデルも、NTTが国産LLM「tsuzumi」を2024年3月から商用化:人工知能ニュース(2/2 ページ)

小規模なLLM同士が連携する未来を

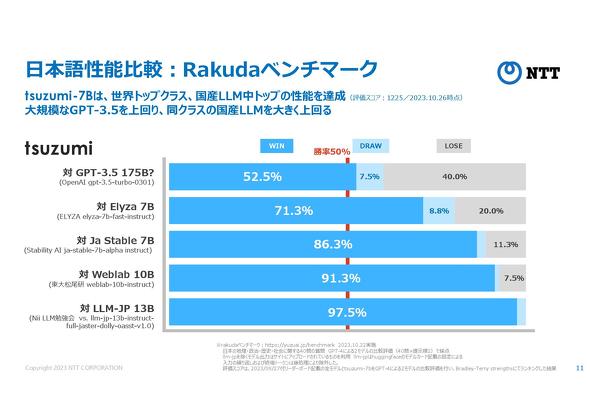

tsuzumiのもう1つの特徴が、高い日本語処理性能だ。LLMの日本語処理性能に関するベンチマークテスト「Rakuda Benchmark」で計測したところ、「GPT-3.5」の他、「Elyza」など他の国産LLMのスコアを上回る結果が得られた。このことから、日本語処理性能に関して「世界トップクラス」(NTT)の性能を実現したとしている。

Rakuda Benchmarkが「GPT-4」を活用した測定方法を採用していることから、tsuzumiとGPT-4の性能比較は難しい面がある。その上でNTT 執行役員 研究企画部門長の木下真吾氏は「GPT-4の性能はかなり高い。現時点でGPT-3.5と互角なので、今後はGPT-4に向けてさらに性能を向上させる」と語った。

なお、tsuzumiの小型版は日本語だけでなく英語でも、MetaのLLM「LlaMa2」(70億パラメーター)と同等の処理性能を発揮している。NTTは今後、中国語、韓国語、フランス語、ドイツ語に加えて、プログラミング言語への対応をさらに進めていく方針だ。

小規模なモデルでありながら高パラメーターのモデルとそん色ないパフォーマンスを発揮する理由について、木下氏は「同じ日本語のデータを学習させるにしても、単語の区切り方などでモデルの性能は大きく変わってくる。インストラクションチューニングの段階で適切に処理したデータを与えることで、小型なモデルでも大規模なLLMと同等の性能を発揮できる。こうした処理には、形態素データの研究で大量の知見を持つ当社の強みが生かされている」と説明した。

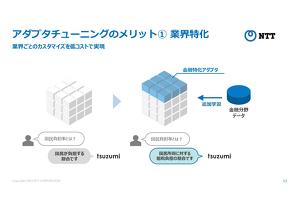

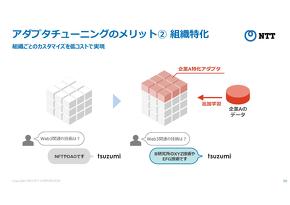

tsuzumiの小型版ではプロンプトエンジニアリングやファインチューニングに加えて、追加学習によるチューニングも可能だ。特定の業界データや部門ごとの社内データを追加学習させることで、特化型のモデルを作成できる。さらに言語だけでなく、請求書や仕様書、図版など、文書が記載された画像を使って質問することも可能だ。音声認識による質問にも対応する。

今後、超小型版と小型版に加えて、130億パラメーター以上を持つ「中型版」も開発する計画がある。1つの基盤モデル上で複数の追加学習データを搭載できるマルチアダプター機能を搭載する。さらにtsuzumiのマルチモーダル性を拡張して、ユーザーの置かれた状況に応じて応答する機能なども導入していく予定だ。中型版のリリースは2024年4月以降を見込む。

tsuzumiの商用サービスはNTTグループ各社が顧客ニーズに合わせたソリューション形式で国内企業を対象に展開していく。2027年までにtsuzumiによる収益のみで1000億円の売り上げを目指す。一部、コールセンター機器メーカーなどには個別にtsuzumiを提供する形となる。

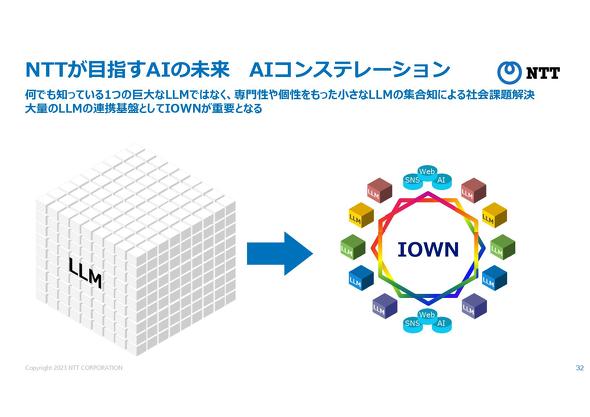

木下氏は「何でも知っている1つの巨大なLLMを作るのではなく、高い専門性を備えた小規模のLLMを複数集めて有機的に組み合わせる。これによってLLM間で意見交換しながら、最適解を導いて大きなタスクを解決できる、人間の社会のような仕組みを作っていきたい」と展望を語った。

関連記事

NECが国産生成AIを初めて一般公開、日本語LLMのデモンストレーションを実施

NECが国産生成AIを初めて一般公開、日本語LLMのデモンストレーションを実施

NECは、「CEATEC 2023」において、独自の生成AIにおける日本語大規模言語モデルを出展しデモンストレーションなどを披露した。NECが独自の生成AIを一般向けに公開したのはCEATEC 2023が初だという。 NTTがIOWN初のサービス実用化へ、光回線で従来比200分の1の低遅延通信を実現

NTTがIOWN初のサービス実用化へ、光回線で従来比200分の1の低遅延通信を実現

NTTは2022年11月14日、光ベースの技術によるネットワーク構想「IOWN」について、サービス第1弾として「IOWN1.0」を2023年3月から提供開始すると発表した。 製造業でも使える国産LLM搭載の業務支援AIサービス、β版を提供開始

製造業でも使える国産LLM搭載の業務支援AIサービス、β版を提供開始

AI insideは2023年8月3日、自社開発の大規模言語モデルを搭載したAIエージェント「Heylix」をクローズドβ版として提供開始すると発表した。 利用回数は想定の5倍超、ChatGPT全社導入から3カ月でのパナソニック コネクトの利用実績

利用回数は想定の5倍超、ChatGPT全社導入から3カ月でのパナソニック コネクトの利用実績

パナソニック コネクトは2023年7月3日、OpenAIの大規模言語モデル(LLM)をベースに開発、導入したChatGPTライクのAIアシスタントサービス「ConnectAI」の活用実績と今後の展開について発表した。 生成AIがIoTデータに基づき現場業務を支援、必要な情報が「一発で手に入る」ツール

生成AIがIoTデータに基づき現場業務を支援、必要な情報が「一発で手に入る」ツール

IoTデータの収集、可視化ツールを展開するMODEは、2023年6月にデモ版として「BizStack AI」を発表した。対話型生成AIを活用しており、現場作業者からの自然言語での問いかけに対してIoTデータに基づく回答を生成して、返答する。 製造業の生成AI活用に3つの道筋、製造現場などでの活用事例を探る

製造業の生成AI活用に3つの道筋、製造現場などでの活用事例を探る

最も大きな注目を集めるワードの1つである「生成AI」。製造業ではどのように役立てられるのだろうか。活用事例を幾つか取り上げるとともに、製造現場などでの活用事例を探る。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

製造マネジメントの記事ランキング

- 生産性100倍に、富士通がソフトウェア開発をAIエージェントで自動化する開発基盤

- 従業員のスキルに応じた「ランク認定制度」も 三菱電機が推進するDX人材育成施策

- 日本は本当に遅れているのか? AI×現場力で始まる日本型モノづくりの逆襲

- 「好きなことは楽しめる間にとことん楽しむ」という考え方の重要性について

- アイリスオーヤマなど、無線制御技術を軸に建設業界の課題解決に向けた協業開始

- IOWN APNと画像認識AIにより、約300km離れた工場での外観検査に成功

- AIエージェントが代わりに働くようになったら人は何をするの?

- 永守氏がニデック完全退任、「経営者としての私の物語にピリオド」

- パナソニックは新技術拠点「Technology CUBE」で“実装力のあるR&D”を強化

- 富士フイルムBIがトルコ企業を買収、基幹システム導入の海外展開加速

コーナーリンク