CPUで動く超軽量モデルも、NTTが国産LLM「tsuzumi」を2024年3月から商用化:人工知能ニュース(1/2 ページ)

NTTは2023年11月1日、独自開発の大規模言語モデル(LLM)「tsuzumi(つづみ)」の開発を発表した。同月より社内外でトライアルを開始し、2024年3月から商用サービスを開始する計画だ。

日本電信電話(NTT)は2023年11月1日、独自開発の大規模言語モデル(LLM)「tsuzumi(つづみ)」の開発を発表した。同月より社内外でトライアルを開始し、2024年3月から商用サービスを開始する計画だ。

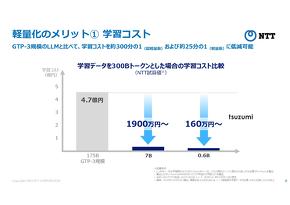

学習コストを約300分の1に

tsuzumiはモデルの“軽さ”と日本語処理性能の高さなどを特徴とする国産LLMだ。名前は和楽器の「鼓(つづみ)」に由来する。

Web上で公開されている日本語や英語など1兆以上のトークン数を持つデータで事前学習を行った。その後、インストラクションチューニングの段階で、NTTが蓄積してきた翻訳や要約、対話、読解などのタスクに関する内製データや、LLMの安全性などを確保するためのデータを用いた学習を行うことで、軽量でありながら高パフォーマンスを発揮するLLMを開発できたという。

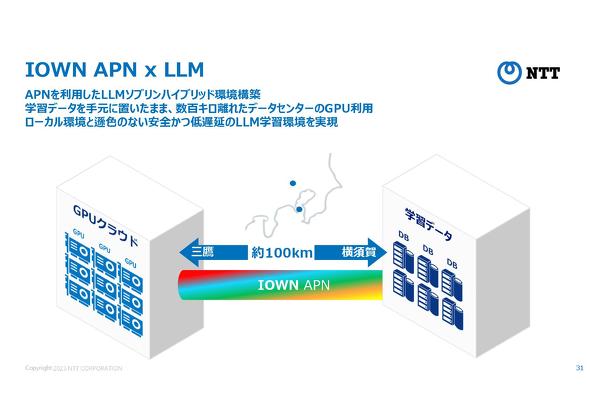

なおモデルの学習は、光ネットワーク構想「IOWN」に関わる通信基盤「APN(All Photonics Network)」を用いて、横須賀研究開発センタ(神奈川県横須賀市)のデータベースに保管されている学習データを、武蔵野研究開発センタ(東京武蔵野市)の研究所のGPUクラウドにつないで実行した。これによってセキュアかつ低遅延の通信環境を実現し、「ローカル環境とそん色ない学習環境」(NTT)を構築した。

今回発表したtsuzumiのモデルは、6億パラメーターの「超小型版」と70億パラメーターの「小型版」の2種類で、OpenAIが開発した「GPT-3」(1750億パラメーター)などと比較するとパラメーター数が抑えられている。超小型版はCPUで、小型版はGPU1基でそれぞれ動作可能だ。両者は対応可能なタスクの幅、言語、チューニング方法が異なる。

モデルの小型化は学習/推論コストの削減につながる。NTTの試算では、仮に学習データを3000億トークンとした場合、GPT-3と比較して、超小型版はCPUクラウド利用時の学習コストを約300分の1、推論コストを約70分の1にそれぞれ抑えられる可能性があるという。学習時の消費電力も軽減可能だ。GPT-3相当のモデル規模のLLMは、1回当たりの学習で約1300MWhを消費するといった試算がある。消費電力の削減によってサステナビリティへの貢献も期待できる。

Copyright © ITmedia, Inc. All Rights Reserved.

製造マネジメントの記事ランキング

- 生産性100倍に、富士通がソフトウェア開発をAIエージェントで自動化する開発基盤

- 従業員のスキルに応じた「ランク認定制度」も 三菱電機が推進するDX人材育成施策

- 日本は本当に遅れているのか? AI×現場力で始まる日本型モノづくりの逆襲

- 「好きなことは楽しめる間にとことん楽しむ」という考え方の重要性について

- パナソニックは新技術拠点「Technology CUBE」で“実装力のあるR&D”を強化

- アイリスオーヤマなど、無線制御技術を軸に建設業界の課題解決に向けた協業開始

- IOWN APNと画像認識AIにより、約300km離れた工場での外観検査に成功

- AIエージェントが代わりに働くようになったら人は何をするの?

- 永守氏がニデック完全退任、「経営者としての私の物語にピリオド」

- 「中国のスペースX」銀河航天は衛星をどう量産するのか 製造デジタル基盤の全貌

コーナーリンク