ルネサスは自動運転で出遅れたのか、「オセロの論理で四隅からひっくり返す」:車載半導体 ルネサス インタビュー(2/3 ページ)

ルネサスもエッジ型の人工知能に取り組む

MONOist 緊急時も含めてシステムが制御するレベル4の自動運転では、コックピットはどう変わるか。

吉田氏 レベル4の自動運転システムが乗用車に搭載されることを想定すると、ドライバーが運転行動をとる必要がほぼなくなるので、HMI(ヒューマン・マシン・インタフェース)自体の考え方が変わるだろう。

乗員が全く運転しないケースでは、エンターテインメントだけが必要になるかもしれないが、何らかのシチュエーションで運転がドライバーに交代するタイミングでは、スパッと切り替えられるかが焦点だ。運転にスムーズに復帰するため、見るべき情報を指示できるかがコックピットの重要な役割になる。

レベル2まではストレスのない制御が課題になるが、それ以降のレベルはクルマに知性が求められる。クルマがドライバーを導くガイドを務めるためだ。われわれが提供するプラットフォームが人工知能(AI)で知性を提供し、ドライバーはそれと対等にコミュニケーションをとることで自動運転システムの安全性を担保できるのではないか。

MONOist それは画像認識などに用いられているディープラーニングを応用したAIになるのか。

吉田氏 より広い概念のAIのアーキテクチャになるだろう。それは次世代のR-Carで実現していく。エッジ側のAIをR-Carで将来目指していく。もちろんクラウド型AIとも連携する。

自動運転開発、競合から出遅れてはいない

MONOist Audi(アウディ)は2017年中に製品化するレベル3の自動運転を、NVIDIA(エヌビディア)と共同開発した。先を越された格好か。

吉田氏 これまでにも、アウディと自動運転などについて話し合っているが、われわれは1つのモデルでの採用・不採用にはこだわっていない。社会や世界が変わる中で、多数派をとれることが重要だと考えており、その意味では負けていない。

クルマが変化していく中で、われわれの提案の内容はかなりの自動車メーカーから評価されている。局地戦ではいろいろあるかもしれないが。多数派になりイニシアチブを取れるかどうかに目を向けている。

社内でよく例に出すのがオセロだ。われわれは四隅を狙う。途中、相手が優勢だったとしても、隅を取れば一気にひっくり返せる。われわれが目指すのはそういうことだ。

MONOist 自動車メーカーから何が評価されているのか。

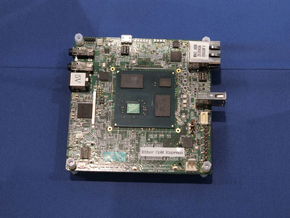

吉田氏 2017年1月のCESで披露した自動運転車が好評だった。前回のCESでは周辺監視システムを車両に搭載して紹介したが、今回は敷地内にコースを設けて走る・曲がる・止まるを実演した。車両には、ライダー、カメラ、R-Carを搭載した。RH850がCANネットワークにコマンドを送る構成だ。処理を担うのは「HADソリューションキット」2台で、R-Carが合計4つ搭載されている。アルゴリズムは、カナダのウォータールー大学の学生と共同開発した。学生3人が3カ月弱でクルマを走らせた。OSはQNXだ。

MONOist 具体的にどのような機能を実現したのか。

吉田氏 まずは前のクルマに追従し、距離を正確に保つこと。路車間通信(V2I)で信号と連携し、信号の青・赤を基に発進、停止した。画像認識技術を用いた標識の検知も行った。評価されたのは、フェイルオペレーションの仕組みだ。4つのR-Carのうち、センサーフュージョンに使用する3つで多数決を行う。2つだと互いの判断が異なった時に決断を下せないが、3つあれば多数決で決められる。また、何らかの形で1つが止まっても自動的に路肩に止まれるようにする。

さまざまな路面状況に対応して検知することは課題ではある。車両の挙動もまだまだだが、挙動の味付けは自動車メーカーの領域だ。半導体メーカーとして、フェイルオペレーションの仕組みをしっかりと整備することで、安全を担保する役割は果たせたと考えている。

運転の質感の作り込みにティア1サプライヤや自動車メーカーに集中してもらううための開発環境やプラットフォームをつくっていかなければならない。自動運転に必要なコンピュータまではルネサスが作り、実際の挙動のスムーズさや安心感を作り込むことに集中できるように役割分担が変わっていく。半導体プラットフォームとして何が求められているか、期待に応えて提供していく。単純にPCの環境を持って行って「使ってください」というのでは終わらない話だ。

Copyright © ITmedia, Inc. All Rights Reserved.

モビリティの記事ランキング

- ローム買収を検討するデンソーは半導体メーカーになり切れるのか

- EV普及は“移動の不安解消”が鍵 ホンダは2030年に向けEV充電器を数千口へ拡大

- 旅客船の「レベル4相当」自律運航の実力は? 操船ブリッジかぶりつきレポート

- スズキがカナデビアの全固体電池「AS-LiB」事業を買収、宇宙機向けで実績

- 三菱マヒンドラ農機が会社清算へ、創業から112年の歴史に幕

- ホンダが米国生産車を日本に導入、2026年後半に「インテグラ」と「パスポート」

- ヤマハ発動機が原付二種に初のファッションモデル「Fazzio」投入、シェア拡大へ

- 2040年のxEV向け駆動用電池市場は2024年対比2.6倍に拡大

- 自動車産業の新たな競争構図は「フィジカルAIカー」対「エンボディドAIカー」へ

- ホンダが着脱式バッテリーを搭載した原付一種の電動二輪車を発売

コーナーリンク