デンソーがクルマに載せられるAIの開発に注力、「かなり早めに出せる」:クローズアップ・メガサプライヤ(3/3 ページ)

「組み込み機器向け機械学習高速演算プラットフォーム」

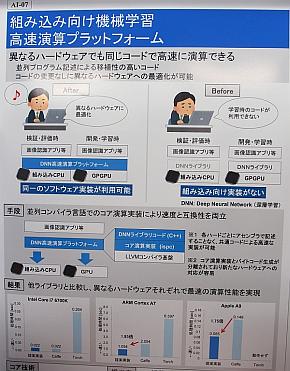

3つ目は「組み込み機器向け機械学習高速演算プラットフォーム」だ。DNNを用いた機械学習で構築したアルゴリズムのソフトウェアコードは、機械学習の際に用いたとの同じGPU上であれば、機械学習に用いたDNNライブラリによってそのまま実行することができる。しかし、車載情報機器などに搭載されているARMのアプリケーションプロセッサでは、DNNライブラリがない上に、メモリや演算能力が不足していることもあって、そのまま組み込んで実行することができない。アセンブラで記述し直せば動作させることは可能だが、その場合開発には膨大な手間が掛かる。

デンソーが開発した「DNN高速演算プラットフォーム」は、GPUによる開発/機械学習時だけでなく、アプリケーションプロセッサを用いた検証/評価時でも、同一のソフトウェアコードを利用できるようにするためのものだ。並列コンパイラ言語でのコア演算実装によって速度と互換性を両立した。

C++ベースのDNNソフトウェアコードを用いて、開発したプラットフォームと他のDNNライブラリの演算性能を、異なるアプリケーションプロセッサ上で比較した結果では、全てにおいて同プラットフォームが最速という結果が得られた。特に、車載情報機器に用いられているARMのアプリケーションプロセッサとしては最小規模ともいえる「Cortex-A7」では、DNNライブラリとして広く用いられているCaffeと比べて2倍近い処理速度を実現できたという。「ルネサスのミドルレンジの車載情報機器向けプロセッサの開発ボードであれば、十分な速度で利用できると考えている」(同社の説明員)。

デモでは、「iPhone 6s」に同プラットフォームとC++ベースのDNNソフトウェアコードによるアルゴリズムにより、100ms(10fps)程度の処理速度で約1000種類の動物を認識できることを示した。

「ニューロコンピューティング」

ここまでの3つのデモは、実用化までにそれほど時間はかからない、事業部での採用が比較的近い技術だ。常務役員の加藤氏は、上記の3つを含めた今回のデモについて、具体的な時期は示さなかったものの「1つを除いて、かなり早めに出せる」と強調した。

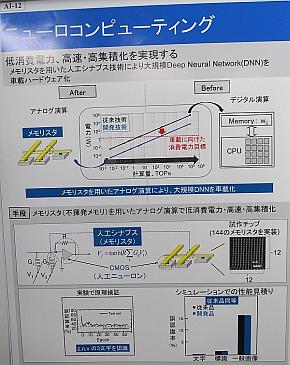

DNN関連のデモの4つ目は、加藤氏が「1つを除いて」と言ったものであり、現時点では研究段階にある「ニューロコンピューティング」だ。

ニューロコンピューティングは、脳の電気的な振る舞いを模した回路や素子によってニューラルネットワークを構成する新しい情報処理手法である。デンソーは、不揮発メモリの1つであるメモリスタを用いた人工シナプスと、CMOS素子を用いた人工ニューロンにより、大規模DNNの大幅な低消費電力化と高速/高集積化を目指している。

現在は、カリフォルニア大学サンタバーバラ校と共同して、12×12のマトリックスで144のメモリスタを実装した試作チップと別のプリント基板に実装したCMOSスイッチを1層分とし、これを2層つなげた回路によって「z」「n」「v」「a」という文字を認識する実験を行っている。

先に挙げた3つのDNN関連のデモは、画像認識のアルゴリズムを自動運転車に実装することを目的としたものだ。しかし、自分で考え判断するような学習機能を持つ、より高度なAIを搭載するとなると、半導体の消費電力は数百Wに達する可能性がある。デンソーのニューロコンピューティングは、メモリスタとCMOSを用いたアナログ演算によって従来のデジタル演算と比べて消費電力を2桁削減し、数W以内に抑えられる可能性がある。「概念実証はこれでできたと考えている。メモリスタとCMOSの集積など、実用化には課題も多いが、今後も研究開発を進めたい」(同社の説明員)という。

なお、DNN関連ではないデモも2つ用あった。ドライバーとクルマが会話することにより自動駐車シーンを体験できる「Human Agent Interface(HAI)」と、従来の機械学習の手法である線形識別器を用いた汎用物体認識ソフトウェア「SPADE」である。

関連記事

世界を変えるAI技術「ディープラーニング」が製造業にもたらすインパクト

世界を変えるAI技術「ディープラーニング」が製造業にもたらすインパクト

人工知能やディープラーニングといった言葉が注目を集めていますが、それはITの世界だけにとどまるものではなく、製造業においても導入・検討されています。製造業にとって人工知能やディープラーニングがどのようなインパクトをもたらすか、解説します。 人工知能は製造現場でどう役に立つのか

人工知能は製造現場でどう役に立つのか

人間の知的活動を代替するといわれる人工知能が大きな注目を集めている。ただ、製造現場で「使える」人工知能は、一般的に言われているような大規模演算が必要なものではない。「使える人工知能」に向けていち早く実現へと踏み出しているファナックとPFNの取り組みを紹介する。 「コンパクトな人工知能」実現へ、組み込み機器でディープラーニング

「コンパクトな人工知能」実現へ、組み込み機器でディープラーニング

三菱電機がディープラーニングを組み込み機器単体でも実用可能なものとする手法を開発。自動車や産業用ロボット、監視カメラなどへの「人工知能」搭載を進める。 製造業で人工知能はどう使うべきなのか

製造業で人工知能はどう使うべきなのか

日本IBMとソフトバンクは、自然対話型人工知能「ワトソン(Watson)」の日本語版の提供を開始する。自然言語分類や対話、検索およびランク付け、文書変換など6つのアプリケーションをサービスとして展開する。 「学び続ける小さな人工知能」を実現する、組み込みボード「NVIDIA Jetson TX1」

「学び続ける小さな人工知能」を実現する、組み込みボード「NVIDIA Jetson TX1」

NVIDIAは開発プラットフォーム「NVIDIA Jetson TX1」の国内販売を開始する。GPUによる画像処理はもちろんのこと、CUDAプラットフォームを利用することで実機にデプロイした後も学び続けるディープラーニングを構築できる。

Copyright © ITmedia, Inc. All Rights Reserved.

モビリティの記事ランキング

- EV普及は“移動の不安解消”が鍵 ホンダは2030年に向けEV充電器を数千口へ拡大

- 旅客船の「レベル4相当」自律運航の実力は? 操船ブリッジかぶりつきレポート

- ローム買収を検討するデンソーは半導体メーカーになり切れるのか

- スズキがカナデビアの全固体電池「AS-LiB」事業を買収、宇宙機向けで実績

- 三菱マヒンドラ農機が会社清算へ、創業から112年の歴史に幕

- ホンダが米国生産車を日本に導入、2026年後半に「インテグラ」と「パスポート」

- ヤマハ発動機が原付二種に初のファッションモデル「Fazzio」投入、シェア拡大へ

- 2040年のxEV向け駆動用電池市場は2024年対比2.6倍に拡大

- 自動車産業の新たな競争構図は「フィジカルAIカー」対「エンボディドAIカー」へ

- ホンダが着脱式バッテリーを搭載した原付一種の電動二輪車を発売

コーナーリンク