三菱電機が2つの技術でエッジ動作可能なLLMを高精度化、2026年度にも製品適用へ:人工知能ニュース(2/2 ページ)

製造業向け言語モデルを実現した2つの技術の詳細

今回開発した製造業向け言語モデルを実現した2つの技術の詳細は以下のようになっている。

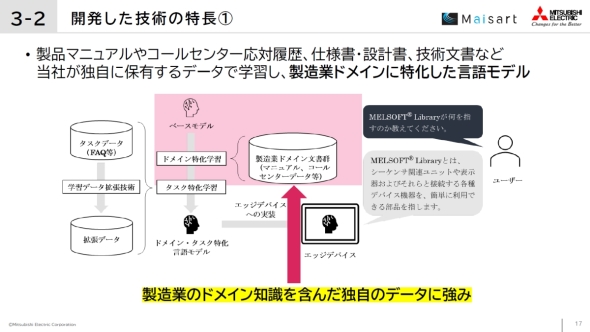

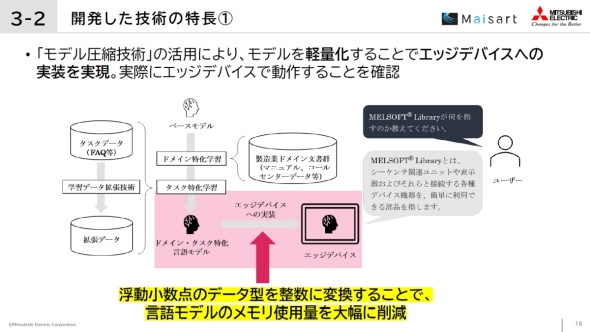

1つ目の製造業固有の知識を学習させるドメイン特化学習とAIモデルの軽量化では、国立情報学研究所を中核に三菱電機も参加しているLLM勉強会が開発するパラメーター数18億のLLMをベースに、製品マニュアルやコールセンター応対履歴など三菱電機が独自に保有する権利的/倫理的に問題のないデータで学習することで、製造業ドメインに特化したLLMを開発した。その上で、浮動小数点のデータ型を整数に変換する量子化などのモデル圧縮技術を活用して、LLMの精度を保ったままメモリ使用量を大幅に削減することに成功した。

これにより、メモリ不足で実行不可能だったエッジデバイスでも動作可能であることを確認した。エッジデバイスで完結してLLMを処理できるので、低遅延かつプライバシーに配慮した処理が可能となり、スマートファクトリーやエッジロボティクス、エネルギー制御など多様な分野において、ユーザーの生成AI運用にかかる各種コスト削減に貢献できるようになるという。

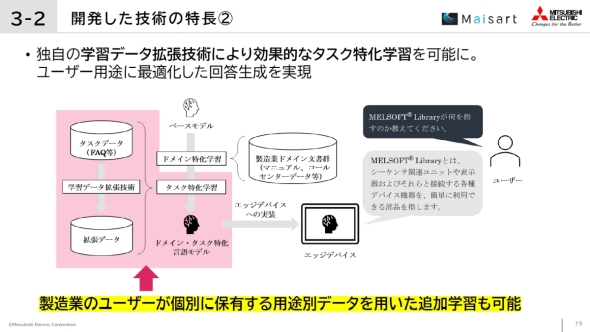

ただし1つ目の技術だけでは、現場での実運用に対応可能なLLMとして十分な精度を確保できているとはいえない。そこで、LLMの精度をさらに高める2つ目の技術として開発したのが、効果的なタスク特化学習を可能にする独自の学習データ拡張技術である。

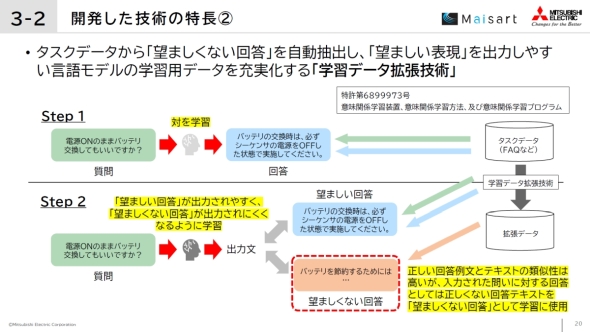

タスク特化学習の第1段階としては、問い合わせや文章生成指示などの入力内容に対して「望ましい回答」がひも付けられているFAQなどの各ユーザーが有しているタスクデータを用いて学習を行う。そして第2段階として、このタスクデータを基に、正しい回答例文とテキストの類似性は高いものの、入力された問いに対する回答としては正しくない回答テキストを拡張データとして抽出する。その上で、この拡張データを同一入力に対する「望ましくない回答」と見なすことで、ある入力に対する「望ましい回答」と「望ましくない回答」のペアを疑似的に自動生成し、「望ましい回答」が出力されやすく、「望ましくない回答」が出力されにくくなるような学習を行う。この第2段階の学習を行うのに開発したのが、独自の学習データ拡張技術である。

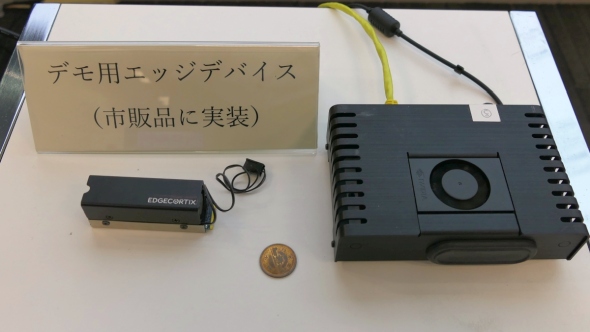

会見では、Jetson AGX Orin Nano 8GBに実装した製造業向け言語モデルを用いたデモを披露した他、より小型のエッジデバイスの事例として、エッジコーティックス(EdgeCortix)のAIアクセラレータ「SAKURA-II」も展示した。また、産業用PCなどに用いられるインテルやAMDのx86系CPUは、WindowsのAI機能である「Copilot+ PC」に対応するためAI処理性能を大幅に高めており、これらも製造業向け言語モデルを実装するエッジデバイスのターゲットになり得るという。

三菱電機は、今回の開発成果を基に、産業機器やロボットなどのデバイス上で言語モデルを動作させるユースケースの検討と社内外の実機検証を進め、2026年度までの製品適用を目指す。

なお、今回の製造業向け言語モデルは、アマゾン ウェブ サービス ジャパンが提供する「AWSジャパン生成AI実用化推進プログラム」に参画し、同社のサポート(言語モデルの学習に必要なGPUや「AWS Trainium」などのコンピューティングリソースの調達支援、分散トレーニングの環境構築支援、AWSクレジットの提供、AWS生成AIイノベーションセンターによる科学的観点からのアドバイザリーなど)の下で開発したという。

関連記事

エッジにも浸透する生成AI、組み込み機器に新たな価値をもたらすか

エッジにも浸透する生成AI、組み込み機器に新たな価値をもたらすか

生成AIが登場して2年以上が経過しエッジへの浸透が始まっている。既にプロセッサやマイコンにおいて「エッジAI」はあって当たり前の機能になっているが、「エッジ生成AI」が視野に入りつつあるのだ。 シャープがエッジAI「CE-LLM」の展開を加速、「B2BとB2Cで四半期に1つ以上投入」

シャープがエッジAI「CE-LLM」の展開を加速、「B2BとB2Cで四半期に1つ以上投入」

シャープは、2025〜2027年度の中期経営計画(中計)を支えるエッジAI技術「CE(Communication Edge)-LLM」について説明した。 3回目を迎えたマイコンでAIパビリオン、省電力MPUのエッジ生成AIもあるよ!

3回目を迎えたマイコンでAIパビリオン、省電力MPUのエッジ生成AIもあるよ!

「第9回 AI・人工知能EXPO【春】」の「小さく始めるAIパビリオン」に、AIスタートアップのエイシング、インフィニオン、STマイクロ、NXP、ヌヴォトン テクノロジー、ルネサスが出展し、マイコンをはじめ省電力のプロセッサを用いたAI活用に関する展示を披露した。 「Jetson Orin Nano」のAI処理性能が70%向上、開発者キットの価格も半額に

「Jetson Orin Nano」のAI処理性能が70%向上、開発者キットの価格も半額に

NVIDIAは、組み込み機器向けAIモジュール「Jetson Orin Nano」の開発者キットについて、AI処理性能が従来比で70%増となる67TOPSに向上した「Jetson Orin Nano Super開発者キット」を発表した。価格も従来の499米ドルから半額となる249米ドルに値下げする。 “エッジ生成AI”に挑む日本発スタートアップ、60TOPSのAI処理性能を8Wで実現

“エッジ生成AI”に挑む日本発スタートアップ、60TOPSのAI処理性能を8Wで実現

生成AIへの注目が集まる中、その生成AIを現場側であるエッジデバイスで動かせるようにしたいというニーズも生まれつつある。この“エッジ生成AI”を可能にするAIアクセラレータとして最大AI処理性能60TOPS、消費電力8Wの「SAKURA-II」を発表したのが、日本発のスタートアップであるエッジコーティックスだ。 クアルコムのSoCに独自LLMを組み込み、エッジ生成AIでIoT事業の成長を加速

クアルコムのSoCに独自LLMを組み込み、エッジ生成AIでIoT事業の成長を加速

サンダーソフトジャパンは、中国サンダーソフトと米国クアルコムの両社が合弁でSOM製品を中心としたIoT向けプラットフォームを展開しているサンダーコムの事業について説明した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- 月面を照らす「光の物差し」 JAXAとカシオが可視光測位技術を実証

- 生成AI実行時の消費電力が10W以下に SiMa.aiのSoC「Modalix」の実証結果を公開

- 1μF以下の極小コンデンサーでも安定動作する500mA対応LDOレギュレーター

- フォックスコンがフィジカルAIで実現する「AX」とは、NVIDIAと川崎重工も講演

- 衛星通信向け量子鍵配送送受信システムの小型化と高速化に成功

- いまさら聞けないエッジAIとクラウドAIの違い “現場処理回帰”の必然性とは

- 高速起動とREST APIで高性能なデータ取得を自動化する測定コア

- 時代はDXからAIが当たり前に浸透する「IX」に突入へ CES 2026の内容をひもとく

- 愛猫の不調を見逃さない、LIXILが非接触呼吸計測デバイスを開発

- 現場や事務用途で快適に使える防塵防水対応の10.1型タブレットPCを発売

コーナーリンク