パナソニックHDがマルチモーダルAIの生成速度を倍増、拡散モデルの適用で:人工知能ニュース(1/2 ページ)

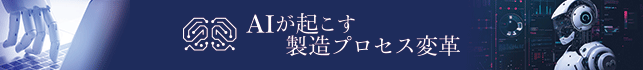

パナソニックHDは、拡散モデルを応用し、従来比約2倍の生成速度を実現したマルチモーダルAI「LaViDa」を開発。従来の自己回帰型LLMが抱える生成遅延や全体制御の弱さを、独自の高速化技術で克服した。

パナソニック ホールディングス(パナソニックHD)とパナソニックR&Dカンパニー オブ アメリカ(PRDCA)は2025年11月27日、UCLA(カリフォルニア大学ロサンゼルス校)の研究者らと共同で、深層学習モデルの一つである拡散モデル(Diffusion Model)を用いたマルチモーダルAI(人工知能)「LaViDa」を開発したと発表した。

画像生成のモデルをテキスト生成へ応用

今回開発したLaViDaの最大の特徴は、拡散モデルを基盤とすることにより、従来の自己回帰モデル(Autoregressive Model」を基盤とする場合と比較して、画像と言語の双方を扱いつつ約2倍の文章生成速度を達成した点にある。

現在、生成AIではデータベースの情報を検索して回答を生成するRAG(検索拡張生成)が主流となっている。このRAGにおいて、最終的な出力を担うジェネレーター(生成器)として広く採用されているのが自己回帰モデルであり、OpenAIの「ChatGPT」や「GPT-4」もこれに当たる。自己回帰モデルは、与えられた入力に対してトークン(単語)を「左から右へ」順番に予測、生成する手法だ。しかし、このモデルは文章量に比例して計算量が増大し、生成に時間を要するという課題がある。また、先頭から順番に生成するために、全体像の把握が苦手であり、文章全体の整合性を取ることや特定の形式に当てはめた生成を苦手としている。

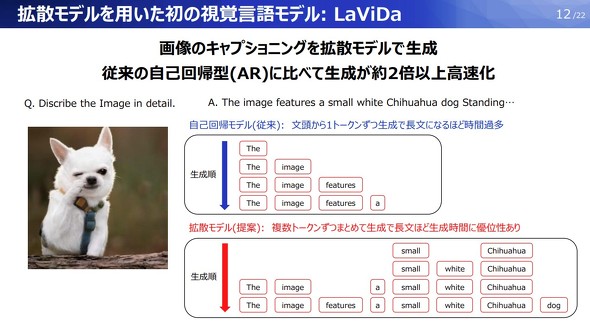

今回、LaViDaに採用した拡散モデルは、主に画像生成でよく使われる手法である。ノイズが付加されたランダムな状態から段階的にノイズを取り除くことで、精巧なデータを生成する。具体的には、文章を構成するトークンの一部をランダムに「マスクトークン」へ置き換え、そこから元のトークンを復元する処理(アンマスキング)を繰り返すことで文章を生成する。LaViDaの開発ではこの手法をテキスト生成に応用した。

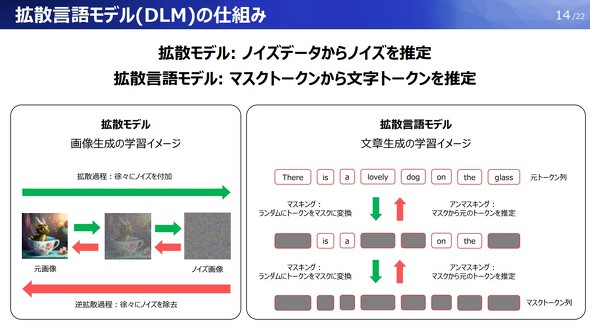

しかし、拡散モデルをテキスト生成に適用する場合、文章全体のトークンを参照して相互関係を計算する必要があるため、推論処理が重くなるという課題がある。また、画像の説明文生成において、文脈上重要な単語が学習されないというリスクも存在した。

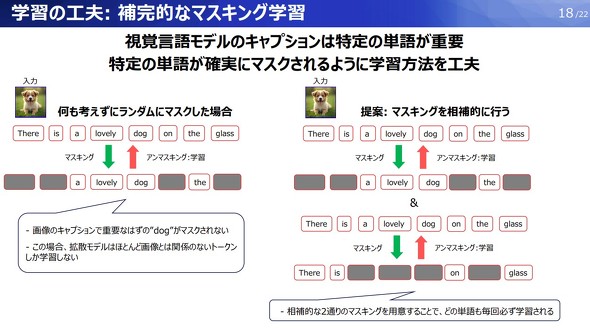

これらの課題に対し、同社は独自のアルゴリズムにより解決を図った。まず、生成するトークンのうち、入力画像と質問文に関するトークンを固定することで、拡散モデルの計算対象から除外するようにした。固定したトークンは変化する必要がないため、常に固定のキャッシュを保持しておくことで、計算処理を効率化している。学習精度の面では、同一の文章に対して互いに補完しあう2パターンのマスキングを使っている。双方のパターンで復元処理を学習させることで、特定の単語が確実に学習されるような仕組みを構築した。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- チップレットでASIL Dを支援する車載SoC技術を開発

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

コーナーリンク