リコーが130億パラメーターの日英対応LLM開発 AWSジャパンの支援プログラム活用:人工知能ニュース

AWSジャパンは2024年1月31日、国内に拠点を持つ企業や団体を対象に、大規模言語モデル開発を支援する「AWS LLM 開発支援プログラム」の成果発表会を開催した。同プログラム参加者のうち、NTTとリコー、ストックマートが登壇し、成果を紹介した。3者の発表内容を順に紹介する。

AWSジャパンは2024年1月31日、国内に拠点を持つ企業や団体を対象に、大規模言語モデル(LLM)開発を支援する「AWS LLM 開発支援プログラム」の成果発表会を開催した。同プログラム参加者のうち、NTTとリコー、ストックマークが登壇し、成果を紹介した。3者の発表内容を順に紹介する。

17社が参加した国産LLM開発支援プログラム

AWS LLM 開発支援プログラムは参加者に対して、AWSの各種サービスや技術ガイダンスの提供などを通じてLLM開発を支援するものだ。AWSの日本法人であるAWSジャパンがグローバルでも独自の施策として展開する取り組みとなっている。

2023年7月に参加企業の応募受付を開始し、同年8月にリコーやストックマーク、TuringやPreferred Networks、松尾研究所、リクルートなど17社が選定されたと発表した。なおNTTの参加は今回の成果発表会で初めて公表された。

参加者は2023年8月〜12月にかけて、プロトタイピングキャンプや中間報告会などを挟みながらLLM開発に取り組んだ。LLM開発においては計算リソースの調達に加えて、リソース確保後の環境構築や学習時のトラブルの対応が課題になる。AWSジャパンでは大規模分散学習の環境構築や、ノード不良発生時に処理を再開する仕組みの実装などを支援として提供した。

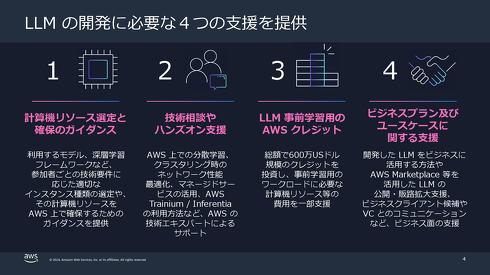

具体的にいうと、支援内容は大きく分けて4つある。1つ目は参加者の技術要件に応じた仮想サーバ(インスタンス)の選定や、計算機リソースをAWS上で確保するためのガイダンス提供だ。2つ目はAWSのサービスを用いた分散学習やクラスタリング時のネットワーク性能の最適化やマネージドサービスの活用、深層学習の学習プロセス向けアクセラレーターである「AWS Trainium」と、推論プロセス向けの「AWS Inferentia」の利用に関する技術エキスパートからのサポートだ。3つ目はAWSサービスの利用に必要となる「AWS クレジット」を600万米ドル(約8億9029万円)提供するというもの。4つ目は開発したLLMのビジネス活用や公開、販路の支援だ。

NTTは「tsuzumi」開発に利用

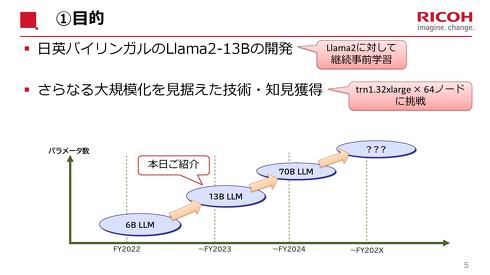

リコーはAWS LLM 開発支援プログラムを通じて、日英両言語に対応可能な130億パラメーターのLLMを開発した。MetaのLlama2アーキテクチャを採用している。

リコーは2022年に60億パラメーター規模の日本語特化型LLMを開発している。今回のLLM開発は、今後のモデルのさらなる大規模化を見据えて、LLMの学習戦略や学習環境に関する知見を獲得するという意味合いがある。

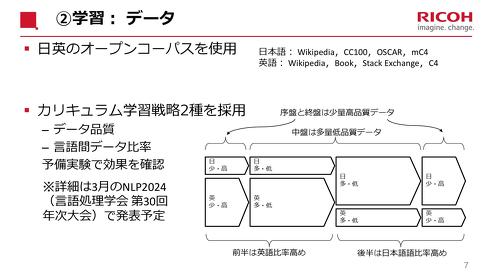

学習戦略においては、学習データの品質と日英言語間の学習データ比率で工夫した。日本語の壊滅的忘却を避けるため、学習の前半は英語の学習比率を高め、後半は日本語比率を高めている。さらに、学習の序盤と終盤は少量の高品質データを、中盤は大量の低品質データを与えるなど差を設けた。

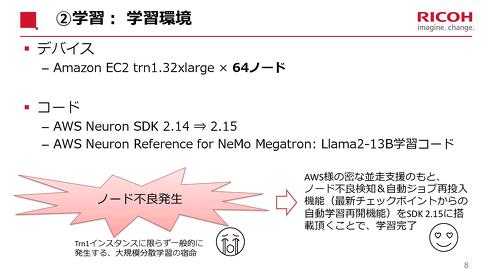

学習環境は「Amazon EC2 Trn1 インスタンス」の最大サイズであるtrn1.32xlargeを64ノード使用した。ノード不良などのトラブルにも見舞われたが、リコー デジタル戦略部の鈴木剛氏は「AWSから支援を受けて並走してもらうことで、恐らく最速の速度で学習を完了できた」と振り返った。

リコーが開発したLLMは日本語性能ベンチマークである「llm-jp-eval」で良好な結果を残した。一方で、英語性能のベンチマーク「lm-evaluation-harness」では、元となったMetaのLLM「Llama2 - 13B」よりスコアが若干低下したという。

リコーでは2024年春ごろから企業固有のデータなどでカスタマイズしたカスタムLLMをクラウド経由で顧客に提供開始する。文書要約や質問応答など、業務ワークフローの最適化や効率化に役立てる。さらにリコーは2024年内に700億パラメーターのLLM開発を計画している。

NTTは自社開発のLLM「tsuzumi(つづみ)」の開発においてAWSのリソースを活用した。tsuzumiは日本語処理能力の高さとモデルの軽量さ、チューニングの柔軟性を特徴とするLLMである。光ネットワーク構想「IOWN」に関わる通信基盤「APN(All Photonics Network)」で遠隔地にある自社GPUを用いたモデルの学習を行った。これに加えて、AWSのGPUインフラや産総研のAI用クラウド計算基盤「ABCI」なども活用したようだ。

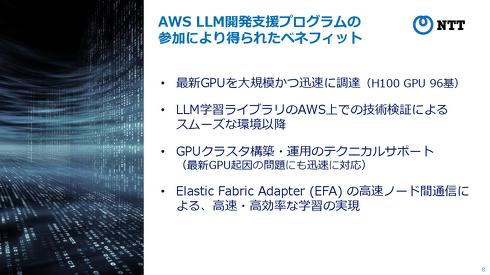

NTTはAWS LLM 開発支援プログラムを通じて、NVIDIAのGPU「NVIDIA H100 GPU(H100)」を96基活用した。この他のメリットとしてNTT人間情報研究所 上席特別研究員の西田京介氏は「LLM学習ライブラリをAWS環境で使うための技術検証や、GPUクラスタの構築や運用に関する技術支援を受けた。Amazon EC2インスタンスのネットワークインタフェースである『Elastic Fabric Adapter(EFA)』のマルチノード間の通信も非常に高速で、大変感謝している」と語った。

ストックマークは製造業を中心に活用されている、自然言語処理を活用した情報収集プラットフォームを展開する企業だ。ストックマーク 取締役CTOの有馬幸介氏は「OpenAIのChatGPTは素晴らしいが、産業界では正確性が重視されるため、さらにハルシネーション(幻覚)を抑えたLLMが求められている」と指摘する。ただ、ハルシネーションの抑制にはLLMの学習量が大きく関わるが、既存のLLMでは日本語の学習量がそもそも非常に少ないという問題がある。こうした課題を解決するためにLLMの自社開発を決めた。

AWS LLM 開発支援プログラムには、大規模なGPUリソースの確保が難しい中、学習用リソースとしてAWS Trainiumの支援が受けられることなどから参加した。その成果として130億パラメーターのLLM「Stockmark-13b」を2023年10月に開発した。自社内の製品や技術などのノウハウ共有、コア技術や既存アセットの用途探索といった用途での活用を想定し、サービスで一部実用化しているという。

関連記事

生成AIは本当に製造業の役に立つのか 導入後の「定着化」が問われる2024年

生成AIは本当に製造業の役に立つのか 導入後の「定着化」が問われる2024年

2023年は大手製造業を中心に生成AIの大規模導入が進んだ年だった。確かに、生成AIは製造業にも革命的な変化をもたらすテクノロジーだと感じられるが、導入そのものはゴールではない。2024年は定着化に向けた施策が進むと思われるが、その辺りを少し考えてみたい。 生成AIで変わる自動車のAIアシスタント、SDVの布石としての役割も

生成AIで変わる自動車のAIアシスタント、SDVの布石としての役割も

ドライバーを理解し、的確にサポートするAIアシスタント。定番ともいえるコンセプトで、まだ実現しきれていない部分も残っていますが、2024年の今、リアリティーを持って改めて提案されています。 製造業の顧客接点をデジタル化し集約、AIで営業やサポートを効率化

製造業の顧客接点をデジタル化し集約、AIで営業やサポートを効率化

オプティムは、製造業向けに顧客接点をデジタル化して集約するサービス「OPTiM Hardware My Portal」を発表した。製品サポートや営業支援に関する情報をポータル上で公開することで、顧客満足度の向上や営業効率化を図る。 Googleの新基盤モデル「Gemini」、AI統合プラットフォームで法人利用開始

Googleの新基盤モデル「Gemini」、AI統合プラットフォームで法人利用開始

Google Cloudの日本法人であるグーグル クラウド ジャパンは2023年12月14日、同社の新たな基盤モデル「Gemini」の話題を中心に、法人向けに提供する生成AI関連のサービスや機能を発表した。機械学習開発の統合プラットフォーム「Vertex AI」からGeminiにアクセス可能になる。 「IOWN」はLLMに何をもたらすか、NTTが進める次世代通信とAIの研究開発

「IOWN」はLLMに何をもたらすか、NTTが進める次世代通信とAIの研究開発

NTTが同社の技術研究の成果などを展示紹介する「NTT R&Dフォーラム2023」を開催中だ。基調講演では代表取締役社長の島田明氏や執行役員研究企画部門長の木下真吾氏が、「IOWN」や大規模言語モデル「tsuzumi」を中心にR&Dの取り組みを紹介した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

製造マネジメントの記事ランキング

- 生産性100倍に、富士通がソフトウェア開発をAIエージェントで自動化する開発基盤

- 従業員のスキルに応じた「ランク認定制度」も 三菱電機が推進するDX人材育成施策

- 日本は本当に遅れているのか? AI×現場力で始まる日本型モノづくりの逆襲

- 「好きなことは楽しめる間にとことん楽しむ」という考え方の重要性について

- アイリスオーヤマなど、無線制御技術を軸に建設業界の課題解決に向けた協業開始

- IOWN APNと画像認識AIにより、約300km離れた工場での外観検査に成功

- パナソニックは新技術拠点「Technology CUBE」で“実装力のあるR&D”を強化

- AIエージェントが代わりに働くようになったら人は何をするの?

- 永守氏がニデック完全退任、「経営者としての私の物語にピリオド」

- 富士フイルムBIがトルコ企業を買収、基幹システム導入の海外展開加速

コーナーリンク