「未体験」の大規模エンジニアリング、リコーが進めるGPTレベルのAIモデル開発:人工知能ニュース

AWSの年次イベントで登壇したリコーによる、AWSのサービスを活用したGPTレベルのAIモデル開発に関する発表を紹介する。

AWSは2023年4月20〜21日に年次イベント「AWS Summit Tokyo」(幕張メッセ)を開催した。本稿では事例セッションで登壇したリコーの、AWSのサービスを活用したGPTレベルのAIモデル開発に関する発表を紹介する。

短期間で高品質な日本語生成を可能に

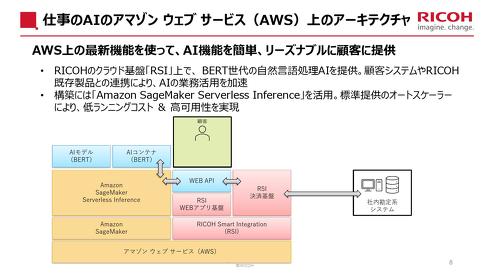

これまでにリコーは、自然言語処理のAI技術を活用したサービスとして、企業のドキュメントやVOC(顧客の意見:Voice Of Customer)を分析する「仕事のAI」などを展開してきた。同サービスではGoogleの言語モデル「BERT」をベースとするAIモデルをクラウド基盤上で稼働させていた。リコー デジタル戦略部 デジタル技術開発センター長の梅津良昭氏は「当社が初めて大規模な言語モデルをサービスで活用した事例だった」と説明する。

ただし、「BERT世代のAIモデル」には教師データ開発やアノテーションにかなり時間がかかるといった問題があった。さらに個別業務にフィットするように単純なタスクに分解し、落とし込む必要もある。これに対して2020年頃に登場した「GPT-3」は、教師データによる追加学習が基本的に不要な上、プロンプトを通じた個別業務へのフィッティングも容易だった。このため当時から「業務で使用した際のインパクトが大きなものとなると予想していた」(梅津氏)という。そこでリコーでは、AWSなどと協調しながら、2022年からGPT-3を活用したシステムの自前開発に取り組み始めた。

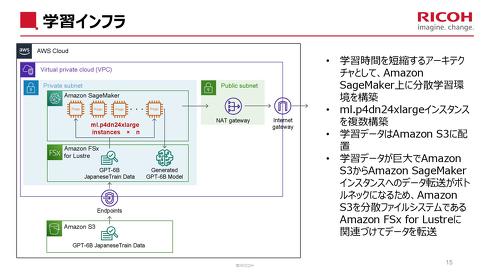

GPTレベルの大規模AIモデルの構築は、リコーにとっては「未体験の領域」(梅津氏)だった。さらに2022年初頭は世界全体でGPUが入手しづらい状況が生じており、AWSと協議しつつ、NVIDIAのA100 Tensor Core GPUを活用できるAmazon EC2 P4d インスタンスの上限緩和申請を行うなど対策を講じた。ただ、実際にはGPUが速すぎてAmazon S3からAmazon SageMakerインスタンスへのデータ転送がボトルネックになり、データ転送が追い付かないという問題も生じた。これに対しては、転送速度をうまく調整することで適切に学習できるようにするなど工夫した。

AIエンジニアリングの面では、Amazon SageMakerによる分散学習環境の構築を図った他、Amazon Machine Learning Solutions LabによるAIモデル実装面での支援を受けるなどでAWSのサービスを活用した。これによって約3カ月で小規模ではあるが「GPT-3レベルのAIモデル」を開発することができた。吟味した日本語データを学習させることで、他社のAIモデルに比べて高品質な日本語の文章生成を高速で行えるようにしている。

現在リコーでは、GPT-3レベルのAIモデル開発/運用を行う環境の顧客提供を目指している。また、さらに業務へのフィッティング感を高めるために、GPT-3レベルの自然言語処理技術に同社のCG技術や音声認識技術を組み合わせたAIアシスタント「デジタルヒューマン」の開発も進めているという。

梅津氏は「GPTを企業が活用して業務に活用する時代がすぐに来る。そこにリーチするようなAIの開発を進めたい。RLHFやプロンプトエンジニアリングなどを活用してより多くの企業に提供できるようにしていきたい」と語った。ただし、GPT世代のAIモデルを提供するには、学習や運用面での課題が残されているとも指摘した。

関連記事

PFUのスキャナーが富士通からリコーブランドへ、2025年度に売上高720億円目指す

PFUのスキャナーが富士通からリコーブランドへ、2025年度に売上高720億円目指す

PFUは、世界シェアトップとする同社のイメージスキャナー「fiシリーズ」「SPシリーズ」「ScanSnap」のブランドオーナーをリコーに変更すると発表した。 360度映像ビジネスを拡大へ、リコーがハードウェアとSaaSの組み合わせ強化

360度映像ビジネスを拡大へ、リコーがハードウェアとSaaSの組み合わせ強化

リコーは2022年3月30日、360度カメラ「RICOH THETA」の新製品としてビジネス用途での活用を効率的に実現する「RICOH THETA X」の国内展開を発表。ソフトウェア、クラウドサービスを組み合わせた、ビジネス市場向けの「RICOH360」プラットフォーム事業を強化していく方針を示した。 リコーが高速かつ省電力のAI技術を開発、IoTデバイス上での学習も可能に

リコーが高速かつ省電力のAI技術を開発、IoTデバイス上での学習も可能に

リコーは、人工知能(AI)に用いられる機械学習の手法の1つであるGBDT(Gradient Boosting Decision Tree:勾配ブースティング決定木)モデルの学習を大幅に高速化、低消費電力化する回路アーキテクチャを開発したと発表した。 GoogleやAWSが推進する次世代通信プロトコルの組み込み機器向けライブラリ

GoogleやAWSが推進する次世代通信プロトコルの組み込み機器向けライブラリ

ユビキタスAIは、Googleなどが利用を広める次世代通信プロトコル「QUIC」を組み込み機器やIoT製品などで使用するためのソフトウェアライブラリ「Ubiquitous QUIC」と、「Ubiquitous RTOS IoT Enabler」のQUIC対応版を提供開始した。 AWSがSaaSベースのSCMソリューション「AWS Supply Chain」を発表

AWSがSaaSベースのSCMソリューション「AWS Supply Chain」を発表

Amazon Web Services(AWS)は、ユーザーイベント「AWS re:Invent 2022」の基調講演において、SaaSベースのSCM(サプライチェーンマネジメント)ソリューション「AWS Supply Chain」を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

製造マネジメントの記事ランキング

- 生産性100倍に、富士通がソフトウェア開発をAIエージェントで自動化する開発基盤

- 従業員のスキルに応じた「ランク認定制度」も 三菱電機が推進するDX人材育成施策

- 日本は本当に遅れているのか? AI×現場力で始まる日本型モノづくりの逆襲

- 「好きなことは楽しめる間にとことん楽しむ」という考え方の重要性について

- パナソニックは新技術拠点「Technology CUBE」で“実装力のあるR&D”を強化

- アイリスオーヤマなど、無線制御技術を軸に建設業界の課題解決に向けた協業開始

- IOWN APNと画像認識AIにより、約300km離れた工場での外観検査に成功

- AIエージェントが代わりに働くようになったら人は何をするの?

- 永守氏がニデック完全退任、「経営者としての私の物語にピリオド」

- 「中国のスペースX」銀河航天は衛星をどう量産するのか 製造デジタル基盤の全貌

コーナーリンク