インテルアーキテクチャもディープラーニングに有効、「GPUが最適は先入観」:人工知能ニュース(3/3 ページ)

AI関連ソフトウェアも重視

インテルのAI技術は、ここまで説明したハードウェア中心のNervanaだけではない。それ以上にAI関連ソフトウェアの展開も重視している。まず、TensorFlowや「Caffe」「Torch」といったAIのフレームワークを、IA向けに最適化するためのディープラーニングコンピューティングビルディングブロックを用意する。「MKL-DNN(ディープニューラルネットワーク向けマスカーネルライブラリ)」と呼ぶオープンソースのライブラリとして公開する。既にテクノロジープレビューはリリースされている。またIA上でディープラーニングを32ノード以上に拡張できる「MLSL(マシンラーニングスケーリングライブラリ」も用意する。

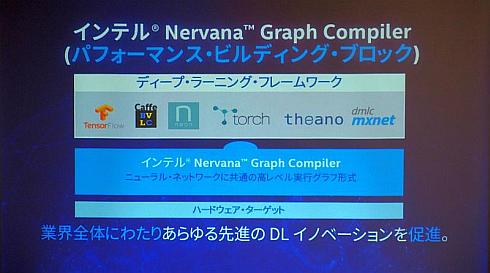

さらにAIフレームワークを動的にコンパイルしてバイナリ化するコンパイラ「Nervana Graph Compiler」も提供する。これはナーバナ・システムズのAIフレームワーク「Neon」の機能を切り出したもので、複数のハードウェアターゲットへの最適化を実現できることを特徴としている。根岸氏は「Neonから切り出したことにより、Neon以外のAIフレームワークにも利用できるようになった」と説明する。

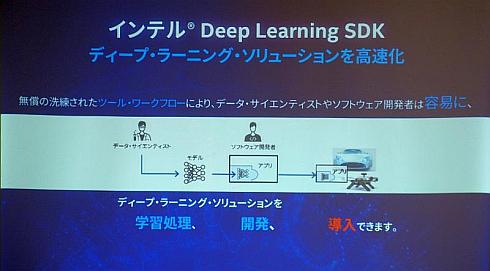

この他、ディープラーニングソリューションを容易に開発できる「Deep Learning SDK」なども発表している。

ディープラーニング=GPUというイメージは先入観

現在、AIの計算処理、特にディープラーニングについてはNVIDIAをはじめとするGPUが用いられているイメージが強い。GPUの性能の高さを示すために、Xeonの処理能力の○○倍のような表現が使われることも多い。

根岸氏は「それは先入観にすぎない。実際にIAのようなCPUへの最適化を実施してみたところ、ディープラーニングの処理能力を十分に引き出せることが分かった。もちろんピーキーな並列処理能力を求められるディープラーニングもあり得るが、その場合にはLake Crestを活用すればよい。AIはディープラーニングにとどまらないさまざまな技術から構成されており、そのためにはスケーリングさせられる技術が重要になる」と述べている。

関連記事

デンソーがクルマに載せられるAIの開発に注力、「かなり早めに出せる」

デンソーがクルマに載せられるAIの開発に注力、「かなり早めに出せる」

デンソーが東京都内で報道陣向けにAI(人工知能)取材会を開催。自動運転やADAS(高度運転支援システム)向けでAIを実用化するために開発しているさまざまな技術を、デモンストレーションで披露した。 三菱電機の人工知能は「エッジに賢くコンパクトに載せる」

三菱電機の人工知能は「エッジに賢くコンパクトに載せる」

三菱電機は、神奈川県鎌倉市に拠点を構える情報技術総合研究所とデザイン研究所の報道陣向け視察会を開催。情報技術総合研究所 所長の中川路哲男氏は、同社の人工知能(AI)の開発方針について「エッジに賢くコンパクトに載せる」と説明した。 「完全自動運転の障害物検知は人工知能が不可欠」 、トヨタテクニカルセンターのCE

「完全自動運転の障害物検知は人工知能が不可欠」 、トヨタテクニカルセンターのCE

トヨタ自動車の北米市場における開発を担うトヨタテクニカルセンター。製品開発部門のCE(チーフエンジニア)に、北米市場での自動運転の動向について聞いた。 富士通が量子コンピュータ超える新AI技術、グラフ構造データへの深層学習適用も

富士通が量子コンピュータ超える新AI技術、グラフ構造データへの深層学習適用も

富士通研究所が人工知能(AI)技術の最新成果を発表。「量子コンピュータを実用性で超える新アーキテクチャを開発」と「人やモノのつながりを表すグラフデータから新たな知見を導く新技術『Deep Tensor』を開発」の2件である。 NECがAI事業強化「思考の拡大」目指す、「脳型コンピュータ」開発も

NECがAI事業強化「思考の拡大」目指す、「脳型コンピュータ」開発も

NECが人工知能関連事業を強化、人員を現在の倍にあたる1000人に拡大する。増員によってAI事業の適用範囲拡大を図り売り上げ2500億円を目指す。AI活用基盤として、脳型コンピュータの開発も進める。 日立の人工知能技術「H」が“汎用AI”だからできること

日立の人工知能技術「H」が“汎用AI”だからできること

日立製作所は、ユーザーイベント「Hitachi Social Innovation Forum 2016 TOKYO」において、同社の人工知能(AI)技術「Hitachi AI Technology/H(以下、H)」を紹介するデモ展示を行った。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- 月面を照らす「光の物差し」 JAXAとカシオが可視光測位技術を実証

- 生成AI実行時の消費電力が10W以下に SiMa.aiのSoC「Modalix」の実証結果を公開

- 1μF以下の極小コンデンサーでも安定動作する500mA対応LDOレギュレーター

- フォックスコンがフィジカルAIで実現する「AX」とは、NVIDIAと川崎重工も講演

- 衛星通信向け量子鍵配送送受信システムの小型化と高速化に成功

- いまさら聞けないエッジAIとクラウドAIの違い “現場処理回帰”の必然性とは

- 高速起動とREST APIで高性能なデータ取得を自動化する測定コア

- 時代はDXからAIが当たり前に浸透する「IX」に突入へ CES 2026の内容をひもとく

- 愛猫の不調を見逃さない、LIXILが非接触呼吸計測デバイスを開発

- 現場や事務用途で快適に使える防塵防水対応の10.1型タブレットPCを発売

コーナーリンク