AIデータセンターの性能が20倍に、NVIDIAがAmpere世代のGPU「A100」を発表:GTC 2020 基調講演(2/3 ページ)

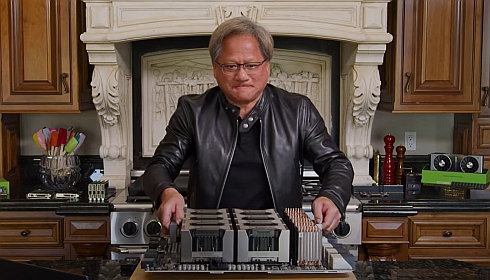

オーブンから出てきたのは“世界最大のグラフィックスボード”

フアン氏は、A100の性能の紹介を終えると、講演の舞台となる台所のオーブンの中から“世界最大のグラフィックスボード”を取り出してみせた。重量50ポンド(約22.6kg)で、8個のA100をNVLinkでつないでおり、基板上の100万個のドリル穴と総計1kmの導体により3万個の部品が接続されている。

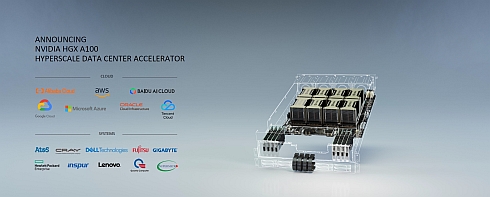

データセンターGPUとしてのA100の展開は、このように8個のA100をNVLinkでつないだシステムを1つの単位として販売していくことになる。フォームファクターとしては、単独のAIシステムとして運用できる「NVIDIA DGX A100(以下、DGX A100)」と、データセンター向けのアクセラレーターユニットとなる「NVIDIA HGX A100(以下、HGX A100)」の2つがある。

DGX A100は、8個のA100の他、AMDのサーバ向けCPU「Rome」と1TBのRAM、NVLinkを用いたインターコネクトファブリック「NVSwitch」を6つ、サーバ間のネットワークインタフェースとなる「Mellanox ConnectX-6 VPI」を9つ、ストレージとして容量15TBのGen4 NVMe SSDを搭載している。Tensorコアとスパース化を用いた場合の処理性能は、INT8で10P(ペタ)OPS、FP16で5PFLOPS、TF32で2.5PFLOPS、FP64で156TFLOPSとなっている。

DGX A100は既に販売が始まっており価格は19万9000米ドルである。また、HGX A100については、Amazon Web ServicesやMicrosoft、Google、Alibaba、Baidu、Oracle、Tencentなどの大手パブリッククラウドベンダーが採用を表明しており、Dell TechnologiesやHPE、Lenovo、富士通などのサーバベンダーによる製品化も計画されている。

フアン氏が新製品を紹介する際には、従来比で大幅なコスト削減や消費電力削減が可能なことを強調するのが定番だ。DGX A100については、V100を搭載する「DGX-1」を用いたAIデータセンターとの比較を行った。DGX-1はディープラーニングの学習用に最適化されているため、推論実行用にCPUも用いられることが多い。比較対象のAIデータセンターは、50台のDGX-1と600台のCPUシステムで構成されており、価格は1100万米ドル、サーバラック数は25、消費電力は630kWだ。

これと同じ性能のAIデータセンターをDGX A100で実現する場合、5台のDGX A100だけで済む。価格は100万米ドルで10分の1以下、サーバラック数は1つで25分の1、消費電力は28kWで20分の1以下になる。

これに加えてWeb検索のページランクアルゴリズムを処理するデータセンターを例にした比較も紹介。105のサーバラックに3000台のCPUサーバを組み込んで運用しているデータセンターの処理性能は520億エッジ/秒。これに対して、4台のDGX A100で構成するシステムであれば処理性能は6880億エッジ/秒で13倍に達する。その上でコストは75分の1にすぎないという。

この他、140台のDGX A100により700PFLOPSの処理性能を持つ大規模システムの「NVIDIA DGX A100 SUPERPOD」や、NVIDIAの社内AIデータセンター「SATURNV」を4台のSUPERPODの追加で処理性能を従来比約2.5倍となる4.6ExaFLOPSに拡張した事例などを紹介した。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

コーナーリンク