AIデータセンターの性能が20倍に、NVIDIAがAmpere世代のGPU「A100」を発表:GTC 2020 基調講演(1/3 ページ)

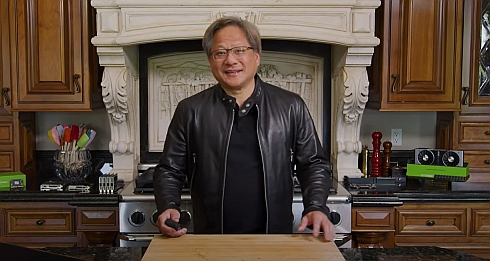

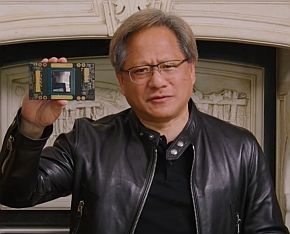

NVIDIA CEOのジェンスン・フアン氏は、YouTubeでオンデマンド配信した「GTC 2020」の基調講演において、新たなアーキテクチャ「Ampere」を採用したGPU「NVIDIA A100」を発表した。

NVIDIAは2020年5月14日、同社のYouTubeチャンネルで、ユーザーイベント「GTC(GPU Technology Conference) 2020」の基調講演をオンデマンド配信した。GTC 2020は同年3月22〜26日に米国サンノゼで開催予定だったが、新型コロナウイルス感染症(COVID-19)の感染拡大のため、リアルイベントに替えて完全オンラインのイベント「GTC Digital」を実施している。GTCの基調講演と言えば、同社 創業者兼CEOのジェンスン・フアン(Jensen Huang)氏が講演会場のステージ上で新たな製品や技術を紹介するのが定番だが、今回はCOVID-19に対応した自宅からの講演をイメージさせる“キッチンキーノート”として配信を行った。

GTC 2020の基調講演はイントロダクションから最後のまとめまで全9部構成、総計1時間40分以上に上る大ボリュームの内容となっている。本稿では、今回の基調講演の目玉となった第6部の講演内容を中心に紹介する。

7nmプロセスチップとして世界最大

全9部構成の基調講演のうち最も多い24分弱の時間を割いた第6部では、新たなGPUアーキテクチャ「Ampere」などの採用によるデータセンターにおけるAI(人工知能)処理性能の大幅な向上について紹介した。

クラウドをはじめとするデータセンターが、アプリケーション処理やAIの機械学習、データ分析、HPC、クラウドゲーミングなどさまざまワークロードに対応するためにより複雑な構成を取るようになっている。フアン氏は「今後もクラウドコンピューティングへの需要が高まる中で投資コストを抑えて行くには、1つのサーバアーキテクチャでさまざまなワークロードに対応できる必要が出てくるだろう」と指摘する。

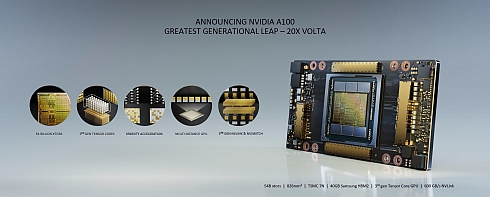

そのために開発したのがデータセンターGPUの「NVIDIA A100(以下、A100)」である。A100は、第8世代となるGPUアーキテクチャのAmpereを採用した初のGPU製品で、製造プロセスは台湾TSMCの7nmプロセスをNVIDIA向けに最適化したものになっている。高密度を特徴とするパッケージング技術「CoWoS(Chip on Wafer on Substrate)」の採用でGPUダイとメモリを高密度に並べ、HBM(High Bandwidth Memory)2のバンド幅は1.6TB/sに達する。540億以上のトランジスタを集積しており、826mm2のダイ面積は7nmプロセスチップとして世界最大だという。

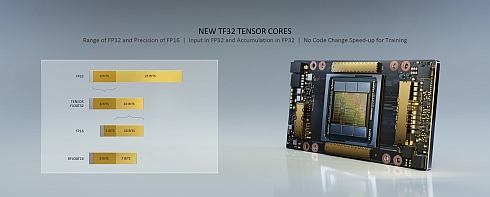

Ampereの特徴は大まかに分けて2つある。1つは、ディープラーニング(深層学習)向けに開発されたTensorコアが第3世代に進化したことだ。第3世代Tensorコアは、従来と同じくFP64やFP32、FP16といった浮動小数点演算、INT8などの整数演算を利用できる他、新たにBFLOAT16(Brain Floating Point 16)と、独自に定義したTF32(Tensor Float 32)に対応した。TF32は、ニューラルネットワーク向けに「FP32のダイナミックレンジとFP16の精度を併せ持つ」(フアン氏)ものになっているという。

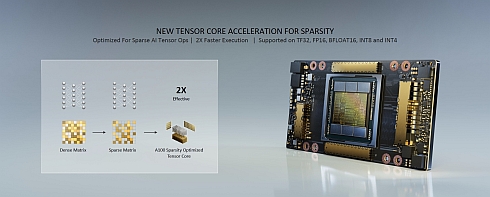

また、第3世代Tensorコアは深層学習の計算の精度を犠牲にせずに効率を大幅に高められるスパース化(Sparsity)に対応した。スパース化を用いてディープラーニングを行う場合には処理性能を倍増させることが可能になる。

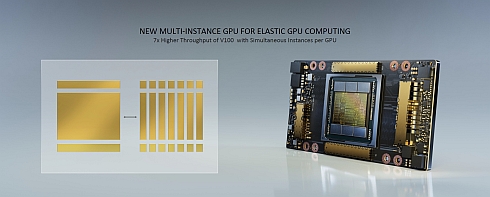

もう1つの特徴は、1つのGPUを最大で7つの独立したGPUに分離して扱えるMIG(Multi-Instance GPU)である。これにより単に処理速度の速い1個のGPUとしてだけでなく、スケーラブルかつ柔軟にGPUを利用できるようになる。フアン氏は「従来のGPUは巨大なペイロードを持つロケットであり、ペイロードが満杯になるまでロケットの打ち上げを待つ必要があった。A100のMIGは、より小さなペイロードを持つ7つのロケットとしても利用可能で、ペイロードに荷物が入り次第打ち上げられる」と説明する。

これらの他、GPU間接続技術であるNVLinkも第3世代となり、従来比で2倍となる600GB/sのバンド幅を実現している。

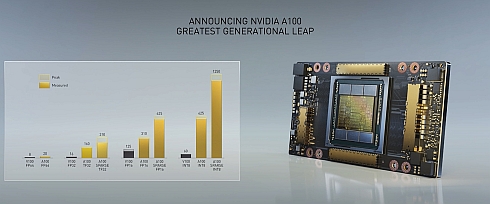

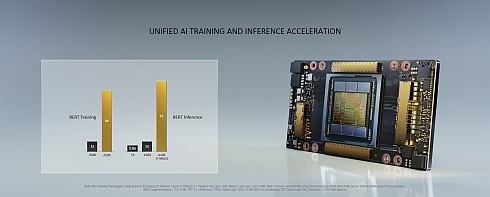

なお、A100の処理性能については、第7世代アーキテクチャ「Volta」を採用する「V100」と比較した結果を示した。スパース化を用いないFP64とFP16ではV100の約2.5倍にとどまるものの、スパース化を用いたA100のTF32とV100のFP32、スパース化を用いたA100のINT8とV100のINT8の比較では20倍前後の性能をたたき出している。また、近年のディープラーニングの処理性能の目安になっている自然言語処理モデルのBERTで見ると、BERTの学習でV100の6倍、BERTの推論実行でV100の7倍を達成している。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- イチから全部作ってみよう(29)3つのノート整理法からたどるRDBMSの基礎知識

- 月面を照らす「光の物差し」 JAXAとカシオが可視光測位技術を実証

- 東芝の2つの次世代ゲート駆動技術がSiCデバイスの損失削減に寄与、ISSCCで発表

- NXPがエッジへのAIエージェント実装を推進、数百TOPSクラスの新たなNPUも開発へ

- AUTOSARの“AR”はアーキテクチャに由来、アーキテクチャ設計にどう使うのか

- 買い物客の8割が求める「自分だけの割引」、小売業はどう対応すべきか

- クレーンゲームにIoTデバイスを搭載しスマホ決済、新店の約370台に搭載

- インフィニオンがams OSRAMのセンサー事業を買収、自動車や医療向けを強化

- TFT技術とメタマテリアル技術を融合した衛星アンテナ用基板を共同開発

- 急成長中の中国ヒューマノイド大手AgiBotの技術戦略

コーナーリンク