グーグルはなぜ「オンデバイスAI」を志向するのか:人工知能ニュース(2/2 ページ)

「オンデバイスAI」によってプライバシーが守られる

グーグルは、開発が加速しているAIチップの登場により、クラウド上での処理が中心だったAI利用の方向性を、機器内での処理に変えつつある。イ・アルカス氏は、この方向性を「オンデバイスAI」と呼び、同社が開発した製品を例に挙げて説明した。

最初に挙げたのは、2018年2月発表の小型AIカメラ「Google Clips」である(国内未発売)。Google Clipsは、搭載するAIチップ(インテルの「Myriad 2」)を用いて、機器内で撮影に最適な瞬間を学習する機能を持つ。「機器内でAIの学習を行えるからこそ開発した製品だ。クラウドにデータを上げないことでプライバシーが守られる。これは極めて重要なことだ」(イ・アルカス氏)。

そして、最新のスマートフォンであるPixel 3/Pixel 3 XLでは、Google Clipsと同様の機能を「Top Shot」として実装している。また、前世代の「Pixel 2」から先行して採用している自動音楽認識機能の「Now Playing」もオンデバイスAIだ。この他にも、Pixel 3/Pixel 3 XLでAIを用いている機能としては、AR(拡張現実)機能となる「Playground」や、人間の代わりにAIが電話に応答する「Call Screen」(国内未提供)がある。

最新の機能であるカメラの夜景モード「Night Sight」については「人間の眼とカメラは基本的に同じ構造だ。でも、カメラで撮影した夜景が、人間の眼で捉えたものと異なるのは、網膜と直接つながっている脳が光量が限られる状況を判断して調整しているからだ。そこで、CMOSセンサーにAIをつなげる形で実現したのがNight Sightだ」(イ・アルカス氏)という。

ただし、一般的に機器側に組み込まれるAIチップでは、ニューラルネットワークに基づく学習モデルによる推論を実行することしかできないといわれている。このため、AIチップで推論を実行しつつ、センサーから収集したビッグデータを用いてクラウドで学習し、その結果得られる学習モデルをAIチップにフィードバックするという利用法が想定されている。

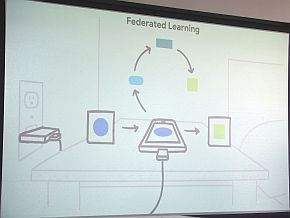

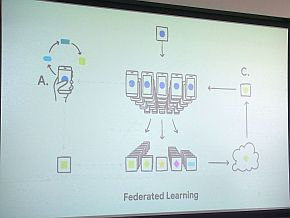

これに対してイ・アルカス氏は、オンデバイスAIにおける学習の新たな手法としてフェデレーションラーニング(Federated Learning)を挙げた。「人間の脳は、新しく学んだことを寝ている間に身に付ける。十分な睡眠をとらないと学習の効果が薄いといわれるのはこのためだ。これと同じ機能を実現するのがフェデレーションラーニングだ」(同氏)。

フェデレーションラーニングのイメージ。クラウドは用いずにオンデバイスAIとして学習を行う(左)。オンデバイスAIで得た改善情報は個人を特定できない情報となり、クラウドに送ってモデルの改善に利用できる(右)(クリックで拡大) 出典:グーグル

フェデレーションラーニングのイメージ。クラウドは用いずにオンデバイスAIとして学習を行う(左)。オンデバイスAIで得た改善情報は個人を特定できない情報となり、クラウドに送ってモデルの改善に利用できる(右)(クリックで拡大) 出典:グーグルフェデレーションラーニングでは、ビッグデータをクラウド上に収集することなく、機器側で得たデータを使ったオンデバイスAIによって学習を行う。学習によって得た改善情報は、個人を特定可能な情報ではない形で暗号化された通信でクラウドに送られ、学習モデルの改善に利用される。「ビッグデータがなくても機械学習が可能になる技術であり、当社も期待している」(イ・アルカス氏)。既にAndroid向けキーボードアプリの『Gboard』で試験運用しており、ユーザーに合わせて文字入力のスマート補完機能を最適化することが可能だ。

なお、Google ClipsはMyriad 2、Pixel 3/Pixel 3 XLは画像処理IC「Pixel Visual Core」がAIチップとしての役割を果たしている。グーグルは、組み込み機器向けのAIチップとしてEdge TPUを開発しているが「AIについては基本的に同じアーキテクチャで開発しているので、Edge TPUにも展開可能だ。将来的にはフェデレーションラーニングをEdge TPUにも適用できるだろう」(イ・アルカス氏)としている。

関連記事

グーグルの深層学習プロセッサ「TPU」が「AIを、全ての人に」を実現する

グーグルの深層学習プロセッサ「TPU」が「AIを、全ての人に」を実現する

グーグル(Google)は2018年7月6日、東京都内でメディアセミナーを開き、同社がディープラーニング(深層学習)向けに開発してきたプロセッサ「TPU」について説明した。 グーグルがエッジデバイスにもAIチップを展開、推論実行に特化した「Edge TPU」

グーグルがエッジデバイスにもAIチップを展開、推論実行に特化した「Edge TPU」

グーグル(Google)は、米国サンフランシスコで開催したGoogle Cloudのユーザーイベント「Google Cloud Next 2018」の発表内容について説明。同イベントの発表で製造業が最も注目したのは、エッジデバイス上で機械学習モデルの推論実行を効率良く行うためのASICチップ「Edge TPU」の提供だろう。 AIと機械学習とディープラーニングは何が違うのか

AIと機械学習とディープラーニングは何が違うのか

技術開発の進展により加速度的に進化しているAI(人工知能)。このAIという言葉とともに語られているのが、機械学習やディープラーニングだ。AIと機械学習、そしてディープラーニングの違いとは何なのか。 機械学習はどうやって使うのか――意外と地道な積み重ね

機械学習はどうやって使うのか――意外と地道な積み重ね

前編では、AI(人工知能)と機械学習、ディープラーニングといった用語の説明から、AIを実現する技術の1つである機械学習が製造業を中心とした産業界にも徐々に使われ始めている話をした。後編では、機械学習を使ったデータ分析と予測モデル作成について説明する。 世界を変えるAI技術「ディープラーニング」が製造業にもたらすインパクト

世界を変えるAI技術「ディープラーニング」が製造業にもたらすインパクト

人工知能やディープラーニングといった言葉が注目を集めていますが、それはITの世界だけにとどまるものではなく、製造業においても導入・検討されています。製造業にとって人工知能やディープラーニングがどのようなインパクトをもたらすか、解説します。 日本は既にディープラーニングで後進国となりつつある――東大松尾教授

日本は既にディープラーニングで後進国となりつつある――東大松尾教授

生産設備から社会インフラ、各種災害対策まで「メンテナンス」「レジリエンス」に関する最新の製品や技術、サービスを一堂に集めた展示会「メンテナンス・レジリエンスTOKYO2018」(2018年7月18〜20日、東京ビッグサイト)の特別講演に東京大学大学院 工学系研究科 特任准教授の松尾豊氏が登壇。「AIの発達によりわれわれの生活・産業がどのように変わるのか」をテーマにディープラーニング研究の重要性について紹介した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

- 1.5km離れた漁場をWi-Fi HaLowなどで可視化、海洋モニタリングの実証に成功

- STPAの第4ステップで忘れがちな「損失シナリオ識別」の詳細手順

コーナーリンク

小型AIカメラの「Google Clips」 出典:グーグル

小型AIカメラの「Google Clips」 出典:グーグル