グーグルがエッジデバイスにもAIチップを展開、推論実行に特化した「Edge TPU」:人工知能ニュース(1/2 ページ)

グーグル(Google)は、米国サンフランシスコで開催したGoogle Cloudのユーザーイベント「Google Cloud Next 2018」の発表内容について説明。同イベントの発表で製造業が最も注目したのは、エッジデバイス上で機械学習モデルの推論実行を効率良く行うためのASICチップ「Edge TPU」の提供だろう。

グーグル(Google)は2018年8月3日、東京都内でメディアセミナーを開き、米国サンフランシスコで同年7月24〜26日に開催したGoogle Cloudのユーザーイベント「Google Cloud Next 2018」の発表内容について説明した。

2万3000人以上が参加し、500以上の講演やトレーニングが行われたGoogle Cloud Next 2018では、Google Cloudの新機能などについて105件の発表が行われている。今回のメディアセミナーでは、Google Cloud カスタマーエンジニア 技術部長の佐藤聖規氏が登壇し、主な発表案件について「G Suite」「セキュリティ」「機械学習&AI」「AI&IoT」「クラウドサービスプラットフォーム」に分け説明した。本稿では、これらのうち製造業への関わりが深いAI(人工知能)やIoT(モノのインターネット)関連の話題を中心に紹介する。

GoogleのAIチップ「TPU」をエッジデバイスに

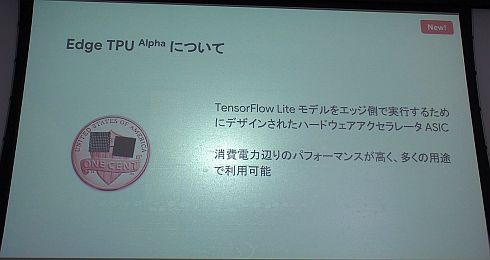

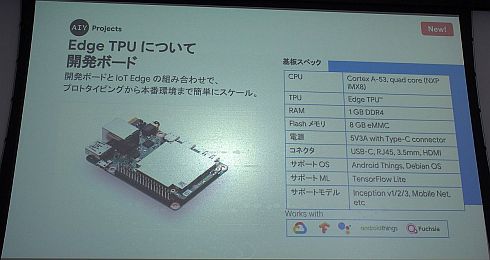

Google Cloud Next 2018の発表で製造業が最も注目したのは、IoT(モノのインターネット)の枠組みにおけるエッジデバイス上で、機械学習モデルの推論実行を効率良く行うためのASIC「Edge TPU」の提供だろう。α版ということで、Edge TPUそのものは一部顧客への早期アクセスにとどまるものの、Edge TPUを搭載した開発ボードとなる「AIY Edge TPU Dev Board」や、USB-C接続のスティック型モジュール「AIY Edge TPU Accelerator」などを一般ユーザー向けに提供する計画だ。米国では2018年秋に入手可能になる予定で、その後順次販売地域を広げる予定である。

Edge TPUは、グーグルの機械学習フレームワーク「TensorFlow」の軽量版である「TesorFlow Lite」による機械学習モデルの推論実行に特化したASICとなる。チップサイズは「1セント硬貨の上に4枚収まるほど」(佐藤氏)でかなり小さい。1セント硬貨の直径は約19mmなので、写真を見る限り外形寸法は6mm角程度のようだ。性能の詳細は明かされていないが「高解像の映像に対する機械学習モデルの推論実行を30fpsで、低消費電力で行える」(グーグル)という。

開発ボードのAIY Edge TPU Dev Boardは、TPUの他、CPUとしてNXPの「i.MX 8」と1GビットのDDR4メモリ、8GBのeMMCを搭載する。サポートOSは、Android ThingsとDebian OSとなっている。

グーグルは、同社の機械学習フレームワーク「TensorFlow」を用いた学習や推論を行うためのAIチップ「TPU」を開発している※)。これまでTPUは、クラウドのサービスを介してその機械学習のための大容量の計算能力を顧客に提供するとされてきたが、Edge TPUはハードウェアとして顧客に供給されることになる。佐藤氏は「機械学習の学習プロセスに用いるTPUは極めて大規模なハードウェアになるので、クラウドを介して提供するのが最適という考え方に変わりはない。ただし、エッジデバイス上で推論実行を効率よく行うには、従来のTPUとは異なるチップセットが必要になると判断した」と説明する。

※)関連記事:グーグルの深層学習プロセッサ「TPU」が「AIを、全ての人に」を実現する

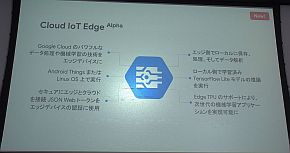

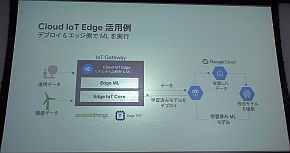

Edge TPUと併せて、Google Cloudとエッジデバイスの連携を円滑に行うための「Cloud IoT Edge」もα版として発表した。エッジデバイスとGoogle Cloudをセキュアにつなぐ「Edge IoT Core」、TesorFlow Liteの機械学習モデルの推論実行を行う「Edge ML」、そしてEdge TPUから構成されている。対応OSは、Android ThingsとLinuxである。

Cloud IoT Edgeにより、エッジデバイスで機械学習モデルによるリアルタイム解析を行いつつ、Google Cloudでの追加学習で機械学習モデルを改良し、それをエッジデバイスに再デプロイするというサイクルを回すことが可能になる。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

コーナーリンク

Google Cloudの佐藤聖規氏

Google Cloudの佐藤聖規氏