グーグルの深層学習プロセッサ「TPU」が「AIを、全ての人に」を実現する:AI基礎解説(1/3 ページ)

グーグル(Google)は2018年7月6日、東京都内でメディアセミナーを開き、同社がディープラーニング(深層学習)向けに開発してきたプロセッサ「TPU」について説明した。

グーグル(Google)は2018年7月6日、東京都内でメディアセミナーを開き、同社がディープラーニング(深層学習)向けに開発してきたプロセッサ「TPU(Tensor Processing Unit)」について説明した。

セミナーに登壇したのは、グーグルの日本法人で Google Cloud、データ分析チーム デベロッパーアドボケイトを務める佐藤一憲氏だ。佐藤氏は、TPU開発のもとになったディープラーニングのフレームワーク「TensorFlow」や、TPUの開発の歴史、多数のTPUで構築したAI(人工知能)スーパーコンピュータ「TPU Pod」、誰でもTPUの高い処理能力を使えるクラウドサービス「Cloud TPU」の他、2018年5月の「Google I/O 2018」で発表された最新の成果などについて紹介した。

きゅうりの選別やクリーニングの衣類認識に用いられる「TensorFlow」

TPUをはじめ、グーグルがディープラーニング関連ソリューションを開発する端緒となったのは「AI for everyone(AIを、全ての人に)」という方針だ。Google Brainチームは社内で利用するためにディープラーニングのツールを開発していたが、この方針に基づいて2015年7月、誰でも無償で使えるオープンソースのディープラーニングのフレームワークとして公開したのがTensorFlowである。

それ以降、ディープラーニング関連のさまざまな開発でTensorFlowが利用されている。グーグルが紹介している国内の取り組みでは、きゅうり農家におけるきゅうりの自動選別※1)や、最近ではクリーニングチェーンにおける衣類の自動認識※2)などが知られている。

※1)関連記事:「TensorFlow」でから揚げ配膳ときゅうりの仕分けを自動化、Googleがアピール

※2)関連記事:クリーニング屋の副社長は元DJ!? 独学で作ったAIで「無人店舗」を目指す

「TPU」の開発は15カ月で完了

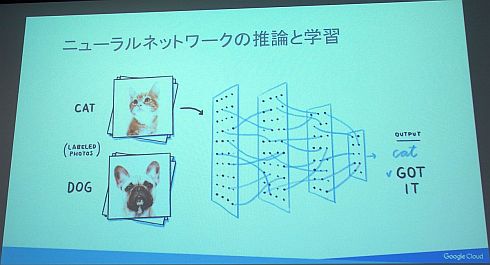

ディープラーニングでは、人の脳神経細胞を模した数式モデルであるニューラルネットワークが用いられる。そして、画像認識の例であれば、画像の中の認識対象が何なのかを覚えていく「学習」と、学習した結果を基に実際に画像認識を行う「推論」という2つのステップから成る。

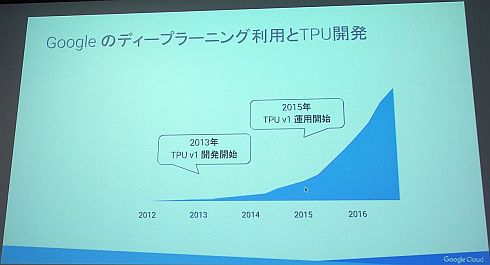

グーグル社内でディープラーニングの利用を進めて行く中で大きな課題になったのが、学習と推論ともに大きなコンピューティングリソースを必要とすることだった。「2013年ごろから社内でのディープラーニング利用が爆発的に増加し、このままのペースだと現在の2倍のコンピューティングリソースが必要になるという状況になった」(佐藤氏)という。

そこで2013年から開発がスタートしたのが、CPUやGPUといった汎用プロセッサとは異なる、ディープラーニングに特化したプロセッサのTPUだった。開発は15カ月で完了し、2015年から実運用が始まった。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- 1.5km離れた漁場をWi-Fi HaLowなどで可視化、海洋モニタリングの実証に成功

コーナーリンク

グーグルの佐藤一憲氏

グーグルの佐藤一憲氏