グーグルの深層学習プロセッサ「TPU」が「AIを、全ての人に」を実現する:AI基礎解説(3/3 ページ)

「TPU v2」は学習も可能、クラウドサービス「Cloud TPU」に展開

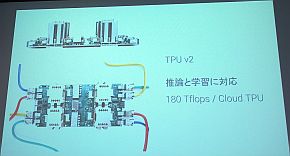

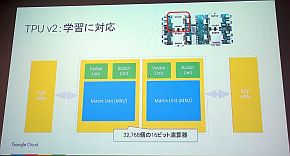

2017年5月、グーグルは第2世代のTPUとなる「TPU v2」を発表した。TPU v2の最大の特徴は、推論だけでなく学習にも対応したことだ。そのため、演算器は16ビットとなり、集積数は3万2768個となった。TPU v1とは異なり、製造プロセスや動作周波数などの情報は公開していないが、処理能力は180TFlopsを達成しているという。

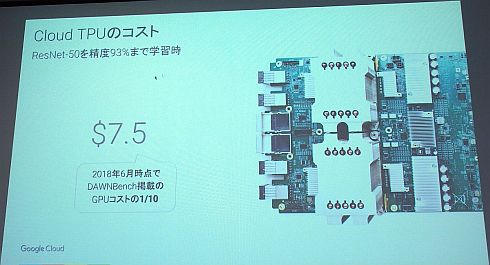

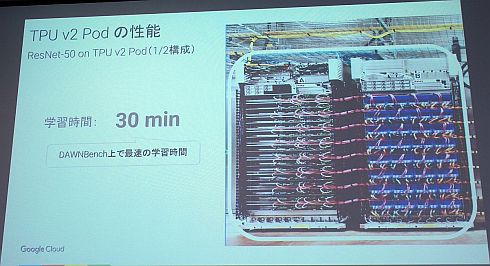

このTPU v2は、クラウド上でディープラーニングを行うグーグルのサービス「Cloud TPU」に利用されている。Cloud TPUは、初期費用なし、1時間当たり6.5米ドルという料金で利用可能だ。また、Cloud TPUはコスト効率も高く、スタンフォード大学が公開しているベンチマーク「DAWNBench」に掲載されているGPUを用いたディープラーニングの10分の1に抑えられている(画像認識のディープラーニングのベンチマークに用いられている「ResNet-50」で精度93%まで学習時で比較)。ユーザーとして、ヘッジファンド運用企業のツー・シグマ(Two Sigma)やライドシェアリングサービスのリフト(Lyft)などからの評価も得られているという。

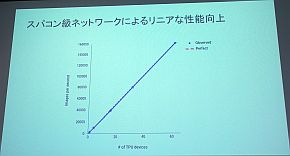

さらに、TPU v2を64ユニット組み合わせたAIスーパーコンピュータ「TPU v2 Pod」は、11.5PFLOPSという処理性能を達成した。ユニット間の接続にはスーパーコンピュータと同等のネットワーク技術を用いており、CPUやGPUでは難しい「使用するユニット数に比例して性能が伸びるリニアな性能向上を実現できている」(佐藤氏)。

なお、TPU v2 Podの性能は、半分の32ユニットを用いた場合で先述のDAWNBenchで最速となるスコアをマークしている。

2018年5月のGoogle I/O 2018では、冷却システムをTPU v2の空冷から水冷に変更した「TPU 3.0」を発表している。TPU 3.0は、1ユニット当たりの処理性能よりも、複数のユニットを組み合わせたAIスーパーコンピュータとするときの実装密度の高さにフォーカスしている。「TPU v2の巨大なヒートシンクが不要になることで実装密度が大幅に高まった」(佐藤氏)。

TPU 3.0で構成される「TPU 3.0 Pod」は、TPU v2 Podの8倍に当たる100PFlops以上の性能を実現している。佐藤氏は「理化学研究所の『京』が10PFlopsなので、その10倍の性能だ。ただし京は、科学技術計算のため計算精度は32ビットや64ビットであることも考慮する必要がある」と説明する。

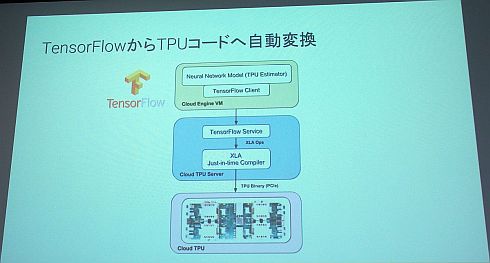

そして、これらのTPUを用いたディープラーニングは、グーグルが開発したTensorFlowを用いることによって最大の力を発揮する。なぜなら、グーグルのクラウドサービスでは、TensorFlowからTPU上で実行するためのTPUコードへの変換を自動で行ってくれるからだ。また、Cloud TPUですぐに使えるもモデルも多数提供されている。

なお、製造業におけるディープラーニングの活用では、クラウドだけでなく、エッジデバイス上で推論実行を行いたいというニーズも多い。これは、製造業のアプリケーションではリアルタイム性が求められることが多く、クラウド利用による遅延時間が問題になることがあるからだ。また、クラウドとの通信データ量の大きさも課題になる。

そういったエッジデバイス対応に向けて、グーグルは推論のためのニューラルネットワークをより軽量化できる「TensorFlow Lite」を発表している。スマートフォンのOSであるAndroidやiOS上での実行に対応するとともに、クアルコムのプロセッサで低遅延を実現した事例もあるという。「IoT(モノのインターネット)活用のPoC(概念実証)で広く利用されている『Raspberry Pi』上でも十分に実行できる」(佐藤氏)としている。

関連記事

AIと機械学習とディープラーニングは何が違うのか

AIと機械学習とディープラーニングは何が違うのか

技術開発の進展により加速度的に進化しているAI(人工知能)。このAIという言葉とともに語られているのが、機械学習やディープラーニングだ。AIと機械学習、そしてディープラーニングの違いとは何なのか。 機械学習はどうやって使うのか――意外と地道な積み重ね

機械学習はどうやって使うのか――意外と地道な積み重ね

前編では、AI(人工知能)と機械学習、ディープラーニングといった用語の説明から、AIを実現する技術の1つである機械学習が製造業を中心とした産業界にも徐々に使われ始めている話をした。後編では、機械学習を使ったデータ分析と予測モデル作成について説明する。 世界を変えるAI技術「ディープラーニング」が製造業にもたらすインパクト

世界を変えるAI技術「ディープラーニング」が製造業にもたらすインパクト

人工知能やディープラーニングといった言葉が注目を集めていますが、それはITの世界だけにとどまるものではなく、製造業においても導入・検討されています。製造業にとって人工知能やディープラーニングがどのようなインパクトをもたらすか、解説します。 ディープラーニングの事業活用を可能にする「ジェネラリスト」の重要性

ディープラーニングの事業活用を可能にする「ジェネラリスト」の重要性

AI技術として注目を集めるディープラーニング。ディープラーニングへの取り組みを進めていく上で必要とされる人材には「エンジニア」の他に「ジェネラリスト」も必要だ。本稿では、ディープラーニングの「ジェネラリスト」に何が求められるかについて解説する。 遅れてきた本命、グーグルのIoTはアマゾンとマイクロソフトに太刀打ちできるか

遅れてきた本命、グーグルのIoTはアマゾンとマイクロソフトに太刀打ちできるか

これまで、マイクロソフトの「Azure IoT」、アマゾンの「Amazon Alexa」を紹介してきたが、グーグルの動向に触れないわけにはいかないだろう。さまざまなてこ入れ策を打ち出しているグーグルだが、IoTでアマゾンとマイクロソフトに太刀打ちできるのだろうか。 タダでソフト開発の生産性と品質を上げる方法(5):グーグルの隠し球的単体テストツール「GoogleTest」

タダでソフト開発の生産性と品質を上げる方法(5):グーグルの隠し球的単体テストツール「GoogleTest」

「タダでソフト開発の生産性と品質を上げる方法」の第5回。今回は、IT業界の巨人、グーグル(Google)製の単体テストフレームワーク「GoogleTest」を紹介する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

コーナーリンク