産総研がAIスパコン「ABCI 3.0」を一般提供、産官学の大規模生成AI研究を加速:人工知能ニュース(1/2 ページ)

産業技術総合研究所(産総研)は、柏センター(千葉県柏市)内に構築した大規模AI計算システム「ABCI 3.0」の一般提供を開始したと発表した。

産総研グループは2025年1月20日、柏センター(千葉県柏市)で会見を開き、同センター内に構築した大規模AI(人工知能)計算システム「ABCI 3.0」の一般提供を開始したと発表した。

LLM(大規模言語モデル)の研究や開発などを進めるには高性能なスーパーコンピュータ(スパコン)が必要だが、AIスタートアップを含めた民間企業や研究機関が用意するには投資負担が大きい。そこで、AIの研究者や開発者が誰でも試せる環境として構築されたオープンアーキテクチャのシステムがABCI(AI Bridging Cloud Infrastructure、AI橋渡しクラウド)である。これまで、パナソニック、日立製作所、富士通、三菱重工業といった日本を代表する企業の他、Laboro.AI、Linne、Preferred Networks、T2などのスタートアップが利用し、AI技術の研究や開発でさまざまな成果を挙げてきた。

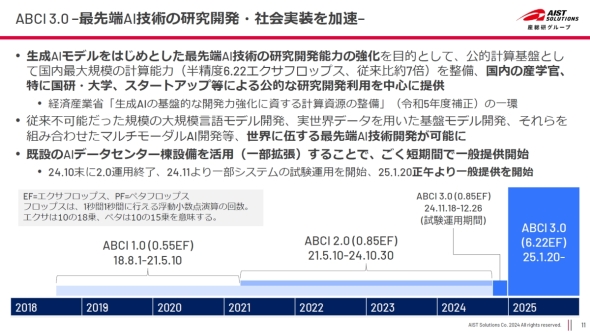

最先端AI技術の研究開発の場となることや社会実装への橋渡しを目的に、国研、大学、民間企業およびAIスタートアップに提供されてきたABCIシステム。2018年8月に稼働した「ABCI 1.0」(NVIDIA V100×4352個)、2021年5月に増強された「ABCI 2.0」(NVIDIA A100×960個)の後継として、「ABCI 3.0」が構築された[クリックで拡大] 出所:産総研グループ

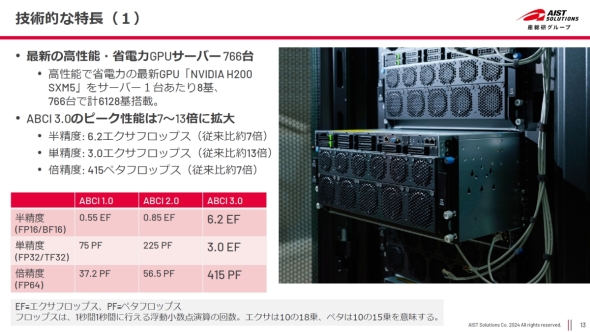

最先端AI技術の研究開発の場となることや社会実装への橋渡しを目的に、国研、大学、民間企業およびAIスタートアップに提供されてきたABCIシステム。2018年8月に稼働した「ABCI 1.0」(NVIDIA V100×4352個)、2021年5月に増強された「ABCI 2.0」(NVIDIA A100×960個)の後継として、「ABCI 3.0」が構築された[クリックで拡大] 出所:産総研グループ今回一般提供が始まったABCI 3.0は、その名前の通りABCIとして第3世代にあたる。マルチモーダルを含む基盤モデルの学習の高速化に焦点を当てて設計されており、ABCI 3.0の理論ピーク性能は、半精度で6.2EFLOPS(ABCI 2.0の7.3倍)、単精度で3.0EFLOPS(同13.3倍)、倍精度で415PFLOPS(同7.3倍)と国内トップレベルである。

ABCI 3.0と従来世代との性能比較。理論ピーク性能において、半精度と倍精度で7倍以上、単精度で13倍以上の性能向上を図っている。図内の右は5U高さのHPE Cray XD670(前面)で、NVIDIA H200 SXM5 TensorコアGPUを8個搭載している[クリックで拡大] 出所:産総研グループ

ABCI 3.0と従来世代との性能比較。理論ピーク性能において、半精度と倍精度で7倍以上、単精度で13倍以上の性能向上を図っている。図内の右は5U高さのHPE Cray XD670(前面)で、NVIDIA H200 SXM5 TensorコアGPUを8個搭載している[クリックで拡大] 出所:産総研グループ生成AIの研究開発が盛んになったことでABCI 2.0の利用も増大し、システム利用率が100%近くに張り付くこともあって利用者のニーズに応えられていなかったが、その課題をより高性能なABCI 3.0で解消していく考えだ。ABCI 2.0では1000億パラメーター程度のLLMの開発実績があるが、ABCI 3.0では1兆パラメーター近くまで対応できる見通しだ。

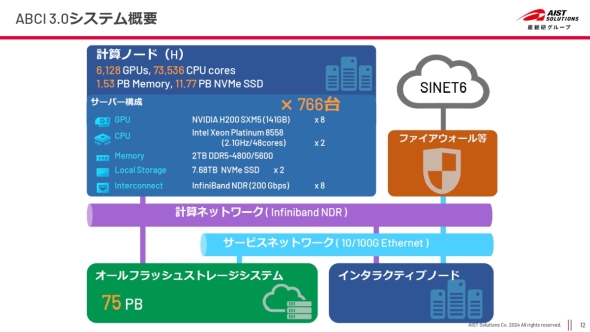

ハードウェアは、141GBのGPUメモリを内蔵するNVIDIA H200 SXM5 TensorコアGPUを8個と、Intel Xeon Platinum 8558プロセッサーを2個搭載するHPE Cray XD670を766台組み合わせて構築しており、総GPU数は6128個に達する。ノード間のインターコネクトは200GbpsのInfiniBand NDRを採用。また、オールフラッシュで構成した75PBのストレージシステムを備える。

イニシャルコストと初年度のハードウェア保守費を含んだ事業費は約350億円で、日本ヒューレット・パッカードが落札した。その他に12億円を掛けて冷却系や電源系の増強を図った。

ABCI 3.0のハードウェア概略構成。141GBのGPUメモリを内蔵するNVIDIA H200 SXM5 TensorコアGPUを8個と、Intel Xeon Platinum 8558プロセッサーを2個搭載した、766台のHPE Cray XD670で構成される。ストレージシステムはQLC(クワッドレベルセル)を使ったオールフラッシュで、容量は75PBである[クリックで拡大] 出所:産総研グループ

ABCI 3.0のハードウェア概略構成。141GBのGPUメモリを内蔵するNVIDIA H200 SXM5 TensorコアGPUを8個と、Intel Xeon Platinum 8558プロセッサーを2個搭載した、766台のHPE Cray XD670で構成される。ストレージシステムはQLC(クワッドレベルセル)を使ったオールフラッシュで、容量は75PBである[クリックで拡大] 出所:産総研グループCopyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

- 1.5km離れた漁場をWi-Fi HaLowなどで可視化、海洋モニタリングの実証に成功

- STPAの第4ステップで忘れがちな「損失シナリオ識別」の詳細手順

コーナーリンク