産総研の最新スパコン「ABCI 3.0」が生成AIの研究開発と社会実装を加速する:AIとの融合で進化するスパコンの現在地(5)(2/4 ページ)

2016年から構想が始まり、2018年に初代「ABCI 1.0」が稼働

国の研究機関である産総研でABCIの初代システム(便宜上「ABCI 1.0」とする)の構想が始まったのは2016年である。その前年の2015年はAIの第3ブームの元年と言われた年であり、翌2016年にはDeepMindが開発した「AlphaGo」が韓国のトップ棋士イ・セドル氏に勝利して話題になるなど、ディープラーニングの関心が高まってきた時代だ。

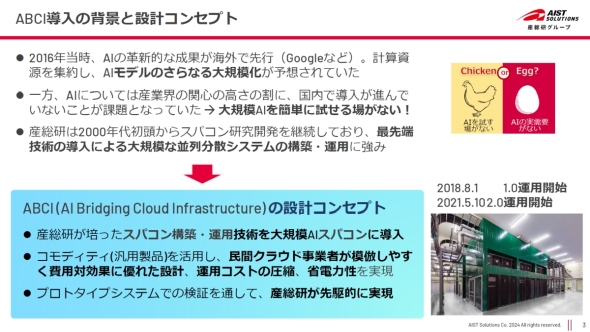

当時、「AI」がディープラーニングや機械学習の代名詞となる一方で、国内ではアルゴリズムなどの研究開発やアプリケーションの応用拡大がそれほど進んでいなかった。そこでAIの速やかな導入を試す「場」として構想されたのがABCIである(図3)。

図3 ABCIは大規模AIの研究開発を試す「場」として構想された。設計においては、市販されているコモディティなハードウェア製品の活用、省電力化の徹底などがコンセプトに掲げられた[クリックで拡大] 出所:産総研 「ABCI 3.0記者見学会」

図3 ABCIは大規模AIの研究開発を試す「場」として構想された。設計においては、市販されているコモディティなハードウェア製品の活用、省電力化の徹底などがコンセプトに掲げられた[クリックで拡大] 出所:産総研 「ABCI 3.0記者見学会」初代のABCI 1.0は、NVIDIA Tesla V100 SXM2モジュールを4枚搭載した1088台のノードで構成され、総GPU数は4352基であった。稼働開始は2018年8月1日である。

設計に当たっては、産総研の人工知能研究センターが運用してきたAIクラウド「AAIC(AIST Artificial Intelligence Cloud)」(NVIDIA Tesla P100 GPU×400基)や、東京工業大学(現東京科学大学)が2017年に構築したスパコンシステム「TSUBAME 3.0」の知見が反映された。

ABCI 1.0の性能は、倍精度で37.2PFLOPS、単精度で75PFLOPS、半精度で550PFLOPSで、2018年6月に公表されたTOP500ベンチマークで第5位にランクされた。※3)また、省エネ性能の指標であるGreen500ベンチマークでは第8位であった。

※3)産総研プレスリリース:大規模AIクラウド計算システム「ABCI」がスパコン性能ランキング世界5位

2021年5月には、ABCI 1.0の設備はそのままに、NVIDIA A100 Tensor コア SXM4モジュールを8枚搭載したノード120台とファイルシステムの増強が行われた。このシステムを「ABCI 2.0」と呼ぶ。GPUの総数は既設分4352+増設分960=5312基である。

ABCI 2.0の性能は、ABCI 1.0と同時に運用した場合、倍精度で56.5PFLOPS、単精度で226.0PFLOPS、半精度で851.5PFLOPSであった(表1)。2021年6月のTOP500では世界12位を記録した。※4)

※4)産総研ニュース:大規模AIクラウド計算システム「ABCI 2.0」がスパコン性能ランキングでランクアップ

| ABCI 1.0 | ABCI 2.0 | ABCI 3.0 | |

|---|---|---|---|

| GPU | NVIDIA V100×4352 | NVIDIA V100×4352+NVIDIA A100×960 | NVIDIA H200×6128 |

| 倍精度(FP64) | 37.2PFLOPS | 56.5PFLOPS | 415PFLOPS |

| 単精度(FP32/TF32) | 75PFLOPS | 225PFLOPS | 3.0EFLOPS |

| 半精度(FP16/TF16) | 0.55EFLOPS | 0.85EFLOPS | 6.2EFLOPS |

| 表1 歴代のABCIシステムの性能比較(PFLOPS=毎秒1000兆回、EFLOPS=毎秒100京回) | |||

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

コーナーリンク