オンプレ環境でも学習容易に リコーが日英中対応の700億パラメータLLM発表:人工知能ニュース

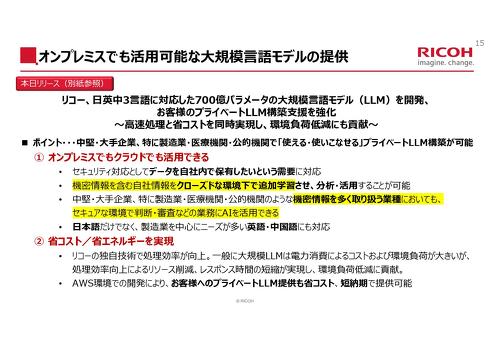

リコーは日英中の3か国語に対応した700億パラメータの大規模言語モデルを開発したと発表した。

リコーは2024年8月21日、日英中の3か国語に対応した700億パラメータの大規模言語モデルを開発したと発表した。オンプレミスとクラウド環境のどちらでも活用できる。同年秋から顧客に提供する。

製造業のニーズから中国語も対応

今回発表したLLMは、Metaが提供する「Llama-3」(700億パラメータ)を基に東京工業大学と産業技術総合研究所が公開した「Llama-3 Swallow」(同)をベースに、リコーが独自に開発したものだ。AI(人工知能)の自然言語学習に用いるコーパスの選定や、データクレンジング、学習順などを決めるカリキュラム学習にリコー独自のノウハウを用いることで、安定的な日本語の回答精度を実現した。

トークナイザ―を独自開発して処理効率を向上させることで、処理用リソースの削減や、レスポンス時間の向上などを達成した。導入ケースに合わせて統計的に使用頻度の少ない語彙を排除する独自技術も採用した。この技術などを活用することで、モデルサイズが肥大化することなく、必要な語彙が学習できる仕組みを整えている。これによって、オンプレミスなど非クラウド環境下でも、機密情報を含めた追加学習が可能になる。

開発に際しては、AWSジャパンが提供する「AWS LLM開発支援プログラム」と「AWS 生成AI イノベーションセンター」による支援を受けた。AI学習用のアクセラレータ「AWS Trainum」を搭載した「Amazon EC2 Trn1インスタンス」を活用することで、顧客に合わせたカスタマイズLLMの開発コスト、開発期間の短縮を図る。

ベンチマーク評価用の「ELYZA-tasks-100」を用いて、Llama-3や日本語対応の継続事前学習をさせたLLMとスコアなどを比較したところ、リコーが開発したモデルは平均で4を超えるスコアを示した。

以前リコーが発表した130億パラメーターのLLMとの相違点として、中国語に対応した点が挙げられる。製造業を中心に寄せられていた、社内に中国語で蓄積されたナレッジをRAG(Retrieval-Augmented Generation)などの形式で活用したい、というニーズに応えた形だ。なお、130億パラメータのLLMも、ポートフォリオの1つとして引き続き顧客への提案に加える。

製造業の他、金融業や自治体、流通/小売業、教育、医療分野での活用を想定する。特に製造業に関して、リコー担当者は「製造業からは、設計業務でLLMを活用したいという要望も受けている。今後、図表の解釈への対応を検討したい」と展望を語った。

関連記事

リコーが130億パラメーターの日英対応LLM開発 AWSジャパンの支援プログラム活用

リコーが130億パラメーターの日英対応LLM開発 AWSジャパンの支援プログラム活用

AWSジャパンは2024年1月31日、国内に拠点を持つ企業や団体を対象に、大規模言語モデル開発を支援する「AWS LLM 開発支援プログラム」の成果発表会を開催した。同プログラム参加者のうち、NTTとリコー、ストックマートが登壇し、成果を紹介した。3者の発表内容を順に紹介する。 産業界で使い倒せる日本語LLMを リコーが自前のモデル開発に取り組み始めたワケ

産業界で使い倒せる日本語LLMを リコーが自前のモデル開発に取り組み始めたワケ

世界中で大規模言語モデル(LLM)の開発成果が次々に発表されている。国内でも日本語対応のLLM開発に取り組む企業が表れているが、その1社がリコーだ。130億パラメーターの日英両言語対応LLMを作った同社に、開発の狙いや今後の戦略を聞いた。 今度は「1000万ドル相当」を支援 生成AIの実用化推進プログラム募集開始

今度は「1000万ドル相当」を支援 生成AIの実用化推進プログラム募集開始

AWSジャパンは生成AIモデルの開発、改良やビジネス課題の開発を図る企業や団体を対象とした「AWSジャパン生成AI実用化推進プログラム」を開始すると発表した。 中外製薬がデジタル創薬でAWS採用、社外との研究連携基盤構築コストが10分の1に

中外製薬がデジタル創薬でAWS採用、社外との研究連携基盤構築コストが10分の1に

アマゾン ウェブ サービス ジャパン(AWSジャパン)と中外製薬は、同社の全社データ利活用基盤「CSI」がAWSのクラウド基盤を採用したと発表。中外製薬は2020年末までに、革新的新薬の創出を目指す社外研究者との100件の研究プロジェクトの運用に向けてCSI上に研究開発環境を整備する計画である。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

製造マネジメントの記事ランキング

- 生産性100倍に、富士通がソフトウェア開発をAIエージェントで自動化する開発基盤

- 従業員のスキルに応じた「ランク認定制度」も 三菱電機が推進するDX人材育成施策

- 日本は本当に遅れているのか? AI×現場力で始まる日本型モノづくりの逆襲

- 「好きなことは楽しめる間にとことん楽しむ」という考え方の重要性について

- アイリスオーヤマなど、無線制御技術を軸に建設業界の課題解決に向けた協業開始

- IOWN APNと画像認識AIにより、約300km離れた工場での外観検査に成功

- AIエージェントが代わりに働くようになったら人は何をするの?

- 永守氏がニデック完全退任、「経営者としての私の物語にピリオド」

- パナソニックは新技術拠点「Technology CUBE」で“実装力のあるR&D”を強化

- 富士フイルムBIがトルコ企業を買収、基幹システム導入の海外展開加速

コーナーリンク