製造業の生成AI活用に3つの道筋、製造現場などでの活用事例を探る:製造現場向けAI技術(2/4 ページ)

製造現場での業務ヘルプにも貢献

旭鉄工の事例は製造現場の改善活動の効率化を狙うものだが、製造現場の業務自体の効率化を目指す動きもある。2023年4月にドイツで開催された「ハノーバーメッセ2023」では、Hewlett Packard Enterprise(HPE)が大規模言語モデルを活用して構築した、現場作業員が産業用ロボットについて自然言語や画像で質問できるAIアシスタントのデモを公開した。

例えば、現場作業員がタブレット端末を通じて「ロボットを起動するにはどうすればよいか」とテキスト(デモでは音声認識による問いかけ)で尋ねると、AIアシスタントがスタートボタンの位置を回答する。さらに、作業者がスタートボタンの画像を撮影して「これがスタートボタンか」と聞くと、その正誤を対話形式で答えてくれる。

緊急事態が発生した場合には、ロボットの停止スイッチの位置を指示する他、ロボットアームの交換方法なども説明するデモがあったという。エラー修復のサポートにも対応していたようだ。

ちなみにこのデモでは、ドイツのスタートアップであるAleph Alphaが持つ独自のLLM「Luminous」が活用されていた。同LLMは大手競合他社のLLMと比較するとパラメーター数は半分程度だが、自然言語推論や読解などでそれらに匹敵するようなパフォーマンスを発揮したという。

なお、ここで紹介したHPEの事例はロボット操作をLLMで支援するものだが、ロボットへのティーチングや動作制御の領域で対話型AIを活用する事例もすでに出てきており、マイクロソフトやグーグルの他さまざまな企業が取り組んでいる。例えば、2023年2月にはマイクロソフトが、ユーザーが指示したタスクから適したコードをChatGPTが推論、生成して、ロボットアームを制御するデモを公開した。ロボットの基本動作を組み合わせた高レベルのライブラリをあらかじめ定義しておき、このライブラリを基にChatGPTを通じて曖昧な動作指示を与えることでジグザグ飛行を行い、棚を検査することにも成功したようだ。

パナソニック グループでもGPT-4を活用し、自然言語文からロボットの制御コードを生成し、自律制御を行う研究事例を発表している。エンドエフェクタ座標や関節角、関節速度、物体位置などの情報を伴わず、自然言語文で未知のタスクや動作を指示したところ、タスクを解決するためのコード生成とロボット制御が高確率で可能になることをシミュレーション環境で確認したとする。例えば「箱を大きさ順に積み上げて」と指示すると、「大きさ」の尺度を具体的に指定せずともロボットはその通りに動作する。

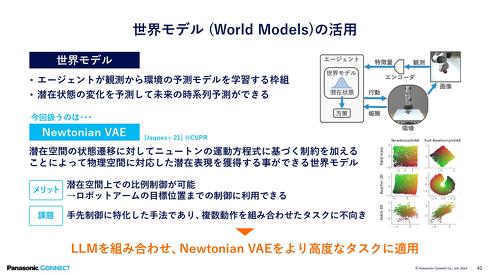

ロボットに動作を学習させるための強化学習においては、現実世界の観測から予測モデルを構築する枠組みである「世界モデル」の活用に注目が集まっている。同社の研究事例では、世界モデルの一種であるニュートンの運動方程式による制約を加えた「Newtonian VAE(変分オートエンコーダー)」をLLMと組み合わせる形で使用した。

Copyright © ITmedia, Inc. All Rights Reserved.

製造マネジメントの記事ランキング

- 生産性100倍に、富士通がソフトウェア開発をAIエージェントで自動化する開発基盤

- 従業員のスキルに応じた「ランク認定制度」も 三菱電機が推進するDX人材育成施策

- 日本は本当に遅れているのか? AI×現場力で始まる日本型モノづくりの逆襲

- 「好きなことは楽しめる間にとことん楽しむ」という考え方の重要性について

- パナソニックは新技術拠点「Technology CUBE」で“実装力のあるR&D”を強化

- アイリスオーヤマなど、無線制御技術を軸に建設業界の課題解決に向けた協業開始

- IOWN APNと画像認識AIにより、約300km離れた工場での外観検査に成功

- AIエージェントが代わりに働くようになったら人は何をするの?

- 永守氏がニデック完全退任、「経営者としての私の物語にピリオド」

- 「中国のスペースX」銀河航天は衛星をどう量産するのか 製造デジタル基盤の全貌

コーナーリンク