脳型AI半導体のBrainChipが第2世代IPを投入、エッジ活用に向け本格提案:人工知能ニュース(2/2 ページ)

「NVIDIAの『Jetsonシリーズ』を置き換える実力がある」

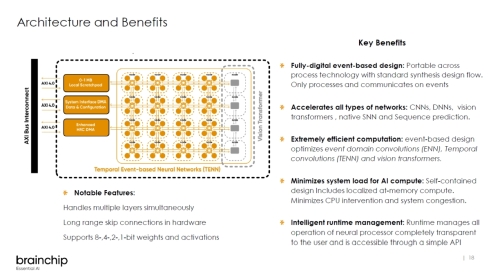

第2世代IPであるAkida 2.0は、新たなアーキテクチャとしてTENN(Temporal Event-Based Neural Networks)を採用するとともに、画像認識を効率よく行えるビジョントランスフォーマーをハードウェアとして実装している。また、ResNetなどで広く知られているスキップ接続にも対応しており、量子化のビット数でもこれまでの1/2/4ビットに加えて、AIの技術開発で広く用いられている8ビットもサポートした。

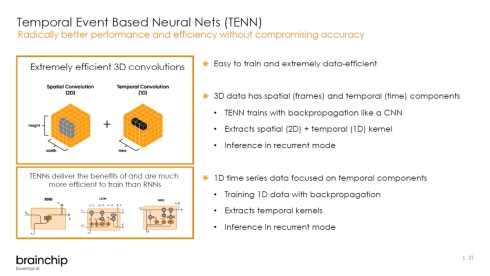

中でもTENNはAkida 2.0の大幅な進化に貢献している。ニューロモーフィック技術はイベントベース処理が基軸となるが、TENNはニューラルネットワークの畳み込み(Convolution)に時間軸(Temporal)を加えることで計算量を大幅に削減することが可能になった。さらに、この時間軸を用いることで推論アルゴリズムを環境変化に合わせた最適化などで求められる追加学習も行えるという。

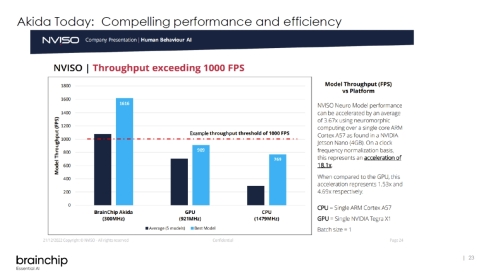

実際に、NVISOというAI企業がAkida 2.0とArmのCPU「Cortex-A57」、NVIDIAのSoC「Tegra X1」のGPU(「Jetson TX1」などに搭載されている)のAI処理速度を比較したところ、動作周波数300MHzのAkida 2.0が、同約1.5GHzのCortex-A57や同927MHzのTegra X1のGPUを上回ったという。「周波数1MHz当たりの性能で見れば、Cortex-A57の18.1倍に達する」(Hehir氏)。

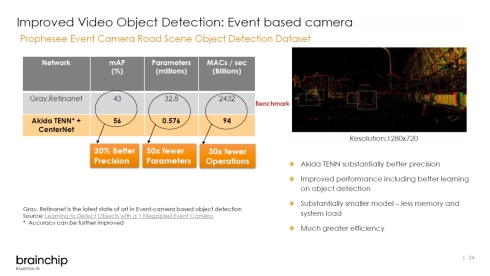

さらに、ニューロモーフィック技術が得意とするイベントベース処理を活用したイベントベースカメラによる物体認識(通常のカメラの画像認識はフレームレートデータを用いる)では、精度、パラメーター数、1秒当たりの積和演算(MAC)数などについて、オープンソースで公開されているベンチマークデータを大きく上回った。特に、消費電力に効いてくるパラメーター数は50分の1、1秒当たりの積和演算数は30分の1と桁違いに抑えられている。

AIモデルの構築についても、Akida 2.0で一から構築する必要はなく、ソフトウェア開発環境の「metaTF」を用いて、TensorFlowやPyTorchで開発したAIモデルをデプロイできる。

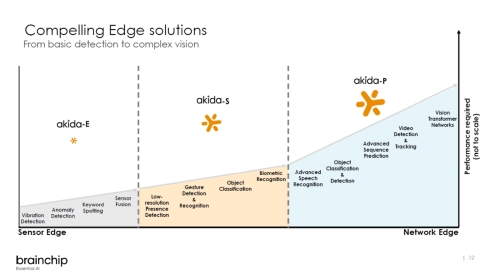

なお、Akidaのロードマップ上では、これまでAkida 1.0で展開してきたマイコンなどとの連携を想定したエンドポイント向けは「Akida-E」となり、Akida 2.0についてはミッドレンジの「Akida-S」、Akida-Sからさらにノード数を増やしたハイエンドの「Akida-P」を展開していく。Hehir氏は「Akida-Pは低消費電力で高精度かつ低コストを実現し、NVIDIAの『Jetsonシリーズ』を置き換える実力がある」と述べている。

関連記事

芽吹くか「組み込みAI」

芽吹くか「組み込みAI」

第3次ブームを迎えたAI(人工知能)。製造業にとっても重要な要素技術になっていくことは確実だ。2017年からは、このAIを製品にいかにして組み込むかが大きな課題になりそうだ。 脳の空間認知機能を再現する、小型の脳型AIハードウェアを開発

脳の空間認知機能を再現する、小型の脳型AIハードウェアを開発

東芝は、ジョンズホプキンス大学と共同で、小型の脳型AIハードウェアを開発し、海馬の空間認知機能の一部を模倣・再現することに成功した。脳機能研究の進展や、高い空間認知能力が求められる自律型ロボットなどの小型化、低電力化に貢献する。 インテルはAIで勝ち残れるのか、脳科学研究から生まれた「Crest」に賭ける

インテルはAIで勝ち残れるのか、脳科学研究から生まれた「Crest」に賭ける

世界最大の半導体企業であるインテルだが、AIやディープラーニングに限ればその存在感は大きいとはいえない。同社は2017年3月にAI製品を開発するAIPGを発足させるなど、AI関連の取り組みを強化している。2017年3月に発足したAI製品事業部の副社長兼CTOを務めるアミール・コスロシャヒ氏に話を聞いた。 AIに最適な脳型LSI、東北大が脳機能のモジュール化で2019年度に実現へ

AIに最適な脳型LSI、東北大が脳機能のモジュール化で2019年度に実現へ

東北大学の電気通信研究所は、2014〜2019年度のプロジェクトで、AI(人工知能)に最適な脳型LSIの開発を進めている。脳機能をモジュール化して計算効率を高め、人間の脳と同等レベルの処理能力と消費電力を持つ脳型LSIの実現につなげたい考えだ。 シンギュラリティは今の人工知能技術の先にはない――ガートナー

シンギュラリティは今の人工知能技術の先にはない――ガートナー

ガートナージャパンは、2017年における戦略的テクノロジートレンドのトップ10を発表。3つの傾向として「デジタルメッシュ」「どこでもインテリジェンスとなる世界」「デジタルプラットフォーム革命」を挙げている。 NECがAI事業強化「思考の拡大」目指す、「脳型コンピュータ」開発も

NECがAI事業強化「思考の拡大」目指す、「脳型コンピュータ」開発も

NECが人工知能関連事業を強化、人員を現在の倍にあたる1000人に拡大する。増員によってAI事業の適用範囲拡大を図り売り上げ2500億円を目指す。AI活用基盤として、脳型コンピュータの開発も進める。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- フォックスコンがフィジカルAIで実現する「AX」とは、NVIDIAと川崎重工も講演

- 生成AI実行時の消費電力が10W以下に SiMa.aiのSoC「Modalix」の実証結果を公開

- いまさら聞けないエッジAIとクラウドAIの違い “現場処理回帰”の必然性とは

- 月面を照らす「光の物差し」 JAXAとカシオが可視光測位技術を実証

- 1μF以下の極小コンデンサーでも安定動作する500mA対応LDOレギュレーター

- 時代はDXからAIが当たり前に浸透する「IX」に突入へ CES 2026の内容をひもとく

- 高速起動とREST APIで高性能なデータ取得を自動化する測定コア

- 愛猫の不調を見逃さない、LIXILが非接触呼吸計測デバイスを開発

- 衛星通信向け量子鍵配送送受信システムの小型化と高速化に成功

- 105℃の高温に対応する細径高屈曲ロボットケーブルを発売

コーナーリンク