NVIDIAが新GPUアーキテクチャ「Hopper」を発表、AI処理性能は4000TFLOPSへ:組み込み開発ニュース(2/2 ページ)

「H100」は2022年第3四半期に出荷予定

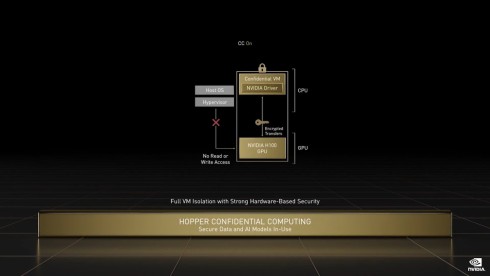

4つ目の「コンフィデンシャルコンピューティング」は、仮想マシン上でCPUとGPUの間のやりとりをRoot of Trustなどを使用してハードウェアベースの暗号化を行うことにより、ホストOSやハイパーバイザーなどから完全に分離し、AIの学習中であってもAIモデルや顧客データの秘密を守る機能である。これまでコンフィデンシャルコンピューティングはCPU上でしか実行できなかったが、H100によってGPUベースのコンフィデンシャルコンピューティングが可能になった。

5つ目の「第4世代NVIDA NVLink」は、先述した通りH100の外部インターコネクトとして採用されている。この第4世代NVIDA NVLinkに対応する形でデータセンター向けに新開発したスイッチシステム「NVLink Switch」を用いて256個のH100をマルチノード接続した場合、従来比で9倍の帯域幅を確保できるという。

6つ目の「DPXインストラクション」は、経路最適化やゲノム科学などに用いられている計算アルゴリズムの動的計画法(Dynamic Programming)の処理性能を高速化する新たな命令セットになる。H100でDPXインストラクションを用いた場合、CPUと比べて40倍、前世代のGPUであるA100と比較して7倍の処理性能を動的計画法で発揮できる。

H100は2022年第3四半期に出荷予定で、クラウドサービスプロバイダーやコンピュータ機器メーカーを経てユーザーが利用できるようになる予定だ。また、8個のH100を搭載する「DGX H100」、32台のDGX H100をNVLink Switchで接続した「DGX H100 SuperPOD」などの形でも提供していく。DGX H100 SuperPODをさらに拡張してDGX H100を576台接続した「NVIDIA EOS」も開発している。そのAI処理性能は18EFlops(エクサフロップス)に達し、現在スパコン性能ランキングで1位の「富岳」の4倍になるという。

NVIDIAのCPUやGPUを組み合わせたカスタムシリコンも

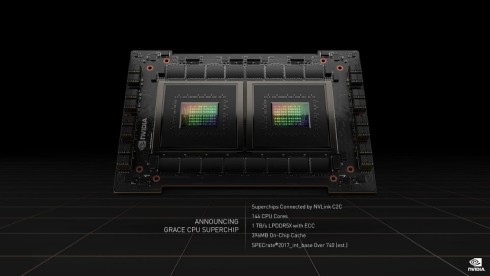

一方、Grace CPU Superchipは、SPECrate 2017_int_baseのベンチマークで740を記録するなど、現在競合他社が開発中のCPU製品を上回る性能を実現しているという。メモリシステムにLPDDR5xを採用しており、帯域幅は一般的なDDR5の2倍の1TB/sを実現。メモリを含めた消費電力も500Wに抑えた。Grace CPU Superchipは2023年上期に市場投入する計画だ。

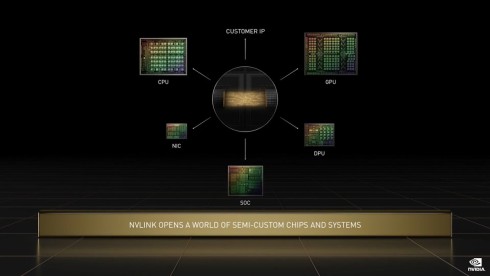

2つのCPUチップから成るGrace CPU Superchipで重要な役割を果たしているのが、チップ間高速インターコネクト技術のNVLink-C2Cである。NVIDIAは、第4世代NVIDIA NVLinkと同じ900GB/sの帯域幅を持つNVLink-C2Cを用いて、同社のCPUやGPU、DPU(Data Processing Unit)の「BlueField」、NIC(ネットワークインタフェースカード)、SoCである「Jetsonシリーズ」などをつなげ、パートナーや顧客のニーズに応じてカスタマイズしたシリコンデバイスを提供する方針も明らかにした。

関連記事

“GPUのNVIDIA”がCPU製品「Grace」を投入、スパコンのAI性能が10倍に

“GPUのNVIDIA”がCPU製品「Grace」を投入、スパコンのAI性能が10倍に

NVIDIAは、オンラインで開催中のユーザーイベント「GTC 2021」の基調講演において、巨大AIモデルやHPCのワークロードを処理するデータセンター向けのCPU「Grace」を発表した。Armの次世代サーバ向けプロセッサコアを搭載するGraceなどを用いたAIシステムは、x86ベースのCPUを用いる既存のAIシステムと比べて大幅な性能向上を実現するという。 AIデータセンターの性能が20倍に、NVIDIAがAmpere世代のGPU「A100」を発表

AIデータセンターの性能が20倍に、NVIDIAがAmpere世代のGPU「A100」を発表

NVIDIA CEOのジェンスン・フアン氏は、YouTubeでオンデマンド配信した「GTC 2020」の基調講演において、新たなアーキテクチャ「Ampere」を採用したGPU「NVIDIA A100」を発表した。 NVIDIAの第8世代GPU「Turing」は、レイトレーシングとAI向けで2つのコアを採用

NVIDIAの第8世代GPU「Turing」は、レイトレーシングとAI向けで2つのコアを採用

NVIDIAは、コンピュータグラフィックスのイベント「SIGGRAPH 2018」において、第8世代のGPUアーキテクチャ「Turing(チューリング)」と、Turingを搭載するプロ向けGPUボードの新製品「Quadro RTX 8000/6000/5000」を発表した。 「Jetson AGX Orin」はAmpereアーキテクチャを搭載、処理性能は200TOPSに到達

「Jetson AGX Orin」はAmpereアーキテクチャを搭載、処理性能は200TOPSに到達

NVIDIAが組み込み機器向けAIモジュールの最新モデルとなる「Jetson AGX Orin」を発表。同社の最新GPUアーキテクチャである「Ampere」を採用するなどして、前モデルの「Jetson AGX Xavier」と同じフォームファクターとピン互換性を維持しながらAI処理性能で6倍となる200TOPSを達成した。 NVIDIAが「Omniverse」の国内普及を加速、DRからCAE、デジタルツインへ

NVIDIAが「Omniverse」の国内普及を加速、DRからCAE、デジタルツインへ

NVIDIAはメディア向けブリーフィングを開催し、「GTC November 2021」において一般向け販売の開始が発表された「NVIDIA Omniverse Enterprise」の国内導入を支援する団体「NVIDIA Omniverse Partner Council Japan」を結成したことを発表した。 「TOPS競争」は次の段階へ、アップデートし続ける自動運転車向けにNVIDIAが1000TOPS

「TOPS競争」は次の段階へ、アップデートし続ける自動運転車向けにNVIDIAが1000TOPS

NVIDIAは2021年4月12日(現地時間)、オンラインで開催中のユーザーイベント「GTC(GPU Technology Conference) 2021」(開催期間:同年4月12〜16日)において、自動運転車に関する最新の取り組みを明らかにした。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

コーナーリンク