「Jetson Nano」のCUDAコアで“Hello AI World”を動作させてみる:Jetson Nanoで組み込みAIを試す(3)(2/2 ページ)

推論にかかる時間は結構変動が大きい

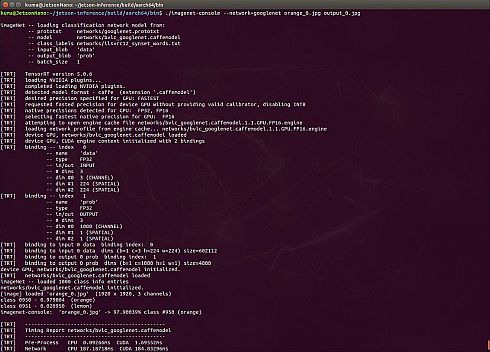

では実際に動かしてみよう。完成したバイナリは、先ほどのjetson-inference/buildの下にあるaarch64/binの下に置かれている。ここにカレントディレクトを移した上で、

$ ./imagenet-console --network=googlenet orange_0.jpg output_0.jpg

を実行すると(図8)、入力ソース(この場合だとorange_0.jpg)を読み取って分類を実施、結果をoutput_0.jpgに返す(図9)。

ちなみに--networkをresnet18にすればResNet-18が、resnet50にすればResNet-50がそれぞれ利用されることになる。

さて、表1にこれら3つのネットワークを利用してInferenceを実行した場合の所要時間と精度(というか、確率)をまとめた。精度というのは、そのネットワークが何%程度の確率でorange_0.jpgが「オレンジである」と見なしたかを示す。結果から分かるように、ネットワークによって精度や所要時間に結構なバラつきがあることが分かった。

| CPU平均所要時間(ms) | CUDA平均所要時間(ms) | Orangeである確率(%) | |

|---|---|---|---|

| GoogleNet | 113.7 | 112.9 | 97.90 |

| ResNet-18 | 99.3 | 98.7 | 99.60 |

| ResNet-50 | 133.1 | 132.4 | 99.80 |

| 表1 各ネットワークでInferenceを実行した場合の所要時間と精度 | |||

ちなみに、待機時の消費電力は4.5W程度、Inferenceを行っている時の消費電力は6.8W程度であったが、恐らくはまだフルにCUDAコアが動いているという状況ではないので、この先どの程度消費電力が増えてゆくかは引き続きチェックしたいと思う。

なお表1では所要時間の全体をまとめたが、実際にはもう少し細かく数字が出る。例えば、GoogleNetのある実行時間は、

| CPU | CUDA | |

|---|---|---|

| Pre-Process | 0.106ms | 1.711ms |

| Network | 116.998ms | 114.749ms |

| Post-Process | 0.394ms | 0.391ms |

となっており、両方にそれなりの負荷が掛かっていることが見てとれる。

ところで、表1では「平均」の値を示したが、実は結構変動が大きい。そこでこれら3つのネットワークについて、それぞれ10回ずつInferenceを実行し、合計の所要時間の平均、最大、最小と標準偏差を取ったのが表2である。なんというか、非常にバラつきが大きいのが分かる。まぁ実際には1フレーム単位での処理ではなく、それこそカメラ入力から連続的に画像を取り込んでリアルタイムに分析を行う、といった使い方がむしろ多そうなので、平均フレームレートで測定するのが正しい評価方法なのかもしれない。

| プロセッサ | 平均所要時間(ms) | 最小所要時間(ms) | 最大所要時間(ms) | 標準偏差(ms) | |

|---|---|---|---|---|---|

| GoogleNet | CPU | 113.7 | 61.3 | 189.0 | 39.1 |

| CUDA | 112.9 | 60.7 | 188.0 | 39.1 | |

| ResNet-18 | CPU | 99.3 | 53.0 | 150.2 | 34.8 |

| CUDA | 98.7 | 52.3 | 150.3 | 34.9 | |

| ResNet-50 | CPU | 133.1 | 92.9 | 273.3 | 50.7 |

| CUDA | 132.4 | 92.2 | 273.0 | 50.8 | |

| 表2 各ネットワークでInferenceを実行した場合の所要時間の平均、最大、最小と標準偏差 | |||||

関連記事

- ≫連載「Jetson Nanoで組み込みAIを試す」バックナンバー

「Jetson Nano」を“まとも”に使えるようにする

「Jetson Nano」を“まとも”に使えるようにする

NVIDIAが価格99ドルをうたって発表した組み込みAIボード「Jetson Nano」。本連載では、技術ライターの大原雄介氏が、Jetson Nanoの立ち上げから、一般的な組み込みAIとしての活用までを含めていろいろと試していく。第2回は、機械学習を試す前に“まとも”に使えるようにする。 まずは「Jetson Nano」の電源を入れて立ち上げる

まずは「Jetson Nano」の電源を入れて立ち上げる

NVIDIAが価格99ドルをうたって発表した組み込みAIボード「Jetson Nano」。本連載では、技術ライターの大原雄介氏が、Jetson Nanoの立ち上げから、一般的な組み込みAIとしての活用までを含めていろいろと試していく。第1回は、まず電源を入れて立ち上げるところから始める。 組み込みAIは必要不可欠な技術へ、推論に加えて学習も視野に

組み込みAIは必要不可欠な技術へ、推論に加えて学習も視野に

2017年初時点では芽吹きつつあった程度の組み込みAI。今や大きな幹にまで成長しつつあり、2019年からは、組み込み機器を開発する上で組み込みAIは当たり前の存在になっていきそうだ。 中高生向けの自動運転車の開発、99ドルのボードで「AIの可能性を知って」

中高生向けの自動運転車の開発、99ドルのボードで「AIの可能性を知って」

NVIDIAがユーザーイベント「GTC 2019」(2019年3月19〜21日、米国カリフォルニア州サンノゼ)で発売を発表した組み込みAI(人工知能)の開発者キット「Jetson NANO」。使い道にひときわ関心を寄せたのは、子どもを持つGTC参加者たちだ。 NVIDIAのフアンCEOが日本で初披露、組み込みAI向け新製品「NVIDIA AGX」

NVIDIAのフアンCEOが日本で初披露、組み込みAI向け新製品「NVIDIA AGX」

NVIDIAのユーザーイベント「GTC Japan 2018」の初日に行われた基調講演に、創業者兼CEOのジェンスン・フアン氏が登壇。組み込みAIを可能にする新たな製品ラインアップ「NVIDIA AGX」のローンチを発表するとともに、国内の製造業がAI開発プラットフォームとしてNVIDIAのGPUや開発プラットフォームを広く採用していることをアピールした。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- 急成長中の中国ヒューマノイド大手AgiBotの技術戦略

- 光通信入門事始め――古代の人々ののろしと同じように光で信号を送ってみよう

- 宇宙用途向け耐放射線FPGAが欧州の宇宙用部品規格の認定を取得

- AIスパコンやロボット活用で「稼げる農業」へ、農研機構と東京工科大が連携協定

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【前編】

- OKIエンジが北関東校正センターを設立「計測器校正は第三者校正が主流に」

- イチから全部作ってみよう(29)3つのノート整理法からたどるRDBMSの基礎知識

- IIJの法人モバイル契約数が350万回線に、マルチプロファイルSIM2.0の特許も取得

- IoTゲートウェイの課題はデータの欠損と変換、IIJ子会社が新コンセプトで解決へ

- デジタルツイン向けマルチLiDAR異常検知技術を開発

コーナーリンク