MATLABが深層学習関連機能を拡充、NVIDIAの「GPU Cloud」にも対応:人工知能ニュース

MathWorks Japanはモデルベース開発環境「MATLAB/Simulink」の最新バージョン「R2018b」で強化した深層学習(ディープラーニング)関連の機能について説明。MATLABが、NVIDIAのGPUに最適化された深層学習関連ソフトウェアのコンテナレジストリ「NVIDIA GPU Cloud(NGC)」に対応したことも発表した。

MathWorks Japanは2018年10月30日、東京都内で会見を開き、モデルベース開発環境「MATLAB/Simulink」の最新バージョン「R2018b」で強化した深層学習(ディープラーニング)関連の機能について説明するとともに、MATLABがNVIDIAのGPUに最適化された深層学習関連ソフトウェアのコンテナレジストリ「NVIDIA GPU Cloud(NGC)」に対応したことを発表した。

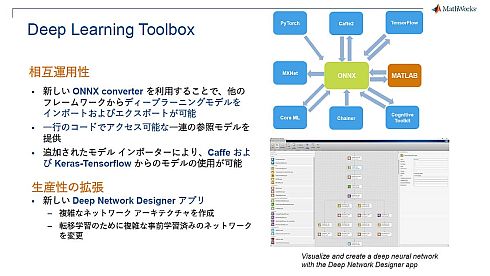

同年9月にリリースされたR2018bで追加された機能の中で大きなトピックとなったのが深層学習関連だ。これまでMATLABを用いた深層学習用のフレームワークとして提供してきた「Neural Network Toolbox」の機能を拡張するとともに、名称を「Deep Learning Toolbox」に変更した。

Deep Learning Toolboxにおける最も大きな拡張機能となるのが、ONNX(Open Neural Network Exchange)コンバーターを介した、さまざまなフレームワークで作成された深層学習モデルのインポートやエクスポートである。ONNXは、Facebookなどが中心になって発足した深層学習モデルの交換フォーマットを開発するコミュニティーであり、ONNXフォーマット自体は既にオープンになっている。そのONNXフォーマットを用いたONNXコンバーターにより、TensorFlowやCaffe2、CoreMLとMATLABの間で、深層学習モデルのインポートとエクスポートの両方が可能になる。また、PyTorchとChainerについてはインポートが、MXNetについてはエクスポートが可能になる。ONNXコンバーターの他にも、CaffeとKeras-TensorFlowで作成した深層学習モデルを直接インポートできるモデルインポーターも追加した。

この他、深層学習の生産性を拡張する機能として「Deep Network Designer」と呼ぶアプリケーションを用意した。深層学習モデルを可視化できるとともに、複雑なネットワークアーキテクチャで構成される深層学習モデルのネットワークレイヤーの差し替えを行える。また、深層学習モデルを評価する「Network Analyzer」という機能も利用できる。

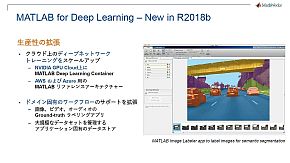

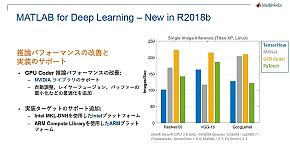

さらにR2018bでは、これまで自動運転技術開発用の「Automated Driving System Toolbox」でのみ提供していた、画像や映像、音声データへのラベル付けを自動化する機能(Ground-truthラベリングアプリ)を、より汎用的な「Computing Vison Toolbox」などで利用できるようにした。加えて、MATLABコードをNVIDIAのGPU向けプログラミング言語である「CUDA」のコードに自動変換するオプション「GPU Coder」の推論性能も向上した。GPU Coderの実装ターゲットとして、IntelやArmのプラットフォームもサポートに加えている。

MathWorks Japan インダストリーマーケティング部 部長の阿部悟氏は「オープンな開発環境を目指しているMATLAB/Simulinkにとって、ONNXコンバーターでさまざまな深層学習モデルとつながることは重要だ。そして、これらの開発した深層学習モデルを実装する上で、MATLABが最も効率の良い手段として選んでもらえるのではないか」と説明する。

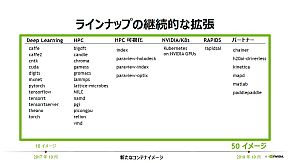

「NGC」が利用可能なコンテナイメージは50種類に

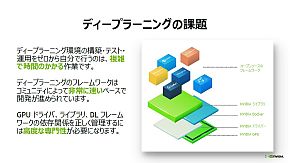

NGCは、深層学習を行う上で手間のかかる作業だったソフトウェア環境の構築を、より容易に短時間で行えるようにするため、コンテナ技術を用いて開発されたクラウドサービスだ。2017年10月の発表時点で利用できるコンテナイメージは10種類だったが、1年経過した2018年10月には50種類まで拡充している。その最新のラインアップがMATLABになる。

エヌビディア エンタープライズマーケティング本部 シニアマネージャの佐々木邦暢氏は「その名称からクラウドでしか利用できないように思われることも多いが、NVIDIAのGPUボードを搭載するサーバやワークステーションにもコンテナイメージを実装できる。さらに、NGCそのものの利用料は無料であり、コンテナイメージを実装した後はMathWorksユーザーの方であればアカウントを使ってアクセスするだけでOKだ」と述べている。

関連記事

AIと機械学習とディープラーニングは何が違うのか

AIと機械学習とディープラーニングは何が違うのか

技術開発の進展により加速度的に進化しているAI(人工知能)。このAIという言葉とともに語られているのが、機械学習やディープラーニングだ。AIと機械学習、そしてディープラーニングの違いとは何なのか。 世界を変えるAI技術「ディープラーニング」が製造業にもたらすインパクト

世界を変えるAI技術「ディープラーニング」が製造業にもたらすインパクト

人工知能やディープラーニングといった言葉が注目を集めていますが、それはITの世界だけにとどまるものではなく、製造業においても導入・検討されています。製造業にとって人工知能やディープラーニングがどのようなインパクトをもたらすか、解説します。 日本は既にディープラーニングで後進国となりつつある――東大松尾教授

日本は既にディープラーニングで後進国となりつつある――東大松尾教授

生産設備から社会インフラ、各種災害対策まで「メンテナンス」「レジリエンス」に関する最新の製品や技術、サービスを一堂に集めた展示会「メンテナンス・レジリエンスTOKYO2018」(2018年7月18〜20日、東京ビッグサイト)の特別講演に東京大学大学院 工学系研究科 特任准教授の松尾豊氏が登壇。「AIの発達によりわれわれの生活・産業がどのように変わるのか」をテーマにディープラーニング研究の重要性について紹介した。 ディープラーニングの事業活用を可能にする「ジェネラリスト」の重要性

ディープラーニングの事業活用を可能にする「ジェネラリスト」の重要性

AI技術として注目を集めるディープラーニング。ディープラーニングへの取り組みを進めていく上で必要とされる人材には「エンジニア」の他に「ジェネラリスト」も必要だ。本稿では、ディープラーニングの「ジェネラリスト」に何が求められるかについて解説する。 MATLAB/Simulinkが深層学習機能を強化、画像認識速度はTensorFlowの最大7倍に

MATLAB/Simulinkが深層学習機能を強化、画像認識速度はTensorFlowの最大7倍に

MathWorks Japanがモデルベース開発環境「MATLAB/Simulink」の最新バージョン「R2017b」で強化したディープラーニング(深層学習)関連の機能について説明。「MATLAB/Simulinkが得意としてきた制御系や信号処理系の技術にディープラーニングを組み合わせることでさまざまな価値が生まれる」(MathWorks フェローのジム・タン氏)という。 MATLABがIoTとITシステムの“共通言語”に、無償のオープンデータ基盤も用意

MATLABがIoTとITシステムの“共通言語”に、無償のオープンデータ基盤も用意

MathWorksは、モデルベース開発環境「MATLAB/Simulink」の最新バージョン「R2016b」などで強化したビッグデータ処理機能について説明。「MATLABという共通言語によって、IoTとなる組み込み機器と、バックエンドインフラのITシステムのワークフローを統合できる」(同社)という。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

- 1.5km離れた漁場をWi-Fi HaLowなどで可視化、海洋モニタリングの実証に成功

コーナーリンク

エヌビディアの佐々木邦暢氏(左)とMathWorks Japanの阿部悟氏(右)

エヌビディアの佐々木邦暢氏(左)とMathWorks Japanの阿部悟氏(右)