バイクに感情を持たせたら、高速走行中はランナーズハイだった?:自動運転技術(3/3 ページ)

音声感情認識は組み込み、感情生成は今のところクラウドで

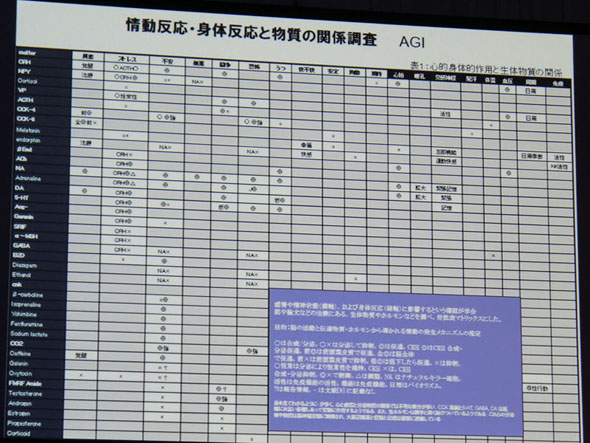

二輪などモノの神経伝達物質とひもづける入力は、車両情報に限らず、音声感情認識エンジンで検出したドライバーの感情や、ドライバーの脈拍、目的地までの道のりの長さなどさまざまな情報を想定している。また、別の実験では70個のセンサーと神経伝達物質の分泌を組み合わせた。このエンジンで生成できる感情は最大128種類に上る。

感情生成エンジンは、生成した感情の蓄積によって人の好き嫌いが生まれ、好きな人と嫌いな人で対応を分けたり、褒めるという外部からの入力に対し「もっと褒められたい」と学習を強化したりする。これにより、独自で固有の人格を持つAIに成長していくという。

音声感情認識エンジンは組み込みで機器に搭載できるが、大量のセンサー情報を必要とする感情生成エンジンは現状ではクラウド側での処理を必要とする。将来的には組み込みで感情を生成できるようにしていく。

ソフトバンクワールド2017の展示会場では、音声感情認識エンジンを組み込み機器に搭載する事例が示された。

ルネサス エレクトロニクスは2017年7月19日、車載情報機器向けのSoC(System on Chip)「R-Car」で音声感情認識エンジンや、検出した感情に対して応答するユーザーインタフェースを開発できるキットを2017年内にリリースすると発表。自動運転車で、ドライバーが不安を感じている時に自動運転への切り替えを提案したり、ドライバーの感情に合わせて車両の制御をコントロールしたりできるようにする。また、クラウドサービスの1つと位置付け、感情生成エンジンにも対応している。

ルネサスは、展示会場に設置したコックピットを使って、R-Car上で音声感情認識エンジンなどを動作させるデモンストレーションを披露した。

同社は、表情や視線といった画像認識で得られる情報や生体情報と同様に、感情もドライバーの状態を測る情報の1つと捉え、自動運転車の実現に向けてクルマとドライバーのインタフェースを向上していくとしている。

関連記事

ボッシュが開発に取り組む“説明可能なAI”

ボッシュが開発に取り組む“説明可能なAI”

Robert Bosch(ボッシュ)が2017年1月にAIセンター(BCAI:Bosch Center for Artificial Intelligence)の稼働を発表してから半年が過ぎた。年次会見にAIセンターのグローバル責任者であるクリストフ・パイロ氏が出席、AIセンターの目的や取り組みについて語った。 「ナイトライダー」目指し、ホンダとソフトバンクがAIの共同研究

「ナイトライダー」目指し、ホンダとソフトバンクがAIの共同研究

ホンダとソフトバンクが、人工知能分野での共同研究を開始する。ソフトバンク傘下のcocoroSBが開発したAI技術「感情エンジン」のモビリティ分野に向けた研究を行う。 カワサキがライダーと会話する二輪を開発、AIでアドバイスからセッティングまで

カワサキがライダーと会話する二輪を開発、AIでアドバイスからセッティングまで

川崎重工は、人工知能(AI)や情報通信技術を活用してライダーと意思疎通が可能な次世代の二輪を開発する。コミュニケーションを重ねることでライダーの個性を車両に反映させ、カワサキらしい運転の楽しさを進化させていく。 三菱自動車のAIアシスタント「リサ」、表情や声からドライバーを理解

三菱自動車のAIアシスタント「リサ」、表情や声からドライバーを理解

三菱自動車は「自動車技術展:人とくるまのテクノロジー展2017」において、AI(人工知能)パーソナルアシスタント「RISA」を紹介した。 トヨタがAIカーを開発、豊田社長の「クルマは“愛”がつく工業製品」を結実

トヨタがAIカーを開発、豊田社長の「クルマは“愛”がつく工業製品」を結実

トヨタ自動車は、民生機器テクノロジーの展示会「CES 2017」において、クルマが人のパートナーとなるコンセプトカー「TOYOTA Concept-愛i(コンセプト・アイ)」を出展する。 トヨタが人工知能ベンチャーに出資、「ぶつからない」ことを学ぶ技術を披露

トヨタが人工知能ベンチャーに出資、「ぶつからない」ことを学ぶ技術を披露

トヨタ自動車が人工知能技術ベンチャーのPreferred Networks(PFN)との提携を発表した。トヨタ自動車は「2016 International CES」で、PFNの技術を自動車に応用する可能性のコンセプトの1つとして、「ぶつからない」ことを学習する「分散機械学習のデモンストレーション」を披露する。

Copyright © ITmedia, Inc. All Rights Reserved.

モビリティの記事ランキング

- ローム買収を検討するデンソーは半導体メーカーになり切れるのか

- EV普及は“移動の不安解消”が鍵 ホンダは2030年に向けEV充電器を数千口へ拡大

- 旅客船の「レベル4相当」自律運航の実力は? 操船ブリッジかぶりつきレポート

- スズキがカナデビアの全固体電池「AS-LiB」事業を買収、宇宙機向けで実績

- 三菱マヒンドラ農機が会社清算へ、創業から112年の歴史に幕

- ホンダが米国生産車を日本に導入、2026年後半に「インテグラ」と「パスポート」

- ヤマハ発動機が原付二種に初のファッションモデル「Fazzio」投入、シェア拡大へ

- 2040年のxEV向け駆動用電池市場は2024年対比2.6倍に拡大

- 自動車産業の新たな競争構図は「フィジカルAIカー」対「エンボディドAIカー」へ

- ホンダが着脱式バッテリーを搭載した原付一種の電動二輪車を発売

コーナーリンク