SUBARUは次世代EyeSightで死亡事故ゼロ実現へ、ステレオカメラ×AIは相性抜群:安全システム(2/3 ページ)

SUBARU LabでAI技術を手の内化

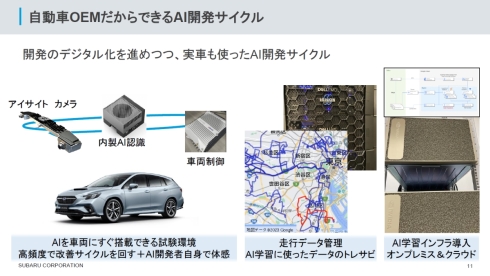

これまでのEyeSightは、ステレオカメラ映像を基に得た立体映像に対するパターンマッチングを高精度化する形で進化してきた。このEyeSightにAI技術を融合してさらなる進化を図るために開設されたのがSUBARU Labである。柴田氏は「AIエンジニアリング企業やAI人材との交流を図るとともに、AI技術を手の内化するため、エンジニアファーストな環境づくりを心掛けている。AIを車両に搭載してすぐに試せる試験環境があり、高頻度で改善サイクルを回して、AI開発者自身で体感できる。また、実走行で得たデータはSUBARU Lab内やクラウド上のAIインフラを使って即座に学習を行えるようになっている」と説明する。

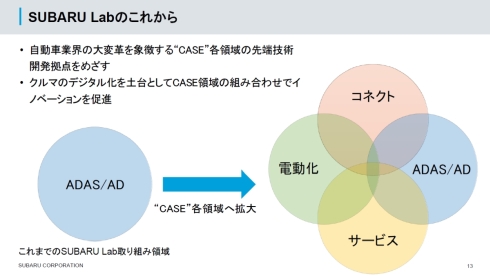

これまでは、EyeSightを中心としたADASやAD(自動運転技術)にフォーカスしていたSUBARU Labの活動だが、今後はCASE(コネクテッド、自動化、シェアリング、電動化)をカバーする各領域の先端技術開発拠点の役割も果たしていく考えだ。

画像認識AI「SUBARU ASURA Net」とステレオカメラを組み合わせ

会見では、SUBARU LabにおけるAI技術開発の現状についても紹介が行われた。

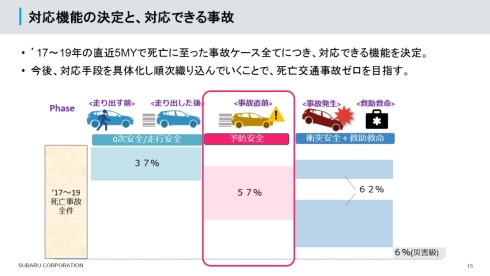

先述した「2030年までの死亡事故ゼロ」を達成するために、2017〜2019年の死亡事故全件を対象に5つの安全がどのような役割を果たせるかの分析を行っており、このうちEyeSightが大きな役割を担う予防安全は死亡事故全件のうち57%に貢献できると見ている。SUBARU LabにおけるAI技術開発の目標は、ステレオカメラ×AIによってこの57%の事故を未然に防ぐことに他ならない。

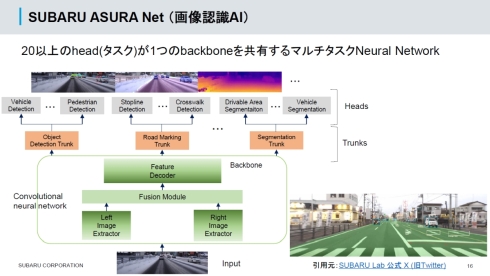

現在開発を進めている画像認識AI「SUBARU ASURA Net」は、20以上のタスク(Head)が1つのバックボーンを共有するマルチタスクのニューラルネットワークである。車両や歩行者、走行領域、路面標示、信号などを同時に認識することができる。

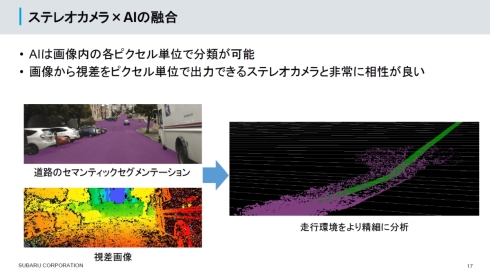

柴田氏によれば「ステレオカメラと画像認識AIは相性が良い」という。これは、ステレオカメラが画像から視差をピクセル単位で出力できる一方で、画像認識AIも画像内の各ピクセル単位で分類が可能であり、「ピクセル単位」という観点で技術に共通点があるためだ。ステレオカメラ×AIによって、それぞれを単独で用いるよりも高精細に走行環境を分析できるようになる。

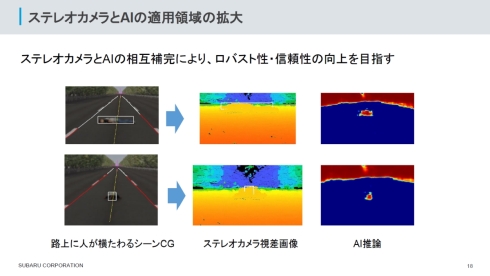

この他にも、ステレオカメラとAIの相互補完による効果も期待できる。一例として挙げたのが、路上に人が横たわっている状況の把握だ。ステレオカメラの視差画像では、路上に何かがあることを判別できないが、AI技術を使えば路上に障害物があることを把握できる。ステレオカメラとAIの相互補完により、これまでステレオカメラ単体では難しかった機能も可能になるというわけだ。

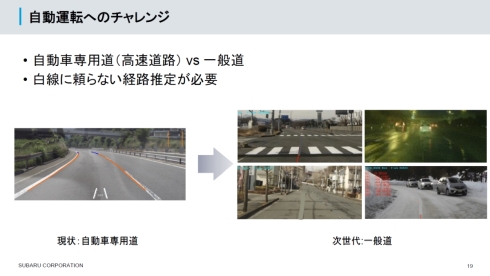

ステレオカメラ×AIによるADASとしてのEyeSightの進化以上に困難なのがADへの対応である。車線が見分けやすい自動車専用道路についてはADの実現の道筋は見えつつあるが、やはり“次世代”という観点で求められるのは一般道への適用になるだろう。

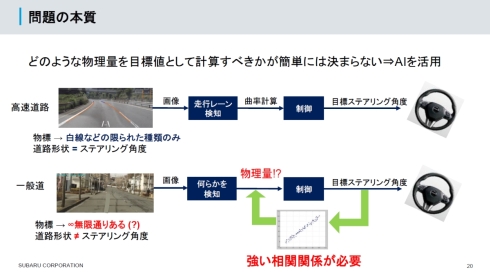

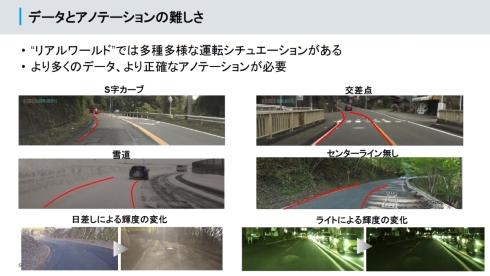

柴田氏は「白線などを基準にする自動車専用道路とは異なり、一般道ではどのような物理量を目標値として計算すべきかが簡単に決まらない。このような条件下ではAIが力を発揮する」と語る。ただし、一般道については無限通りともいえる組み合わせで多種多様な運転シチュエーションがあり得るため、AIの学習ではより多くのデータを取得してより正確なアノテーションを行わなければならないが、これまでもEyeSightの開発で積み重ねてきたリアルワールドへの対応の知見やノウハウを生かすことが可能だ。また、話題の生成AIの活用も調査段階ではあるが検討しているという。

記事冒頭に掲載した、白線や標識などを視認できない雪道を自動走行する映像は、SUBARU Labにおけるステレオカメラ×AIの開発成果の一端を示すものだ。

Copyright © ITmedia, Inc. All Rights Reserved.

モビリティの記事ランキング

- ローム買収を検討するデンソーは半導体メーカーになり切れるのか

- EV普及は“移動の不安解消”が鍵 ホンダは2030年に向けEV充電器を数千口へ拡大

- 旅客船の「レベル4相当」自律運航の実力は? 操船ブリッジかぶりつきレポート

- スズキがカナデビアの全固体電池「AS-LiB」事業を買収、宇宙機向けで実績

- 三菱マヒンドラ農機が会社清算へ、創業から112年の歴史に幕

- ホンダが米国生産車を日本に導入、2026年後半に「インテグラ」と「パスポート」

- ヤマハ発動機が原付二種に初のファッションモデル「Fazzio」投入、シェア拡大へ

- 2040年のxEV向け駆動用電池市場は2024年対比2.6倍に拡大

- 自動車産業の新たな競争構図は「フィジカルAIカー」対「エンボディドAIカー」へ

- ホンダが着脱式バッテリーを搭載した原付一種の電動二輪車を発売

コーナーリンク