AIは万能ではない――インシリコ創薬が目指す未来:人工知能ニュース(3/3 ページ)

化合物をコンピュータにデザインさせる

ただし、こういった取り組みは新しいものではない。この例では、あらかじめ用意されたタンパク質と化合物の中から、目的の組み合わせを見つける。「これではあまり面白くない。よりAIらしい進め方として、標的のタンパク質の情報だけを入力し、それに対する化合物はコンピュータにデザインさせたい」(奥野氏)。

例えばCDK2というタンパク質に結合する化合物を探索する場合、基本となる化合物に結合可能な3つの官能基(腕)があり、市販されている試薬をこの腕に付けると考えると、候補のバリエーションは理論上10の15乗になる。

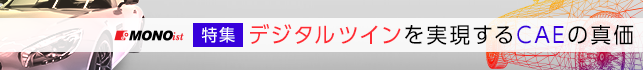

そこで奥野氏が示したコンピュータ上の化合物設計では、はじめに構造生成プログラムにより32の化合物を発生させる。AIによりそれらの活性度のスコアを算出し、その時点で最も高い構造を保持しながら他の構造を変化させていき、最も高いスコアとなる構造を探す(図5)。

「このようなパラメータを最適化していくアルゴリズムはモノづくりの世界でも使われていると思う。化学構造をコンピュータ上で発生させて、AIによりタンパク質との活性を予測する手法と組み合わせることで、新しい化合物をデザインできるようになっている」(奥野氏)。

診断材料のマイニングにAIを使う

コンソーシアムでは、がんゲノム医療(個人のゲノム情報に応じた治療を行うアプローチ)にも取り組んでいる。このがんゲノム医療には米国政府も「精密医療」という名称で取り組むことを表明している。「このような取り組みの背景には、『実は薬は思ったほど効いていない』という現実がある」(奥野氏)。

実際にある統計では、抗がん剤を使用した患者のうち75%に効果が認められていない。またアルツハイマーの場合も、標準治療を受けた患者のうち、70%に薬効が認められていないという。抗がん剤は高価な上に副作用も強い。そのため、あらかじめ効くかどうかを調べた上で投与しようという考えが広がっているのだ。

個人のゲノム情報を調べて体質や薬の反応性を判断する際は、まずゲノム配列をシーケンサーで読み取り変異を特定する。ここまでのプロセスは情報学的に確立されている。

だが、見つかった変異が本当に薬に関係するかどうかを判断するためには高い専門性が必要になる。そこで臨床医や情報学、遺伝カウンセラーなど、さまざまな専門家が集まって文献やデータベースを調べ、適切な治療法を議論することになる。

ここで問題になるのが、治療においてはスピードが何よりも重要になるということだ。「がんは進行が速く、患者は待ってくれない。また将来ゲノム解析のコストが下がり、蓄積されるデータ量も爆発的に増えると考えられる。マニュアル作業で文献を読み解く方法ではいずれ追い付かなくなるのは確実」(奥野氏)。

そこでコンソーシアムでは、AIを活用して文献やデータベースのマイニングを行い、情報をある程度選別した上で人が見ていくというプロセスの開発を進めている。IBMのAI「Watson」が活用されているが、Watsonは基本的に欧米の人のデータベースを使用しているので、コンソーシアムでは日本人のゲノムを用いた日本版AIの開発を進めているという。

とはいえ、これだけで現場の作業がスムーズに進むわけではないという。得られた遺伝子の変異のデータは、臨床上は意味の分からないものの方が多いからだ。論文やニュースとして表に出てきているものは、一部の解釈に成功した分かりやすいものにすぎない。情報のない中AIだけで解決することは不可能だ。

そこで、分子シミュレーションによってゲノム上の変異をタンパク質上に再現し、タンパク質と薬剤の反応性を確認することにも取り組んでいる(図6)。

例えば肺がんにおいて、抗がん剤を投与するうちに遺伝子のタンパク質配列が変化する例がある。こうなると薬が効かなくなってしまう。AIだけでは限界があるため、シミュレーション実験によってデータのない領域を推論していくことが重要になってくるという。

AIは万能ではない

AIを活用していく上で注意すべき点として、奥野氏は2点を示した。「創薬やモノづくりを含めて、自然科学の分野では新規の事象や物質の発見が最も重要になる。だがAIは過去の経験を使って推論していく。そのため実は新規性とは背反している。また、AIは問い合わせが来れば結果を与えるという推論のモデルは作ってくれるが、その間のメカニズムはブラックボックスになる」(奥野氏)。

AIの予測範囲や精度は、既存の学習データの質や量に大きく依存する。「AIによるデータ解析を行う上でよく問題になるのが、実験データが足りないということ」(奥野氏)だという。これはレンブラントの絵が十分になければレンブラント風の絵を描けないのと同じだ。「実験側から『こういったことを予測したい』といわれていざ検討してみると、対象データがほとんどない。そこで『実験をしてほしい』と伝えると『実験したくないから計算してほしい』となる。現実ではこの点がなかなかかみ合わない」(奥野氏)。

そこで、タンパク質の分子シミュレーションの例のように「計算できるところまではコンピュータで計算する、実験データがないところはシミュレーション実験を行い、その結果をAIに学習させる」(奥野氏)というアプローチを取る。AIとシミュレーションを回すことによって、できる限りコンピュータでモデルを作る。ただそれだけでは誤差が膨れ上がるため、必要最低限の実験も行う。

「AIという言葉が独り歩きしているが、実験とAIとバーチャル実験を適切に組み合わせれば、コストのかかる実験を減らしながらプロセスを加速することができる。これを目指さなければ、日本ははるかに財力のある海外と対等に戦っていくことはできないだろう。AIに興味のある方は、AIだけでなくシミュレーションや実験ももっと大事にしてほしい」(奥野氏)。

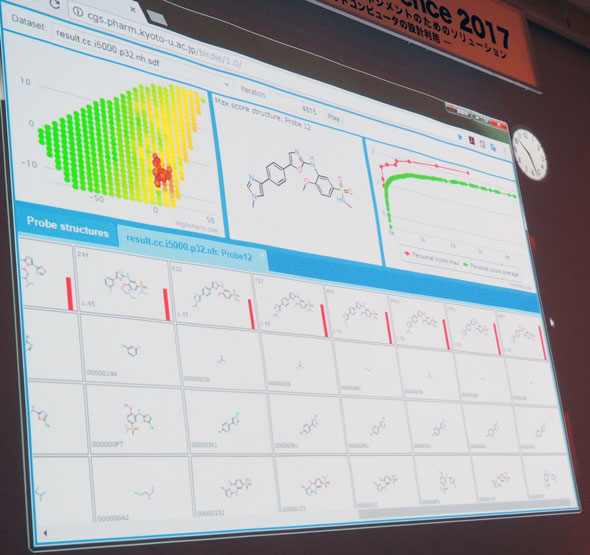

コンソーシアムでは図7のように創薬に関するさまざまなAIを開発しているが、奥野氏はさらにその先を目指したいという。

それは30本のAIが開発できたら、それらのインプットとアウトプットをつなげるということだ。つまり「どんな疾患の薬を開発すればよいかと問えば、薬や治験の方法まで全ての回答が返ってくる」ということを意味する。

奥野氏は最後に1900年と1913年のニューヨークの大通りの写真を示した。「産業革命では自動車が13年で大通りを走る馬車を全て置き換えた。2030年にはこのようなAIもできているのではないかと思う。私たちはそれを日本発として作っていきたいと考えている」(奥野氏)。

関連記事

NECがAIで創薬事業に参入できた理由は「20年以上の積み重ね」

NECがAIで創薬事業に参入できた理由は「20年以上の積み重ね」

NECは、独自の先進AI(人工知能)技術の成果を基に創薬事業に参入する。新会社「サイトリミック株式会社」を設立し、がん治療用ペプチドワクチンの開発と実用化を推進していく。今回の創薬事業への参入は、NECが20年以上積み重ねてきたAI技術やバイオIT事業の結晶ともいえるものだ。 がんプレシジョン医療にAIを活用、治療率が6倍に

がんプレシジョン医療にAIを活用、治療率が6倍に

がん研究会、がん研究所、FRONTEOヘルスケアは、最先端のゲノム解析技術とAI(人工知能)を用いて「がんプレシジョン医療」を実現するシステムの開発に向けた共同研究を開始する。現在、一般的で明確ながん治療法が当てはまらないがん患者の治療率は5%程度だが、共同研究により治療率を6倍の30%まで高められる可能性がある。 心疾患患者の再入院リスクをAIで高精度に予測、医療費削減に

心疾患患者の再入院リスクをAIで高精度に予測、医療費削減に

日立製作所は、AI(人工知能)技術を用いて、心疾患の入院患者が退院後30日以内に再入院するリスクを高精度に予測することに成功した。AIが再入院リスクの根拠を提示するとともに、患者の再入院リスクを高精度に予測できることを確認した。 大腸がんなどの病変をAIで98%検知するリアルタイム内視鏡診断サポートシステム

大腸がんなどの病変をAIで98%検知するリアルタイム内視鏡診断サポートシステム

国立がん研究センターとNECは、AIを用いて大腸がんや前がん病変を内視鏡検査時にリアルタイムに発見するシステムを開発した。大腸がんなどの病変を98%の発見率で自動検知し、病変見逃しの改善が期待される。 画像評価を用いたiPS細胞のリアルタイム品質管理技術を開発

画像評価を用いたiPS細胞のリアルタイム品質管理技術を開発

名古屋大学は、iPS細胞などのヒト多能性幹細胞の培養工程で、画像情報を用いて細胞の品質を管理・評価する技術を開発した。培養中の細胞を破壊せず、リアルタイムに品質評価ができる。

Copyright © ITmedia, Inc. All Rights Reserved.

医療機器の記事ランキング

- おむつかぶれや尿路感染を防ぐ、体外式カテーテルに新製品

- 3DとAIで数十万の細胞を解析する「自律型デジタル細胞診」システムを開発

- 既存薬が効きにくいがんにも光、BNCT用ホウ素薬剤を開発

- 減らすだけでは効果なし、完全禁酒/禁煙で食道がん治療後の発生リスクが5分の1に

- 「入れ歯」専用の次世代3Dプリンタ、2027年市場投入へ

- 不公平な提案を受諾する際の脳内抑制メカニズムを解明

- 対象所見を10種類に拡充した胸部単純X線画像病変検出ソフトの提供を開始

- 体温の日内制御、恒温動物と変温動物で共通の仕組みを発見

- 新型コロナ向け「ワクチン接種パッチ」の実用化へ前進、自己接種も可能に

- なぜPM2.5で花粉症がひどくなる? スズと粘液の反応によるメカニズムを発見

コーナーリンク