10万原子のシミュレーションを1週間で、富士通MI技術の「異次元の高速化」:マテリアルズインフォマティクス最前線(7)(2/3 ページ)

高精度、高速、高い安定性のMDシミュレーションを実現

GeNNIP4MDは、事前学習済みモデルを活用する「知識蒸留」などの独自の訓練技術で、ユーザーのターゲット材料に特化した高精度、高速、高い安定性のMDシミュレーションを実現するNNPを生成できる。

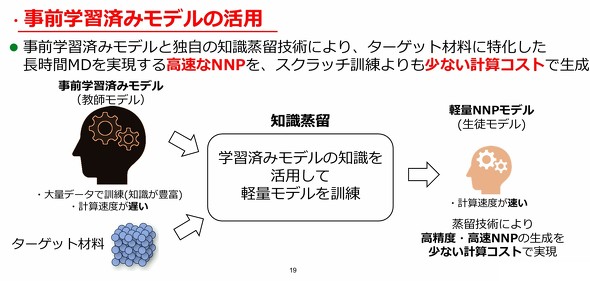

事前学習済みモデルは、材料に関する大量のデータで訓練されたモデルであり、多様な材料の知識を有しているが、一方で計算速度が遅いという課題がある。

知識蒸留は、「モデルの表現力は高いが計算に時間がかかる巨大なAIモデル(教師モデル)」が備えている「高精度なシミュレーションを実現する知見」を、「計算速度は速いがモデルの表現力が低い小さなAIモデル(生徒モデル)」に効率よく引き継がせる手法だ。これにより、計算時間を抑えつつ、第一原理計算に匹敵する高精度のシミュレーションを、軽量なAIモデルで実現できる。

吉本氏は「一般的にAIモデルは学習データ外の情報に関して予測が苦手だ。そのため、GeNNIP4MDの開発では、さまざまな領域に対応するロバスト(堅牢)なAIモデルの作成が求められた。この問題を解決する目的で、試行錯誤を重ね『事前学習済みモデル』や『知識蒸留』の活用に至った。これにより、必要十分な訓練データで高精度なAIモデルを効果的に作れる」と紹介した。

事前学習済みモデルとターゲット材料のデータを合わせて、知識蒸留することで、事前学習済みモデルの知識を活用して、軽量で計算速度が速いNNPモデルを訓練する。これにより、ターゲット材料に特化し、長時間のMDシミュレーションに対応する高速なNNPを少ない計算コストで生成できる。

松村氏は「通常の『教師あり学習』が、与えられた教材を全て解く『受け身の学習』だとすれば、事前学習済みモデルの活用は『分からない問題だけをピックアップして先生に聞く、効率的な自習』に近いイメージだ。必要最小限のデータで効率的に賢いAIモデルを作れるため、開発コストが大幅に下がる」と強調した。

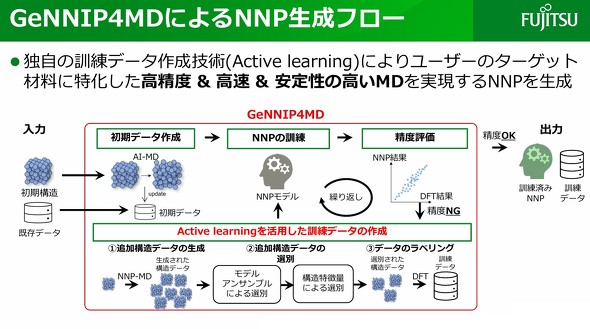

GeNNIP4MDの手順は以下の通りだ。まず、ターゲット材料の初期構造を基に作成した量子化学計算モデルや既存データなどの「初期データ」を作成する。

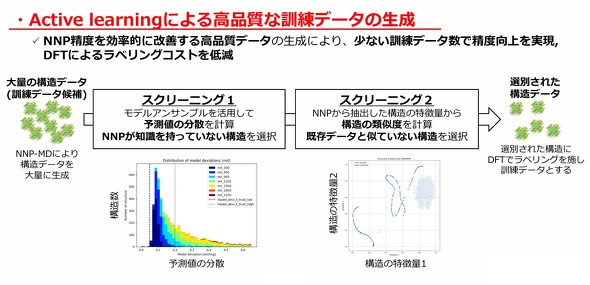

併せて、ターゲット材料の初期構造をベースに、NNPを用いたMDシミュレーションにより、訓練データ候補となるさまざまなパターンの構造データを生成。複数の学習モデルを組み合わせて、より精度の高いモデルを構築する手法「モデルアンサンブル」を活用して、これらの構造データにおける予測値の分散を計算し、NNPが知識を持っていない構造を選択する。

次に、NNPから抽出した構造の特徴量から構造の類似度を計算し、既存データと似ていない構造を選別。選別された構造データに対して、密度汎関数理論(DFT)でラベリングを行うことで、訓練データを作成する。同社では訓練データ作成のプロセスを「アクティブラーニングを活用した訓練データの作成」としている。

この訓練データと初期データを用いてNNPを訓練する。続いて、このNNPに対して精度評価を行い、精度が目標に達していれば訓練済みNNPとして出力し、未達であれば再度、「アクティブラーニングを活用した訓練データの作成」と「NNPの訓練」を行う。この訓練済みNNPを活用することで、10万原子以上のMDシミュレーションが可能だ。

Copyright © ITmedia, Inc. All Rights Reserved.

素材/化学の記事ランキング

- トヨタのEVに載る全固体電池向け固体電解質の大型製造装置を建設

- レアメタルを使わないシリコーン硬化用の鉄触媒を開発

- 富士フイルムが営業利益で過去最高、「半導体材料」と「チェキ」好調

- エンプラが半導体製造装置用途で堅調も三菱ケミカルGは減収減益、要因とは

- 厚さ200μmで柔らかくのりのはみ出しが少ないバックグラインドシート

- ペロブスカイト太陽電池の高効率化と高耐久化を実現する添加剤を発売

- 車載向け全固体電池に絶妙な圧力で、固体電解質と電極をつなぐ緩衝材

- 10万原子のシミュレーションを1週間で、富士通MI技術の「異次元の高速化」

- エネルギー消費量を最大75%削減する平膜型排水処理技術の確立にめど

- 帝人が事業ポートフォリオを変革、顧客近接型ビジネスモデルを強化

コーナーリンク

富士通 富士通研究所 コンピューティング研究所 マテリアルズインフォマティクスPJ 開発担当の吉本勇太氏

富士通 富士通研究所 コンピューティング研究所 マテリアルズインフォマティクスPJ 開発担当の吉本勇太氏

富士通 富士通研究所 コンピューティング研究所 マテリアルズインフォマティクスPJ 開発担当の松村直樹氏

富士通 富士通研究所 コンピューティング研究所 マテリアルズインフォマティクスPJ 開発担当の松村直樹氏