パナソニックHDが画像生成AIの効率を5倍に、一人称視点映像からの未来予測も:人工知能ニュース(2/2 ページ)

一人称視点映像と頭部軌道の情報だけで動作を再構成/予測/生成

ウェアラブルカメラやスマートグラスなどの一人称視点で映像を記録できるウェアラブルデバイスの登場により、装着者自身の視点からその動作をAIで理解/予測する技術への期待が高まっている。例えば、工場の現場などで熟練者の作業内容を映像で撮影しAIで解析することで技術承継などに活用するなどの取り組みがある。ただし多くの場合、映像の撮影は固定カメラで行っているが、設備やコスト制約で最適な位置にカメラを設置できないことが多いのが実情だ。ウェアラブルデバイスを用いた映像の撮影であればそういった制約に縛られない。

ただし、一人称視点映像や頭部軌道からの動作推定は技術的に非常に困難とされている。装着者の身体が映像内に映らないため、固定カメラを用いた三人称視点の画像情報や周辺のシーン情報が追加で必要な場合が多く実用化には課題があった。

今回、パナソニックHDとパナソニックR&Dカンパニー オブ アメリカ(PRDCA)、スタンフォード大学の研究者らが共同開発したUniEgoMotionは、ウェアラブルデバイスから得られる一人称視点映像と頭部軌道の情報だけで動作を再構成/予測/生成できる統合型モーション拡散モデルとなっている。

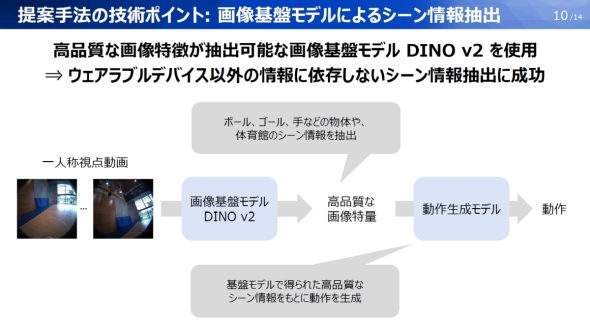

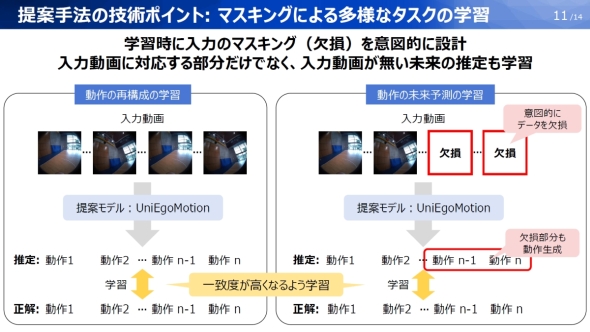

UniEgoMotionの技術のポイントとなるのが「画像基盤モデルによるシーン情報抽出」と「マスキングによる多様なタスクの学習」の2つである。「画像基盤モデルによるシーン情報抽出」では、一人称視点映像から周辺状況の高精度な画像特徴を抽出できる「DINO v2」を活用することでウェアラブルデバイス以外の情報に依存しないシーン情報抽出に成功した。「マスキングによる多様なタスクの学習」では、学習時に入力のマスキング(欠損)を意図的に設計し、入力映像に対応する部分だけでなく、入力映像がない未来の推定も学習できるようにした。

UniEgoMotionと他の手法について、一人称視点の映像や頭部軌道から現在の動作を推定する「動作の再構成」のタスクの精度を評価したところ、ポーズの再現精度や動作の自然さを示す指標で従来手法を上回る精度を達成した。

なお、パナソニックグループが手掛ける事業へのUniEgoMotionの適用例としては、パナソニック コネクトが展開するサプライチェーンマネジメント事業における現場作業可視化の範囲の拡大などを想定。この他にも、リハビリ/ヘルスケア分野での動作モニタリングなど幅広い事業領域での活用が期待できるとしている。

関連記事

AIとセンサーで古米が絶品ご飯に パナソニックの新型炊飯器が見せた技術力

AIとセンサーで古米が絶品ご飯に パナソニックの新型炊飯器が見せた技術力

パナソニックは可変式IHジャー炊飯器「ビストロ X9Dシリーズ」を2025年9月上旬に発売する。本稿では、そのAIとセンサー技術を中心に紹介する。【訂正あり】 パナソニック コネクトに浸透する生成AI活用 前年比2.4倍の業務時間削減を達成

パナソニック コネクトに浸透する生成AI活用 前年比2.4倍の業務時間削減を達成

パナソニック コネクトが社内向け生成AI活用イベントを開催。2023年2月から始まった同社内における生成AIの業務利用だが、その活用法はAIに「聞く」から「頼む」に変わりつつあるという。 パナソニックの「設計AI」が“勘と経験”を超える設計の自動化を実現

パナソニックの「設計AI」が“勘と経験”を超える設計の自動化を実現

パナソニック ホールディングスは、高速化に強みを持つ自社のシミュレーション技術とAIを掛け合わせ、自動で素早くデバイスを設計する独自の「設計AI」の開発に取り組んでいる。その特長や成果について担当者に聞いた。 パナソニックHDがマルチモーダル生成AIで新たな成果、学習データ量を60分の1に

パナソニックHDがマルチモーダル生成AIで新たな成果、学習データ量を60分の1に

パナソニック ホールディングスとパナソニックR&Dカンパニーオブアメリカは、カリフォルニア大学ロサンゼルス校の研究者と共同で、テキストや画像、音などの異なるデータ形式を自由に相互変換できる“Any-to-Any手法”のマルチモーダル生成AI「OmniFlow」を開発した。 パナソニックHDはなぜ「人の理解」に関する技術開発に力を入れるのか、その勝算

パナソニックHDはなぜ「人の理解」に関する技術開発に力を入れるのか、その勝算

パナソニック ホールディングスは、技術部門における3つの事業本部での取り組み内容を紹介するとともに、現在開発中の技術の一部を公開した。後編では、パナソニックHDが力を入れる「人の理解」技術への取り組みについて紹介する。 パナソニックが画像認識マルチモーダル基盤を刷新、HIPIEからSegLLMへ

パナソニックが画像認識マルチモーダル基盤を刷新、HIPIEからSegLLMへ

パナソニック ホールディングスはテキストと参照画像を用いて未学習の物体も指示できる対話型セグメンテーション技術を開発した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- 月面を照らす「光の物差し」 JAXAとカシオが可視光測位技術を実証

- 生成AI実行時の消費電力が10W以下に SiMa.aiのSoC「Modalix」の実証結果を公開

- いまさら聞けないエッジAIとクラウドAIの違い “現場処理回帰”の必然性とは

- フォックスコンがフィジカルAIで実現する「AX」とは、NVIDIAと川崎重工も講演

- 1μF以下の極小コンデンサーでも安定動作する500mA対応LDOレギュレーター

- 衛星通信向け量子鍵配送送受信システムの小型化と高速化に成功

- 時代はDXからAIが当たり前に浸透する「IX」に突入へ CES 2026の内容をひもとく

- 高速起動とREST APIで高性能なデータ取得を自動化する測定コア

- 愛猫の不調を見逃さない、LIXILが非接触呼吸計測デバイスを開発

- 現場や事務用途で快適に使える防塵防水対応の10.1型タブレットPCを発売

コーナーリンク