パナソニックが画像認識マルチモーダル基盤を刷新、HIPIEからSegLLMへ:人工知能ニュース(1/2 ページ)

パナソニック ホールディングスはテキストと参照画像を用いて未学習の物体も指示できる対話型セグメンテーション技術を開発した。

パナソニック ホールディングスは2025年4月17日、テキストと参照画像を用いて未学習の物体も指示できる対話型セグメンテーション技術「SegLLM」を開発したと発表した。

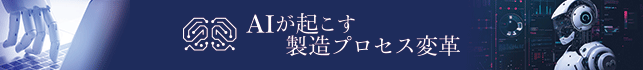

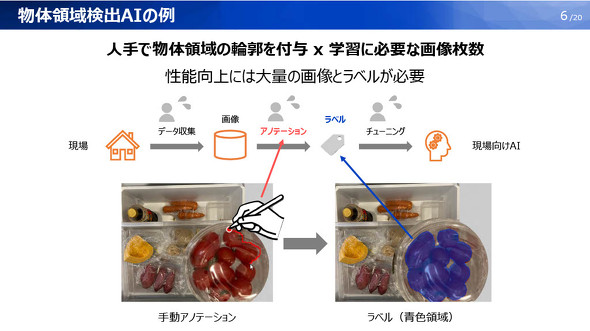

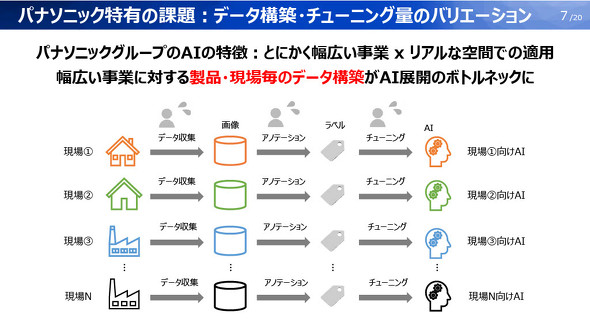

パナソニックグループはさまざまな事業を手掛けており、それぞれがAI(人工知能)の活用に取り組んでいる。物体検出や領域認識などのAIを適用するには、教師データの構築やアノテーションに時間やコストがかかる。特に時間がかかるのがアノテーションだといわれる。AIの差別化のポイントでもあるが、負担が大きい。現場ごとにデータ収集やアノテーション、チューニングに取り組むので、AI活用のプロジェクトを拡大しにくいという課題も抱えている。

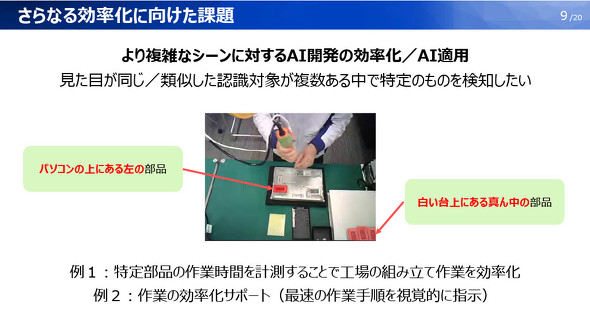

こうした状況を受けて、アノテーションの自動化や、チューニングも含めた効率化などに取り組んできたが、似たような外観を持つ認識対象の中から特定の物体を選び出して認識する必要があるなど、より複雑な課題も発生している。これに対応するため開発したのが、今回発表した対話型セグメンテーション技術のSegLLMだ。

直前の対話結果を踏まえる

SegLLMは、2023年11月に発表した独自開発のマルチモーダル基盤「HIPIE」の後継モデルとなる。

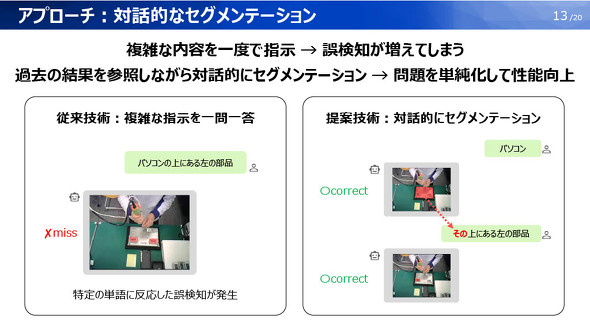

HIPIEはLLM(大規模言語モデル)の事前知識を活用して、任意のテキスト入力に応じてセグメンテーションを行うが、一問一答形式でプロンプトを入力するため、複雑な指示になると誤検知が発生し、指示をやり直さなければならないのが課題だった。

これに対し、SegLLMは対話形式で直前の指示で検出した領域を引用することができる。テキストだけでなく画像を用いた指示が可能になり、複雑な場面でもセグメンテーションしやすくなる。HIPIEでは「PCの上にある左の部品」のように修飾語が長くなると誤検知が増えてしまうが、SegLLMは「PC」をまず指示し、その後で「その(=直前に指示した「PC」)上にある左の部品」と指示することで従来よりも複雑な場面にも対応できる。

Copyright © ITmedia, Inc. All Rights Reserved.

製造マネジメントの記事ランキング

- 生産性100倍に、富士通がソフトウェア開発をAIエージェントで自動化する開発基盤

- 従業員のスキルに応じた「ランク認定制度」も 三菱電機が推進するDX人材育成施策

- 日本は本当に遅れているのか? AI×現場力で始まる日本型モノづくりの逆襲

- 「好きなことは楽しめる間にとことん楽しむ」という考え方の重要性について

- アイリスオーヤマなど、無線制御技術を軸に建設業界の課題解決に向けた協業開始

- IOWN APNと画像認識AIにより、約300km離れた工場での外観検査に成功

- AIエージェントが代わりに働くようになったら人は何をするの?

- 永守氏がニデック完全退任、「経営者としての私の物語にピリオド」

- パナソニックは新技術拠点「Technology CUBE」で“実装力のあるR&D”を強化

- 富士フイルムBIがトルコ企業を買収、基幹システム導入の海外展開加速

コーナーリンク