画像認識AIの現場実装作業が10分の1に、パナソニックHDが汎用基盤モデルを開発:人工知能ニュース(1/2 ページ)

パナソニックHDは、画像認識AIを現場実装する際に必要なアノテーションなどの作業負荷を大幅に削減可能な画像認識向けマルチモーダル基盤モデル「HIPIE」を開発した。

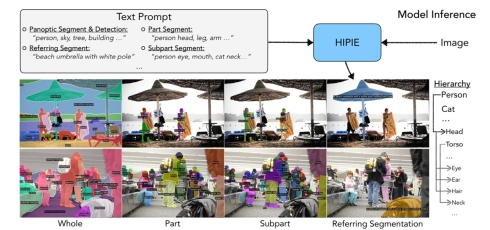

パナソニック ホールディングス(パナソニックHD)は2023年11月21日、オンラインで会見を開き、画像認識AI(人工知能)を現場実装する際に必要なアノテーションなどの作業負荷を大幅に削減可能な画像認識向けマルチモーダル基盤モデル「HIPIE(Hierarchical Open-vocabulary Universal Image Segmentation、ヒピエ)」を開発したと発表した。LLM(大規模言語モデル)の活用によりテキストプロンプトを追加するだけで新たな対象を認識可能になるとともに、物体検出やセグメンテーションといったさまざまな認識タスクを高い精度で行えるという。2024年度内にもパナソニックグループ内で実証実験を通した実用化の取り組みを始めたい考えだ。

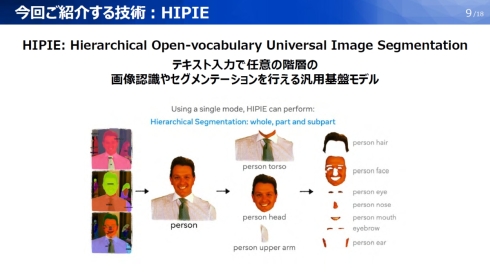

HIPIEは、テキスト入力で任意の階層の画像認識やセグメンテーションを行える画像認識AIの汎用基盤モデルである。ここで言う任意の階層とは、人を画像認識の対象とした場合に、人物⇒体/頭/腕⇒髪/顔/目/鼻/口/眉毛/耳といった「階層的な関係性」における各階層のことを指す。

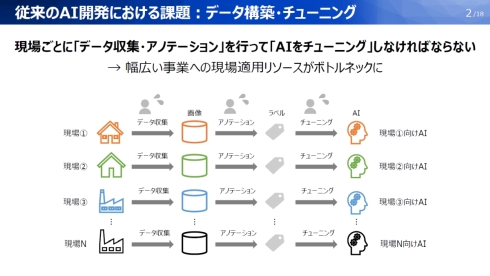

これまで画像認識AIモデルを構築する際には、現場で画像データを収集してからアノテーションを行い、それぞれの現場で最適に利用できるようなチューニングを施すのが一般的だった。この場合、現場ごとに異なる画像認識AIモデルを構築することになるため、デジタル技術導入のメリットであるスケールメリットが得られない。

この課題を解決するために、LLMの事前知識を活用して基盤となる画像認識AIモデルに少量のデータを追加することでアノテーションやチューニングの手間を削減する取り組みが進んでいる。ただし、大規模言語モデルの事前知識を画像に取り込む場合、先述した「階層的な関係性」を無視して認識対象と言語が1対1で対応する形で扱うため、画像認識AIモデルにない未知の言語で学習を行おうとするとうまく扱えなくなるという課題があった。

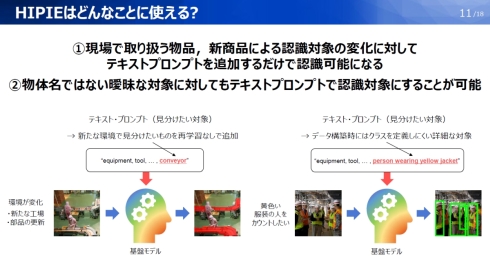

HIPIEは、LLMに基づく言語AIと画像認識AIを組み合わせるとともに、これまで無視されてきた「階層的な関係性」を取り入れて異なる粒度の階層的な表現を学習する技術によって開発した画像認識AIの汎用基盤モデルである。これによって、テキストプロンプトを追加するだけで、画像認識AIモデルを再学習することなく新しい認識対象を追加できるようになった。また、階層に応じて複数のモデルを用意する必要があったセグメンテーションや画像認識を1つのモデルで実現できている。

「正確に計測したわけではないが、従来型の画像認識AIモデルで新しい現場環境に対応するために行うアノテーションやチューニングの作業量を、HIPIEを用いることでば約10分の1で済ませられるだろう」(パナソニックHD テクノロジー本部 デジタル・AI技術センター AIソリューション部 1課 主任技師の加藤祐介氏)

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- 急成長中の中国ヒューマノイド大手AgiBotの技術戦略

- 光通信入門事始め――古代の人々ののろしと同じように光で信号を送ってみよう

- 宇宙用途向け耐放射線FPGAが欧州の宇宙用部品規格の認定を取得

- AIスパコンやロボット活用で「稼げる農業」へ、農研機構と東京工科大が連携協定

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【前編】

- OKIエンジが北関東校正センターを設立「計測器校正は第三者校正が主流に」

- イチから全部作ってみよう(29)3つのノート整理法からたどるRDBMSの基礎知識

- IIJの法人モバイル契約数が350万回線に、マルチプロファイルSIM2.0の特許も取得

- IoTゲートウェイの課題はデータの欠損と変換、IIJ子会社が新コンセプトで解決へ

- デジタルツイン向けマルチLiDAR異常検知技術を開発

コーナーリンク