東工大「TSUBAME 4.0」は“みんなのスパコン”としてどのような進化を遂げたのか:AIとの融合で進化するスパコンの現在地(1)(2/3 ページ)

並列コンピューティングの研究を礎に生まれたTSUBAME

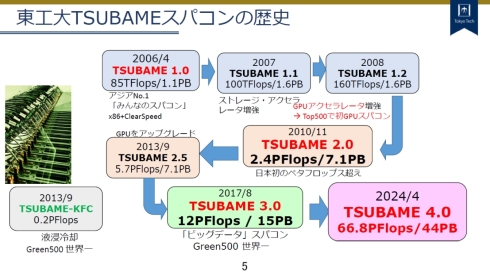

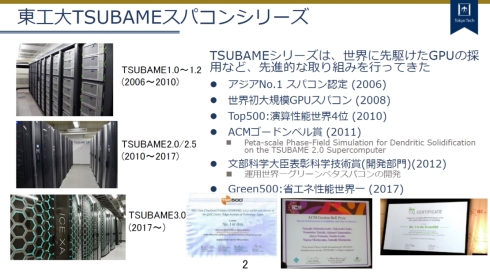

ここでTSUBAMEの歴史を簡単に振り返ってみたい(図7、8)。

図8 歴代のTSUBAMEシリーズの外観と成果 出所:東工大 学術国際情報センター「TSUBAME: Supercomputers for Everybody's AI/Machine Learning」

図8 歴代のTSUBAMEシリーズの外観と成果 出所:東工大 学術国際情報センター「TSUBAME: Supercomputers for Everybody's AI/Machine Learning」TSUBAME 1.0

初代の「TSUBAME 1.0」は2006年4月に稼働した。開発を指揮したのは長年にわたって並列コンピューティングの研究に携わってきた東工大 学術国際情報センター 教授の松岡聡氏(当時)※1)である。“みんなのスパコン”のキャッチフレーズの下、誰もが使える高性能な計算基盤として構築された。構築費用は22億円と発表されている。

システムは計1万480コアのAMD Opteronプロセッサで構成され、スパコンのベンチマークランキングであるTOP500において、2006年6月に世界7位、国内1位のランキングを獲得した。アクセラレータとしては旧ClearSpeed TechnologyのSIMDプロセッサCSX600が一部ノードに搭載され、その後全ノードに拡張された(TSUBAME 1.1)。

※1)松岡氏は、現在は主に理化学研究所計算科学研究センターのセンター長として「富岳」の総責任者を務めている。

TSUBAME 1.2

NVIDIA Tesla T10 GPUを4個搭載した筐体であるNVIDIA Tesla S1070を170台、計680GPUを増設したシステムである。GPU搭載スパコンとしてTOP500に掲載された世界初のシステムであり、これ以降、NVIDIA GPUが重要な役割を担うようになる。

TSUBAME 2.0

日本初のペタフロップススパコンとして開発され、倍精度計算性能は2.4PFlops、ストレージ容量は7.1PBであった。構築費用は32億円である。スパコンの実システムとその活用における最高栄誉である「ACM Gordon Bell」賞を受賞した研究も輩出している。

計算ノードは2816個のインテルXeonプロセッサーX5670(Westmere-EP)と4224個のNVIDIA Tesla M2050 GPU(Fermiコア)で構成された。ノード間インターコネクトには40GbpsのQDR InfiniBandが用いられた。

運用面においては、Linux用のプログラムだけではなくMicrosoft Windows HPC Server 2008用のプログラムが使えるようにVM(仮想マシン)が導入された。バッチスケジューラが新たに開発され、リソースの配分や定額制と従量制の両立など、ユーザーにとって使いやすい環境が提供された。

TSUBAME 2.5

利用の拡大に伴ってTSUBAME 2.0の計算能力が不足してきたため、全ての計算ノードのGPUを、その当時の最新世代となるNVIDIA Tesla K20X(Keplerコア)に入れ替えたシステムである。

TSUBAME-KFC

液浸型冷却技術の実証用として開発された小型スパコンであり、屋外のコンテナ内に設置された。エネルギー効率を測るベンチマークのGreen 500とGreen Graph 500においてともに世界1位を獲得した。1.0が理論上の最高値となるPUE(電力使用効率)は、わずか1.09であった。

TSUBAME 3.0

「省エネ型のビッグデータスパコン」との位置付けの下、TSUBAME 2.5を大幅に上回る演算性能12PFlops、ストレージ容量15PBのシステムとして、2017年8月に稼働した。計算ノードは、1080個のインテルXeonプロセッサーE5-2680 v4と2160個のNVIDIA Tesla P100(Pascalコア)で構成された。

運用面ではCPUとGPUのリソース分割が導入され、使用するリソースをユーザーが指定できるようになった。また、ディープラーニング関連の研究開発が増えたことを受けて、各種の機械学習フレームワークが提供された。合わせて、Webブラウザを通してジョブの投入などが可能になり、利用のしやすさは格段に向上した。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- 急成長中の中国ヒューマノイド大手AgiBotの技術戦略

- 光通信入門事始め――古代の人々ののろしと同じように光で信号を送ってみよう

- イチから全部作ってみよう(29)3つのノート整理法からたどるRDBMSの基礎知識

- AIスパコンやロボット活用で「稼げる農業」へ、農研機構と東京工科大が連携協定

- 宇宙用途向け耐放射線FPGAが欧州の宇宙用部品規格の認定を取得

- OKIエンジが北関東校正センターを設立「計測器校正は第三者校正が主流に」

- デジタルツイン向けマルチLiDAR異常検知技術を開発

- IIJの法人モバイル契約数が350万回線に、マルチプロファイルSIM2.0の特許も取得

- IoTゲートウェイの課題はデータの欠損と変換、IIJ子会社が新コンセプトで解決へ

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【前編】

コーナーリンク