東工大「TSUBAME 4.0」は“みんなのスパコン”としてどのような進化を遂げたのか:AIとの融合で進化するスパコンの現在地(1)(1/3 ページ)

急速に進化するAI技術との融合により変わりつつあるスーパーコンピュータの現在地を、大学などの公的機関を中心とした最先端のシステムから探る本連載。第1回は、2024年4月に稼働を開始した東京工業大学の「TSUBAME 4.0」を取り上げる。

いわゆるスーパーコンピュータ(スパコン)をはじめとするHPC(高性能コンピューティング)インフラは、高度なシミュレーションや創薬、ビッグデータ解析など、企業のモノづくりや事業創出に欠かせない存在となっている。さらに、生成AI(人工知能)をはじめとするAI技術の急速な進化により、これらのHPCインフラでAIをどのように活用できるようにするかも大きな課題となっている。

本連載では、日本国内のスパコン環境の一端を探るべく、大学などの公的機関を中心とした最先端のシステムを紹介していく。第1回は、2024年4月に稼働を開始した東京工業大学の「TSUBAME 4.0」を取り上げる。【訂正あり】

4世代目となる“みんなのスパコン”が2024年4月に稼働を開始

2024年4月1日、東京工業大学(以下、東工大)すずかけ台キャンパス(横浜市緑区)の一角で、“みんなのスパコン”の4世代目となる「TSUBAME 4.0」(図1〜3)が稼働を開始した。2017年8月に稼働した3世代目の「TSUBAME 3.0」から数えて、6年8カ月ぶりの更新となる。

図1 東工大すずかけ台キャンパスで稼働した「TSUBAME 4.0」。奥にさらに2列のラックが並ぶ。最前列のラック扉には、2023年10月に行われたデザインコンテストで最優秀賞となった、だみ氏のデザインが描かれている[クリックで拡大] 撮影:関行宏

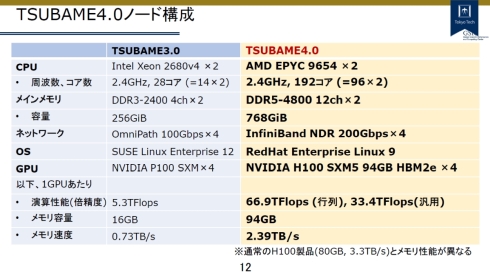

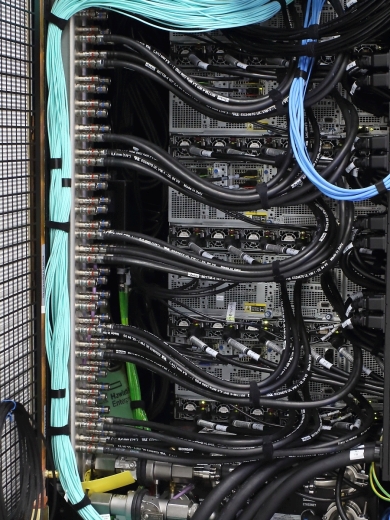

図1 東工大すずかけ台キャンパスで稼働した「TSUBAME 4.0」。奥にさらに2列のラックが並ぶ。最前列のラック扉には、2023年10月に行われたデザインコンテストで最優秀賞となった、だみ氏のデザインが描かれている[クリックで拡大] 撮影:関行宏 図2 TSUBAME 4.0のラックに組み込まれた計算ノード。左に並ぶ連結栓から出ている黒いチューブは、CPUとGPUを冷却する水冷用のホース(in/out)である。メモリなどは空冷で、排熱はラック扉の熱交換機(左端のメッシュ部分)で冷やされる[クリックで拡大] 撮影:関行宏

図2 TSUBAME 4.0のラックに組み込まれた計算ノード。左に並ぶ連結栓から出ている黒いチューブは、CPUとGPUを冷却する水冷用のホース(in/out)である。メモリなどは空冷で、排熱はラック扉の熱交換機(左端のメッシュ部分)で冷やされる[クリックで拡大] 撮影:関行宏TSUBAMEは、日本屈指のスパコンシステムの一つであり、東工大の研究をはじめ官民の研究開発に活用されてきた。

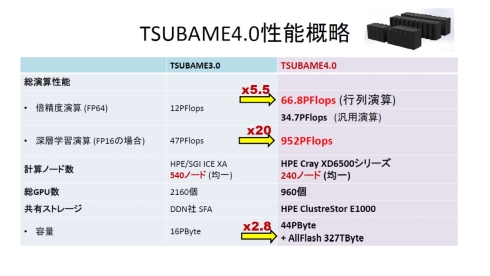

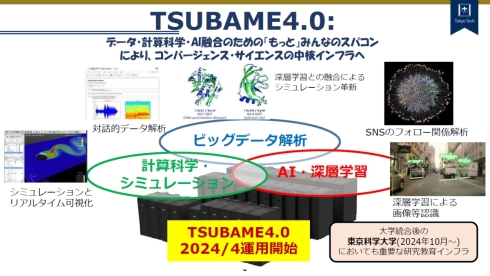

新しいTSUBAME 4.0の理論性能は、倍精度(FP64)の行列演算でTSUBAME 3.0の5.5倍に相当する66.8PFlops、半精度(FP16)の深層学習ではTSUBAME 3.0の20倍に相当する952PFlopsと発表されており、性能は国内トップクラスだ(図4)。流体解析、材料探索、創薬、物理シミュレーション、ディープラーニングおよび生成AIなどの研究開発を後押ししてくれるものと期待されている(図5)。

図4 TSUBAME 4.0の概略性能。AIで重要となるFP16(半精度)性能で、従来のTSUBAME 3.0比で20倍の性能を得ている[クリックで拡大] 出所:東工大 学術国際情報センター「TSUBAME 4.0スーパーコンピュータ 利用者ガイダンス」

図4 TSUBAME 4.0の概略性能。AIで重要となるFP16(半精度)性能で、従来のTSUBAME 3.0比で20倍の性能を得ている[クリックで拡大] 出所:東工大 学術国際情報センター「TSUBAME 4.0スーパーコンピュータ 利用者ガイダンス」 図5 TSUBAME 4.0は、コンバージェンスサイエンスの中核インフラとして、計算科学やシミュレーション、ビッグデータ解析、AI/深層学習などさまざまな分野で大きな成果が得られると期待されている[クリックで拡大] 出所:東工大 学術国際情報センター「令和6年度 TSUBAME共同利用公募 説明会」資料

図5 TSUBAME 4.0は、コンバージェンスサイエンスの中核インフラとして、計算科学やシミュレーション、ビッグデータ解析、AI/深層学習などさまざまな分野で大きな成果が得られると期待されている[クリックで拡大] 出所:東工大 学術国際情報センター「令和6年度 TSUBAME共同利用公募 説明会」資料ハードウェアは、CPUとしてAMD EPYC 9654×2個とNVIDIA H100 Tensor コア GPU(Hopperアーキテクチャ)×4個をそれぞれ搭載した240台のノードで構成されている。すなわち総GPU数は960だ(図6)。高価で、かつ、入手が難しいH100が960個も装備されているTSUBAME 4.0は、膨大な計算パワーを必要とするディープラーニングや生成AIの研究者にとっては垂ぜんのシステムといえるだろう。

しかも、一般的なNVIDIA H100 Tensor コア GPUはVRAM容量が80GBだが、TSUBAME 4.0に採用されているNVIDIA H100 SXM5はVRAM容量が94GBと大きく、例えば生成AIの研究開発においてより大きな言語モデルを扱うことができるのも特徴である。

東工大のTSUBAME 4.0は、大学のスパコンなので民間企業とは関係ないように感じられるが、“みんなのスパコン”というコンセプトにのっとって利用は学外にも開放されている。実際にさまざまな企業が歴代のTSUBAMEシステムを自社の研究開発に活用してきた。詳しくは本記事の後半で紹介する。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

コーナーリンク