複雑で分かりにくいAIを判断基準が明確なAIに変換する単純化技術を開発:人工知能ニュース

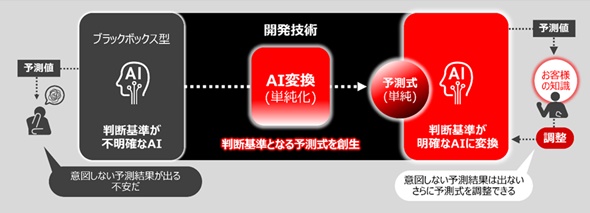

日立製作所は、従来のブラックボックス型AIを判断基準が明確なAIに変換する「AI単純化技術」を開発した。経験や知識に基づいてユーザー自身で予測式を調整可能とし、信頼できるAIの構築を容易にする。

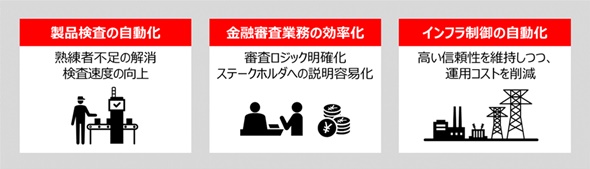

日立製作所は2021年12月24日、従来のブラックボックス型AI(人工知能)を判断基準が明確なAIに変換する「AI単純化技術」を開発したと発表した。同技術の一部を、同社グループにおいて製品出荷前の自動検査ラインに適用し、熟練者不足の解消や検査速度の向上効果を確認している。

信頼できるAIには、精度だけでなく、説明性、透明性、品質、公平性などが必要になる。従来のブラックボックス型AIは、予測精度が高い一方、数式が複雑で判断基準が不明確のため、未知のデータに対して意図しない予測結果を導く不安やリスクを抱えていた。

同社はあらゆる入力に対して、人が理解できる単純な予測式を作り、明確な判断基準の下で予測結果を提示できる技術を開発した。さらに、経験や知識に基づいてユーザー自身で予測式を調整可能とし、信頼できるAIの構築を容易にした。

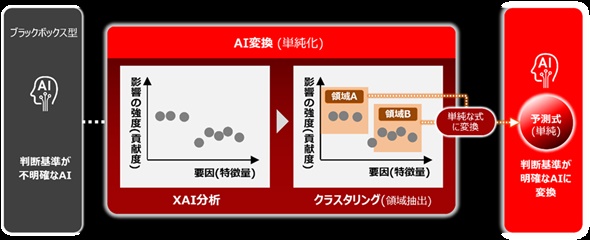

具体的には、既に開発済みのeXplainable AI(XAI)技術を利用して、入力データの特徴量が予測値に及ぼす影響の強さを貢献度として算出。次に、特徴量が変化しても予測値への貢献度が一定の入力データ領域をクラスタリング技術により抽出し、その領域でAIを単純な予測式に変換する。同様の処理を全入力データ領域で繰り返すことで、最終的にユーザーに分かりやすい単純な予測式を提供する。

これにより、製造、金融、インフラ制御などさまざまな領域で、信頼できるAIの実装を可能にし、社会全体のDX(デジタルトランスフォーメーション)に貢献する。

関連記事

AIが判断した根拠を一般ユーザーにも分かるように明示、三菱電機と理研が新技術

AIが判断した根拠を一般ユーザーにも分かるように明示、三菱電機と理研が新技術

三菱電機が理化学研究所と共同で「制御の根拠を明示できるAI技術」を開発。今回開発したAI技術によって、AIが判断した制御の根拠や将来の状態を明示することでいわゆる「ブラックボックス問題」を解消し、人が理解しやすいAIの実現に貢献できる。今後は、5年以内となる2026年をめどに製品への搭載による実用化を目指すとしている。 「NG画像不足」を解決、少量データで特徴抽出するAI技術スパースモデリング

「NG画像不足」を解決、少量データで特徴抽出するAI技術スパースモデリング

機械学習と比較して10分の1の教師データで特徴抽出を完了できるスパースモデリング技術。製造業の現場改革にどのように貢献し得るのか。ハカルス 取締役 CBOの染田貴志氏に話を聞いた。 結果を改善するためのアクションを提示できる「説明可能なAI」を開発

結果を改善するためのアクションを提示できる「説明可能なAI」を開発

富士通研究所は、AIが判断理由を示す「説明可能なAI」において、人が望む結果を得るために必要な手段を提示できる技術を北海道大学と共同開発した。AIの適用が、判断だけでなく、人の意思行動を支援する用途にも広がることが期待される。 AIプロダクトの品質保証をAI技術で支援する、「AI4QA」という考え方

AIプロダクトの品質保証をAI技術で支援する、「AI4QA」という考え方

AIの社会的影響力が高まる中で、AIそれ自体の品質保証の重要が高まっている。品質保証を実現する上で重要になる考えとは何か。 エッジAIや説明可能なAIは“過度の期待のピーク”へ

エッジAIや説明可能なAIは“過度の期待のピーク”へ

米国の調査会社Gartnerは「先進技術におけるハイプサイクル2020年版」を発表した。調査結果によると、「コンポーザブルエンタープライズ」「データファブリック」「組み込み型AI」「セキュアアクセスサービスエッジ(SASE)」「説明可能なAI」などが「過度の期待のピーク」に入った。 AIをブラックボックスにしないために、“判断の根拠”の解析を

AIをブラックボックスにしないために、“判断の根拠”の解析を

日立超LSIシステムズ 組込ソリューション事業部の猪貝 光祥氏が、NVIDIAのユーザーイベント「GTC Japan 2018」(2018年9月13〜14日)において、AIの品質保証に関する最新動向を紹介した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- チップレットでASIL Dを支援する車載SoC技術を開発

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

コーナーリンク