結果を改善するためのアクションを提示できる「説明可能なAI」を開発:人工知能ニュース

富士通研究所は、AIが判断理由を示す「説明可能なAI」において、人が望む結果を得るために必要な手段を提示できる技術を北海道大学と共同開発した。AIの適用が、判断だけでなく、人の意思行動を支援する用途にも広がることが期待される。

富士通研究所は2021年2月4日、AI(人工知能)が判断理由を示す「説明可能なAI」において、人が望む結果を得るために必要な手段を提示できる技術を発表した。北海道大学との共同研究で開発した。

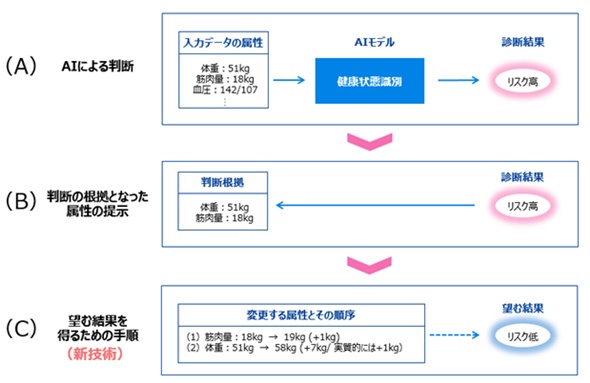

両者はは、これまでにもAIの判断理由を人間に説明できる新しいAI技術を開発してきた。今回の技術は、「反実仮想説明」という手法を利用。この技術では、過去の事例の分析から非現実的な変更を避けるとともに、属性値の変更が他の属性値に与える影響もAIが推定し、実際に必要な変更量を計算することで、適切な順序かつ最も少ない労力で最適な結果が得られるアクションを提示できる。

例えば健康診断において、体重や筋肉量などのデータから病気になるリスクをAIが判断し、判断の根拠となったデータを提示する。これに加え、データがどう変化すれば病気のリスクが下がり、望ましい結果になるかを提示可能になる。これによりAIの適用が、判断だけでなく、人の意思行動を支援する用途にも広がると期待される。

今後、富士通研究所は、今回の開発成果と個別の因果関係を発見する技術を組み合わせて、より適切な手段を提示できるよう研究を続ける。また、同技術の2021年度の実用化を目指し、富士通のAI技術「FUJITSU Human Centric AI Zinrai」に活用するとしている。

北海道大学は、さまざまな現場データから人間の意思決定に役立つ知識や情報を抽出するためのAI技術を確立していく。

関連記事

エンジニアの最初の選択肢となるAI、2021年に注目すべき5つのトレンドとは

エンジニアの最初の選択肢となるAI、2021年に注目すべき5つのトレンドとは

製造業での活用が広がり始めたAI(人工知能)ですが、2021年以降にどのような方向性で進化していくのでしょうか。本稿では注目すべき5つのトレンドを取り上げます。 エッジAIや説明可能なAIは“過度の期待のピーク”へ

エッジAIや説明可能なAIは“過度の期待のピーク”へ

米国の調査会社Gartnerは「先進技術におけるハイプサイクル2020年版」を発表した。調査結果によると、「コンポーザブルエンタープライズ」「データファブリック」「組み込み型AI」「セキュアアクセスサービスエッジ(SASE)」「説明可能なAI」などが「過度の期待のピーク」に入った。 ボッシュが開発に取り組む“説明可能なAI”

ボッシュが開発に取り組む“説明可能なAI”

Robert Bosch(ボッシュ)が2017年1月にAIセンター(BCAI:Bosch Center for Artificial Intelligence)の稼働を発表してから半年が過ぎた。年次会見にAIセンターのグローバル責任者であるクリストフ・パイロ氏が出席、AIセンターの目的や取り組みについて語った。 教師データなしで異常値を検出できるAI技術を開発

教師データなしで異常値を検出できるAI技術を開発

富士通研究所は、教師データなしで高次元データの特徴を正確に獲得するAI技術「DeepTwin」を開発した。情報圧縮技術と深層学習を融合し、ネットワークへの不正アクセスや、医療データの異常値をAIで検知する。 正しい手洗い動作を自動判定する映像認識AI技術を開発

正しい手洗い動作を自動判定する映像認識AI技術を開発

富士通研究所は、カメラで撮影した映像から手洗い動作を認識するAI「行動分析技術 Actlyzer手洗い動作認識」を開発した。厚生労働省が推奨する正しい手の洗い方6ステップの実施と、各ステップで手をこすった回数を自動で認識できる。 ソフトウェアバグに対する修正案をAIが提案、富士通らが実証実験

ソフトウェアバグに対する修正案をAIが提案、富士通らが実証実験

富士通、三井住友フィナンシャルグループ、日本総合研究所は、AIを活用してソフトウェアの修正案を開発者に自動推奨する技術の実証実験を実施した。潜在バグを開発者が手作業で修正する場合と比べて、修正時間を最大約30%削減できる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

コーナーリンク

健康診断データにおける同技術活用例 出典:富士通研究所

健康診断データにおける同技術活用例 出典:富士通研究所