ファーウェイの学習用AIチップは「世界最速」、独自AIフレームワークも投入:人工知能ニュース

ファーウェイ(華為技術)は2019年8月23日(現地時間)、AI(人工知能)チップ「Ascend 910」とAIフレームワーク「MindSpore」を発表した。同社はAscend 910が世界最高性能を実現したAI学習用プロセッサであると主張。米中貿易戦争の先行きが見通せない中、AI領域の技術開発を全方位で進める。

ファーウェイ(華為技術)は2019年8月23日(現地時間)、AI(人工知能)チップ「Ascend 910」とAIフレームワーク「MindSpore」を発表した。同社はAscend 910が世界最高性能を実現したAI学習用プロセッサであると主張。米中貿易戦争の先行きが見通せない中、AI領域の技術開発を全方位で進める。

AI専用プロセッサの開発はさまざまな企業、研究機関で進められている。Preferred Networks(PFN)が2018年12月に発表した学習用プロセッサ「MN-Core(エムエヌ・コア)」は、FP32(単精度)で131TFLOPS、FP16で524TFLOPSのピーク性能を有しており、予測消費電力は500W。Googleが開発する「Cloud TPU(Tensor Processing Unit) v3」では、1ユニットで420TFLOPSの演算性能を持つという。

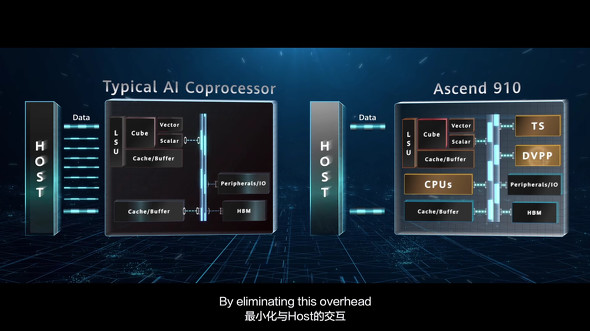

今回発表されたAscend 910のピーク性能は、FP16(半精度)で256TFLOPS、INT8(8ビット整数)で512TOPSを発揮する。最大消費電力は310W。ホストとのデータ転送で発生するオーバーヘッドを抑えるため、同チップは典型的なAI専用コプロセッサと異なり、CPUやタスクスケジューラーを統合したSoC(System on Chip)としたことが特徴となる。

チップ間の通信を担うインターコネクト「HCCS(High-Speed Direct Point-to-Point Interconnect)」も独自開発され、帯域幅はポートあたり240Gbpsだ。その他、インタフェースとして100GbpsのRoCE(RDMA over Converged Ethernet)やポートあたり256GbpsのPCI Expressを備えている。Ascend 910は同社製サーバなどに搭載された形で顧客に提供する。

MindSporeは、GoogleのTensorFlowやFacebookのPyTorchと同じくAIフレームワークとなる。アプリケーション開発の容易さと実効性能の向上、クラウドに限らずエッジ、デバイスなど全てのシナリオに適応できることを目指し、開発された。ユーザーデータのプライバシーやセキュリティ確保に配慮して設計したとする。

Ascend 910とMindSporeを組み合わせてResNet-50の学習を行った場合、TensorFlowと従来のメインストリーム向け学習用カードと比較して約2倍高速であると主張し、自然言語処理アプリケーションのコーディングでは、他の主要なフレームワークより20%少なく記述でき、開発者の効率を少なくとも50%向上させるという。同フレームワークはAscendチップの他、CPUやGPU、その他タイプのプロセッサもサポートしており、2020年第1四半期にオープンソース化される予定だ。

発表会に参加した同社副会長のエリック・シュー(徐直軍)氏は、「フルスタックAIポートフォリオが完成した」と自信を見せた。Huaweiは2018年10月にエッジ向けのAIチップ「Ascend 310」を発表しており、同社製スマートフォンでもAI処理性能を重視したSoCの搭載を進める。Ascend 910とMindSporeの登場により、AIに関連するハードウェアとソフトウェアがエッジからクラウドのレイヤー全てに渡ってそろうことになる。

関連記事

PFNが深層学習プロセッサを開発した理由は「世界の先を行くため」

PFNが深層学習プロセッサを開発した理由は「世界の先を行くため」

Preferred Networks(PFN)は2018年12月12日、ディープラーニングに特化したプロセッサ「MN-Core(エムエヌ・コア)」を発表した。同プロセッサは学習の高速化を目的とし、行列の積和演算に最適化されたものとなる。FP16演算実行時の電力性能は世界最高クラス(同社調べ)の1TFLOPS/Wを達成した。 HPCとAI性能を両立したポスト「京」のCPU、ウエハーが初公開

HPCとAI性能を両立したポスト「京」のCPU、ウエハーが初公開

富士通は2019年5月14日、同社のプライベートイベント「富士通フォーラム2019 東京」(2019年5月17日、東京国際フォーラム)の内覧会で、次世代スーパーコンピュータであるポスト「京」に搭載されるプロセッサ「A64FX」のウエハーが初公開された。 グーグルの深層学習プロセッサ「TPU」が「AIを、全ての人に」を実現する

グーグルの深層学習プロセッサ「TPU」が「AIを、全ての人に」を実現する

グーグル(Google)は2018年7月6日、東京都内でメディアセミナーを開き、同社がディープラーニング(深層学習)向けに開発してきたプロセッサ「TPU」について説明した。 Intel、10nmプロセス世代FPGA「Agilex」を発表――アーキも一新

Intel、10nmプロセス世代FPGA「Agilex」を発表――アーキも一新

米Intelは2019年4月2日(現地時間)、同社の10nmプロセス技術を採用したFPGAファミリー「Agilex(アジレックス)」を発表した。同社は現在展開している「Stratix」や「Aria」「MAX 10」などの全FPGAブランドをAgilexブランドに統一する方針だ。 Google Cloudは機械学習を手軽に実現、エッジで画像の推論にも対応

Google Cloudは機械学習を手軽に実現、エッジで画像の推論にも対応

Google Cloudが2019年4月9〜11日に開催した年次カンファレンス「Google Cloud Next ’19」で、エッジで動作する画像解析の推論モデルを容易に構築できるサービス「Cloud AutoML Vision Edge(以下、Vision Edge)」が発表された。 ラズパイゼロで推論も学習もできる組み込みAI「DBT」、“AIチップ”で開発容易に

ラズパイゼロで推論も学習もできる組み込みAI「DBT」、“AIチップ”で開発容易に

AIベンチャーのエイシングが、組み込み機器などのプロセッサでAIの推論実行だけでなく学習も行える独自技術「DBT」について説明。このDBTによるアプリケーション開発を容易に行えるAIモジュール「AiiR(エアー)チップ」を開発したと発表した。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- チップレットでASIL Dを支援する車載SoC技術を開発

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

コーナーリンク

Huawei副会長の徐直軍氏に披露された「Ascend 910」 出典:Huawei

Huawei副会長の徐直軍氏に披露された「Ascend 910」 出典:Huawei