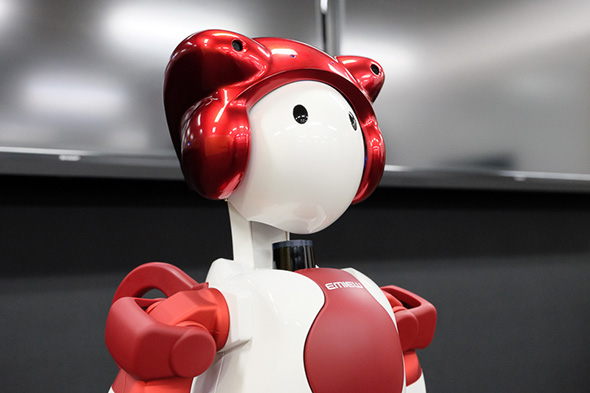

「EMIEW3」に見えた、ヒトとロボットの共生(3/4 ページ)

リモートブレイン構成によるインテリジェンス機能

ここでは音声認識を例に紹介するが、音声認識エンジンはEMIEW3のためだけに開発したというものではなく、日立の中で以前から研究開発されてきた技術だ。例えば「コールセンターの音声を分析する」といった需要から音声認識の研究開発は行われており、それをベースにしている。

ただ、電話の音声を取得し認識するのとは異なり、ロボットの対話では話者とマイクとの距離が50cmから1mくらいはある。そうするとどうしても会話以外の音も集音してしまうので、14個のマイクを使って情報を集めて音声を抽出している。その抽出された音声を認識エンジンにかけることで、ようやくロボットが理解できる「情報」としての下準備が完了となる。

その後、中身に対する処理、例えば「東京駅への行き方を教えてください」という話しかけがあれば、その意図を理解し、回答を用意し、答えを音声合成でEMIEWの声に変換する。変換した音声ファイルをEMIEWに転送して、EMIEWから発話するという流れだ。

データを送ってクラウド上で処理をし、本体に送るという流れで気になるのはやはり遅延だが、前述のような音声処理であっても、現状、応答時間を1〜2秒弱まで圧縮することができている。ロボットIT基盤の膨大なリソースを使うことで、この高速処理ができるようになっているという。

本体側の処理とリモートブレイン側の処理は、このように、音声を認識したりするような、多少は遅延が許されるというような処理はリモートブレイン側で行い、一方、人とぶつからないように止まる、など反射的な判断はEMIEW3側で瞬時に行うという形で、あらかじめ設計できるところは切り分けがされている。

将来的に、EMIEWが世の中に大量に存在するとなると、運用上のクラウドの負荷が心配になるところだが、EMIEWをコンピュータにつなぐことで処理の一部を負担するエッジコンピューティング的な手法などで、負荷を分散するやり方も検討しているという。

今回の実証実験では、まずは数台から始める形になる。その上で、もうちょっと広げてみようということになれば台数を増やしたり、別の場所や店舗で展開する可能性も出てくる。1つの構成として1つの場所では1台だとしても、離れたところにEMIEWがいて会話をしていたりすると、データはクラウド上で処理するため集約して、一緒に賢くなることができる。そういったことも実証実験では取り組んでいくという。

Copyright © ITmedia, Inc. All Rights Reserved.

ロボットの記事ランキング

- 人の優しさ引き出す“弱いロボット”、パナソニックが一般販売開始へ

- パナソニック初のコミュニケーションロボットは弱い!? クラファン目標は即日達成

- 優しくハグする力持ちのクマ型ロボット

- ミクシィのコミュニケーションロボットは独自AIで“雑談”に付き合ってくれる

- きゅんくんも参加、ロボットスタートがラボ開設

- ROSを使う手順、パッケージとシミュレータの活用

- 驚異的な演算/運動性能を兼ね備えた次世代犬型ロボ「PUDU D5」シリーズが誕生

- 猫が乗っても迷わない、“ルンバ史上最強”「980」は何がスゴいのか

- 自動充電機能追加で稼働性能向上、ヒト型サービスロボ「EMIEW4」日立が発売

- AWS RoboMakerでロボットの機械学習トレーニングをしてみよう

コーナーリンク