ディスクリートGPUまで手に入れたインテル、AI全方位戦略を強化:人工知能ニュース

インテルは2019年11月27日、記者向けにAIに対する最新の取り組みについて説明会を開き、グローバルで先日発表されたGPUアーキテクチャ「Xe(エックスイー)」を含め、同社のAI向けプロセッサポートフォリオを紹介した。

インテルは2019年11月27日、記者向けにAIに対する最新の取り組みについて説明会を開き、グローバルで先日発表されたGPUアーキテクチャ「Xe(エックスイー)」を含め、同社のAI向けプロセッサポートフォリオを紹介した。

インテルはCPU、FPGA、AI専用アクセラレーター(ASIC)、そしてディスクリートGPUと、「全方位にAIを展開」(インテル 技術本部 本部長 土岐英秋氏)するプロセッサラインアップを完成させる。米Intelは2017年11月、米AMDのGPU部門を率いていたラジャ・コドゥリ氏をグラフィックス領域担当の上級副社長に迎えている。それから約2年後となる2019年11月17日(米国時間)、「SC19(Supercomputing 2019)」の場でXeアーキテクチャを採用するディスクリートGPU「Ponte Vecchio」が発表された。

Ponte Vecchioは、HPC(High Performance Computing)やAIのユースケースに向けて開発された「インテル初のエクサスケールGPU」(同社)だという。次世代の7nmプロセスノードで生産され、新たな3Dダイスタッキング技術「Foveros」を用いている。CXL(Compute Express Link)規格ベースのキャッシュコヒーレンシなインターコネクト「Xeリンク」を新たに採用する。なお、日本語におけるPonte Vecchioの発音は「未定」(土岐氏)で、登場時期も明らかにしなかった。

インテルはXeアーキテクチャを、HPCやAIといった高負荷なワークロードから電力の制約が厳しいモバイルまで、幅広い用途のGPUに適用する考え。Xeアーキテクチャは、柔軟なデータ並列ベクターマトリクスエンジンに広い帯域幅を有するキャッシュとメモリが接続されることが特徴。倍精度浮動小数点演算で高いスループットを示すという。

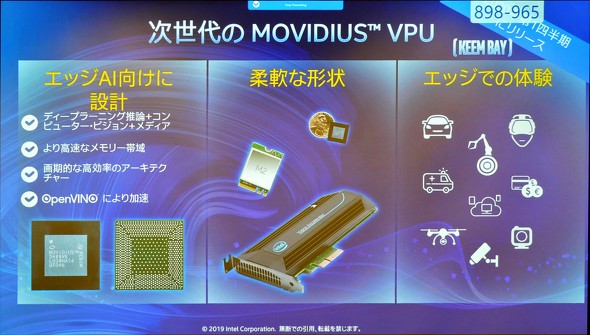

また、同年11月12日には次世代のコンピュータービジョンおよびエッジ推論向けプロセッサ「Movidius VPU(Vision Processing Unit)」(コードネーム:Keem Bay)を発表。また、ニューラルネットワーク専用ASIC「Nervana NNP(Neural Network Processor)」についてデモを行っている。

Keem Bay世代のMovidius VPUはエッジAI向けに設計したとし、広帯域なオンチップメモリと高効率なアーキテクチャを実装した。前世代の「Movidius Myriad X VPU」と比較して性能は10倍に向上したという。チップレベルやM.2、PCI Expressなど、さまざまなフォームファクタで提供を予定している。2020年第1四半期に登場する見込みだ。

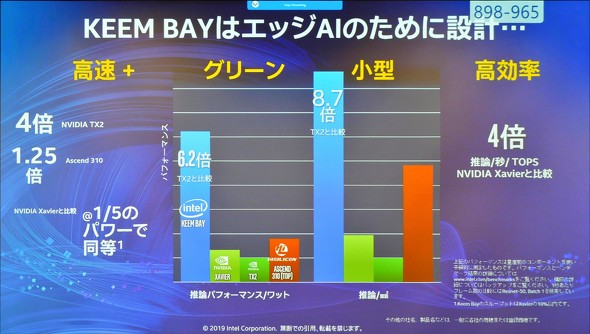

競合製品との比較では、NVIDIA TX2の4倍高速かつ、1ワットあたり6.2倍の推論パフォーマンス、1mm2のフットプリントあたり8.7倍の推論パフォーマンスを示すと紹介した。

Nervana NNPはデータセンターやクラウドを志向するAI専用ASICだ。学習では「NNP-T」、推論では「NNP-I」とワークロード別にチップが用意している。NNP-Iは「手のひらサイズで50兆回/秒の計算を実現する」とうたっており、提供開始時に市販の推論アクセラレーターとして最高の消費電力当たりの処理性能を達成する見込みだという。また、高集積化を果たしており、NVIDIA T4システムと比較して単位ラックスペースあたり最大3.7倍のコンピューティング密度を提供する。2019年内に生産を開始し、生産初期は一部の顧客のみに提供を行う方針だ。

このように、インテルは幅広いプロセッサアーキテクチャを用意し、ユースケースに応じて組み合わせることで顧客ニーズを満たす構えだ。ヘテロジニアスアーキテクチャシステムで課題となる、アーキテクチャをまたがるソフトウェア開発の複雑化や最適なヘテロジニアスシステムの探索は、コンピュータビジョン開発ソフトウェア「OpenVINO」や新たに導入した統合型プログラミングモデル「oneAPI」、インテルのコンピューティングクラウドプラットフォーム「Intel DevCloud」によって解決するという。

関連記事

AIに“全方位”で挑むインテル、GPUや専用プロセッサとどう戦うか

AIに“全方位”で挑むインテル、GPUや専用プロセッサとどう戦うか

インテルは2018年12月17日、東京都内で記者説明会を開催し、2018年における同社の活動の振り返りと2019年以降の展望について説明した。本稿では、説明会で示された内容の中でAI(人工知能)やB2Bコンピューティングに関するトピックを中心に紹介する。 Intel、10nmプロセス世代FPGA「Agilex」を発表――アーキも一新

Intel、10nmプロセス世代FPGA「Agilex」を発表――アーキも一新

米Intelは2019年4月2日(現地時間)、同社の10nmプロセス技術を採用したFPGAファミリー「Agilex(アジレックス)」を発表した。同社は現在展開している「Stratix」や「Aria」「MAX 10」などの全FPGAブランドをAgilexブランドに統一する方針だ。 インテルがFPGA部門とネットワーク部門を統合、CPU不足は第3四半期に解消か

インテルがFPGA部門とネットワーク部門を統合、CPU不足は第3四半期に解消か

インテルは2019年6月20日、東京都内で記者会見を開催し、同社の2019年第2四半期の状況と、FPGA製品およびネットワーク製品部門の戦略について説明した。 インテルが低コストな物流ソリューションを本格展開、日通も採用

インテルが低コストな物流ソリューションを本格展開、日通も採用

インテルは2019年3月28日、東京都内で記者会見を開催し、物流業界向けIoT(モノのインターネット)ソリューション「インテル コネクテッド・ロジスティクス・プラットフォーム(インテル CLP)」を日本市場で本格展開すると発表した。 かつて世界一を支えたNECのベクトル演算技術、いま「次世代イノベーション」を担う

かつて世界一を支えたNECのベクトル演算技術、いま「次世代イノベーション」を担う

同社が東京都内で開催したユーザーイベント「C&Cユーザーフォーラム&iEXPO2019」(2019年11月7〜8日)では、最新の「SX-Aurora TSUBASA」アーキテクチャを搭載したベクトルプロセッサなどを展示。また、2019年11月1日からはメモリ帯域を強化した新製品の受注も開始している。 IoTから脱落した巨人インテルの蹉跌、かくもIoTビジネスは難しい

IoTから脱落した巨人インテルの蹉跌、かくもIoTビジネスは難しい

IoTの団体や規格/標準についての解説をお届けしてきた本連載も最終回。最後は、団体ではなくインテルという特定の企業のこの数年の動向を紹介しながら、IoTというビジネスを総括してみたい。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 出荷量1.3倍を実現、電源不要のIoTゲートウェイが南種子町にもたらす農業改革

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

コーナーリンク

インテルの土岐英秋氏

インテルの土岐英秋氏