実用化への道は開けた!? 広がりを見せる非接触型ユーザーインタフェース技術:組み込みイベントリポート【ESEC2013】(1/3 ページ)

2013年5月8〜10日の3日間、東京ビッグサイトで開催された「第16回 組込みシステム開発技術展(ESEC2013)」の展示会場から、“次世代インタフェース技術”をキーワードに、筆者が注目したブース展示をピックアップしてリポートする。

2013年5月8〜10日の3日間、東京ビッグサイトにおいて、組み込みシステム開発に必要なソフト/ハード/開発環境の専門展示イベント「第16回 組み込みシステム開発技術展(ESEC2013)」(主催:リード エグジビション ジャパン)が開催された。筆者は初日と2日目に取材したのだが、両日とも、各ブースでは熱心に質問する来場者の姿が多く見られ、通路もところどころスムーズに歩けないほどの盛況ぶりだった。

本稿では、インテルと日本マイクロソフト・ブースを紹介したリポート第1弾に続いて、“次世代インタフェース技術”をキーワードに、展示会場内で筆者が注目した展示デモを幾つかピックアップして紹介したい。

デジタルサイネージや医療システム、広がるジェスチャーインタフェース

ジェスチャーインタフェースでサイネージをもっとアピール

ダックスのブースでは、デジタルサイネージ向けの次世代ジェスチャーインタフェースとして、女性がまるでダンスをしているかのようなジェスチャー(動き)で、デモンストレーション(以下、デモ)を行っていた。

福岡市に本拠を置くネクストシステムとトーメンエレクトロニクスが開発した非接触型ユーザーインタフェースと、イスラエルのPrimeSenseが開発した3Dセンサー(PrimeSenseは、マイクロソフトのモーションセンサーデバイス「Kinect」の開発元として知られる)とを組み合わせたもの。サイネージコントローラは、ダックスの「HFBX-6100 M270」が用いられていた。

手先の動きを検出して、ディスプレイに表示される多数のサムネイルから1つの画像を選んだり、自動車の3Dデータを任意の位置から眺められるよう表示させたりといったデモを披露していた。このインタフェースは、デジタルサイネージシステムとしての採用実績はまだないが、昨今、ユーザーがデジタルサイネージの存在に慣れるにつれ、「ただ映像を流すだけでは、街の背景に埋没してしまう」(説明員)ことが懸念されており、“よりアピールできるサイネージ”の形として、こうしたナチュラルユーザーインタフェース(NUI)を研究しているという。

デモシステムのサイネージコントローラ「HFBX-6100 M270」には、第3世代 インテル Core i5/i7 プロセッサを搭載したCPUボード「HFMB-70」が内蔵されている。ダックスのデジタルサイネージコントローラは、首都圏のJR各駅で設置が進んでいる全面ディスプレイ型の飲料自動販売機で採用されているそうだ

デモシステムのサイネージコントローラ「HFBX-6100 M270」には、第3世代 インテル Core i5/i7 プロセッサを搭載したCPUボード「HFMB-70」が内蔵されている。ダックスのデジタルサイネージコントローラは、首都圏のJR各駅で設置が進んでいる全面ディスプレイ型の飲料自動販売機で採用されているそうだ医療現場での活用も進む

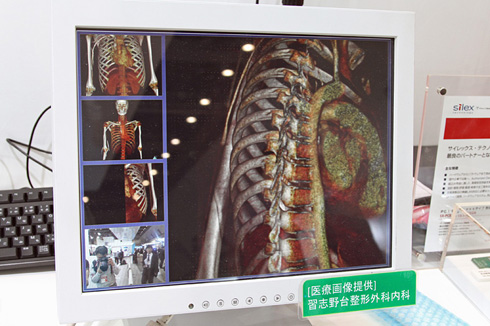

ユニダックスが披露していた医療現場向けの非接触型ユーザーインタフェースソリューションのデモ。「Kinect for Windowsセンサー」とディスプレイの位置関係は実際のシステムと同等とのこと。静電容量センサーの影響か、ディスプレイの視野角は比較的狭かった

ユニダックスが披露していた医療現場向けの非接触型ユーザーインタフェースソリューションのデモ。「Kinect for Windowsセンサー」とディスプレイの位置関係は実際のシステムと同等とのこと。静電容量センサーの影響か、ディスプレイの視野角は比較的狭かったジェスチャーを使うような非接触型ユーザーインタフェースの適用例として、デジタルサイネージとともに有望視されているのが、医療現場向けのソリューションだ。患者のカルテやレントゲン画像などがデジタル化され、手術室などの現場で医者がそうした情報を、手を触れずに簡単に閲覧できるソリューションが求められている。ユニダックスは、マイクロソフト内のミニブースで、病院で実際に使われているシステムを展示していた。

これは手術室などで、医師がディスプレイに直接触ることなく、患者のカルテやレントゲン画像をはじめとした各種情報を表示・閲覧できるソリューションである。ディスプレイの上に3Dセンサー(Kinect for Windows)を設置し、離れた位置からジェスチャーによって操作できる他、ディスプレイ表面には静電容量型センサーが搭載されていて、画面に近寄って情報を見る際には、指先をディスプレイに近づけて(タッチする必要はない)のジェスチャー操作も可能だ。

屋外でも安定したジェスチャー認識

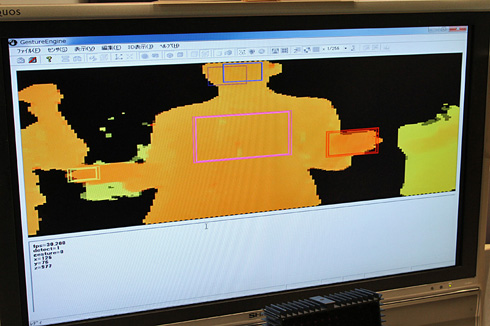

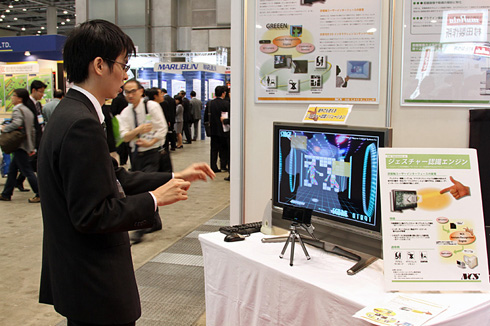

ジェスチャー動作を捉える仕組みとして“距離情報”に着目したのが、日本コントロールシステムのジェスチャー認識エンジン「GREEEN(Gesture REcognition Engine ENviromnment)」だ。同社ブースでは、オプテックスの赤外線3D距離画像カメラを使用した屋外を想定したソリューションと、独PMD Technologiesのカメラを使用した自動車のダッシュボードを想定したソリューションの2つのデモを行っていた。

日本コントロールシステムの「GREEEN」のジェスチャー認識デモの様子。ディスプレイに表示されている黄色い立方体が左の男性の手先の動きに追従している。ディスプレイ手前に見える黒い直方体のデバイスがオプテックスの赤外線3D距離画像カメラ

日本コントロールシステムの「GREEEN」のジェスチャー認識デモの様子。ディスプレイに表示されている黄色い立方体が左の男性の手先の動きに追従している。ディスプレイ手前に見える黒い直方体のデバイスがオプテックスの赤外線3D距離画像カメラ赤外線3D距離画像カメラは、カメラ側から位相変調した赤外線を出し、対象物までの距離をカメラの1ピクセルごとに計測できる。オプテックス製品では、カメラから5mまでの範囲で160×120ピクセルのデータとして出力される(距離誤差は対象物までの距離の約1%)。GREEEN自身は、3Dデータが利用できれば、Kinect for Windowsなどの他のセンサーでも問題ないが、これらセンサーは着衣の色や背景、環境光など外乱に弱い傾向がある。これに対し、赤外線3D距離画像カメラは外乱に強く、屋外でも安定した3D認識ができるメリットがあるという。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

- 1.5km離れた漁場をWi-Fi HaLowなどで可視化、海洋モニタリングの実証に成功

コーナーリンク