産業界で使い倒せる日本語LLMを リコーが自前のモデル開発に取り組み始めたワケ:製造業×生成AI インタビュー(2/3 ページ)

AWSの支援プログラムに参加して開発

リコーの130億パラメーターのLLMは、MetaのオープンソースLLMであるLlama2(130億パラメーター)に事前学習させて開発したものだ。AWSジャパンが提供した「AWS LLM 開発支援プログラム」に参加して、AWSのAI開発インフラや技術支援などを受けながら開発した成果物となる。

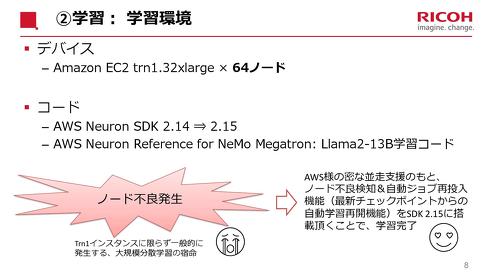

学習インフラにはAWSのAI学習用チップ「Amazon Trainium」を用いた「Amazon EC2 Trn1 インスタンス」(最大サイズのtrn1.32xlargeを64ノード)を活用している。2022年にもAWSと協力して60億パラメーターのLLMを開発したが、こちらはGPUベースで作っており、今回がAmazon Trainiumを用いた初めての開発となる。

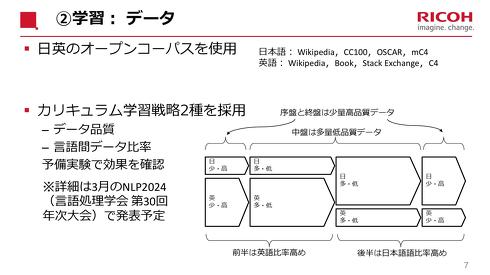

学習データには日英両言語のオープンコーパスを使用した。日本語ではWikipedia、cc100、OSCAR、mc4などを用いている。日本語も英語も適切にクレンジングを行ったデータを使用した。

学習手法として、学習の序盤と終盤に少量高品質なデータを、中盤に多量低品質なデータを多く含ませることで、高品質なデータ、中盤に低品質なデータを用いるという戦略を採用した。将来的に産業分野に適用した場合に、必ずしも質が担保されないデータを扱う可能性もあるが、そうした場合でも頑強な日本語性能を発揮できるようにする。

なお、まだリコーは独自LLMに対して具体的な名称を定めておらず、「グローバルの展開を視野に入れた名称を検討中だ」(梅津氏)という。

連携のしやすさを視野に入れてインフラを選定

リコーがLLMの自社開発を進めるのは、日本語への対応力が高く、高いオープン性を持ち、かつ、追加学習可能なLLMが日本全体でまだまだ足りていないと考えるからだ。産業向けにLLMを展開していく上では、企業向けにカスタマイズされたLLM提供が必要不可欠になる。「社内データベースの検索システムを構築する場合、文脈によって“ジャム”という言葉が、食べ物ではなく紙詰まりであることを理解できるかが大事になる」(梅津氏)。このため、追加学習に適した形態のLLMを自前で用意することを決めた。

梅津氏によると60億パラメーターのLLMを開発した時点で、「130億パラメーターのモデル開発にも着手していた」という。ただし、機械学習インフラの選定などで課題があり開発はなかなか進まなかった。

その後、機械学習の学習と推論プロセスを最適化するSDK「AWS Neuron SDK」の存在や、リコーが業務特化型のAIソリューションを開発する上で、「Amazon SageMaker」などデータの追加学習や分散学習に適した機能やサービスが用意されていることから、AWSをインフラとして活用することを決めた。リコーのデジタルサービスの開発運用基盤である「RICOH Smart Integration」もAWS上で構築しており、将来的な連携のしやすさも視野に入れている。

Copyright © ITmedia, Inc. All Rights Reserved.

製造マネジメントの記事ランキング

- finalはなぜASMR専用イヤホンを展開するのか、目指す“音を感じる世界”の拡張

- ソニー製品で採用、14社がリニューアブルプラスチックのサプライチェーンを構築

- ERPを“ごみ屋敷”にしない、AIを即戦力にする次世代データ基盤の構築術

- 帳票の翻訳作業を75%削減、BOPを中心としたブラザー工業のオペレーショナルDX

- インフラ保守や工場知能化に向けデジタル基盤に最先端AIを統合、三菱電機と燈

- 製造業にも吹くAI旋風、関連需要に期待が集まる

- 日立がCIセクターの体制を刷新、新たなセクターCEOにCOOの網谷憲晴氏が就任

- AIデータセンター向け製造装置の自動ステージを増産、中国とベトナムに20億円投資

- 車載電池は停滞もAI電源は好調、パナソニックHDは構造改革費用が膨らみ下方修正

- ソニーGは第3四半期も過去最高業績、懸念はメモリ価格の高騰

コーナーリンク