PFNが独自深層学習用プロセッサの専用コンパイラを開発、6倍以上の高速化を実現:人工知能ニュース

Preferred Networks(PFN)は、神戸大学と共同開発した深層学習用プロセッサ「MN-Core」について、深層学習のフレームワークとして広く用いられているPyTorchからシームレスにMN-Coreを利用するための専用コンパイラを開発した。深層学習における複数の実用的なワークロードの計算速度で、従来比6倍以上の高速化を実現したという。

Preferred Networks(PFN)は2021年6月14日、神戸大学と共同開発した深層学習用プロセッサ「MN-Core」について、深層学習のフレームワークとして広く用いられているPyTorchからシームレスにMN-Coreを利用するための専用コンパイラを開発したと発表した。深層学習における複数の実用的なワークロードの計算速度で、従来比6倍以上の高速化を実現したという。【訂正あり】

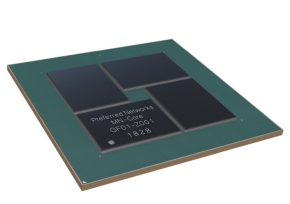

PFNの深層学習専用プロセッサとして開発されたMN-Coreは、スーパーコンピュータの省電力性能を示す「Green500リスト」で2020年6月に1位を獲得したPFNのプライベートスーパーコンピュータ「MN-3」に搭載されている。深層学習ワークロードに特化したアクセラレータであり、深層学習で頻出する畳み込み演算を高速化するために、多数の高効率な行列演算器ユニットを階層的に束ねた構造を持っている。また、各階層間では縮約/放送など深層学習ワークロードでよく用いられる集団通信を行うことができる。

MN-Coreは、単一の命令で全ての計算ユニットを動作させるSIMD(Single Instruction Multiple Data)モデルのアーキテクチャの採用や、一般的なプロセッサではハードウェアが自動的に制御するキャッシュや各演算器間のデータパスなどをプログラマーが制御できることなども特徴となっている。この、大きなSIMDでかつハードウェアによって制御される領域が少ないアーキテクチャは、適切に制御を行うことで非常に高い効率を実現できる反面、高効率に利用するためにはプログラマーが考えるべきことが多いという課題も抱えている。

MN-Coreを搭載するMN-3は、PFNの開発者が手掛けるさまざまなワークロードを実行できることが求められるものの、全ての開発者がMN-Coreのアーキテクチャを理解した上で個別に性能を引き出すプログラミングを行うことは現実的とはいい難い。そこで、MN-Coreを簡単かつ高効率に利用するために開発したのが今回の専用コンパイラになる。

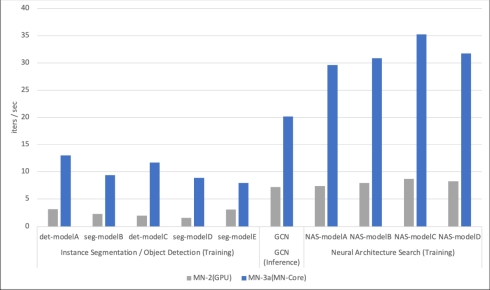

同コンパイラを用いて、従来のPFNのスーパーコンピュータ「MN-2」に搭載されている汎用GPUと比較する形でMN-Coreの性能評価を行った。具体的には、MN-2とMN-3について、それぞれ1アクセラレータボードを利用した場合の実機での実行速度を比較している。まず、コンピュータビジョンの代表的な問題であるインスタンスセグメンテーション(Instance Segmentation)やオブジェクトディテクション(Object Detection)を含めたCNN(畳み込みニューラルネットワーク)ベースのモデルについては、MN-CoreはGPUと比べて6倍以上の性能を達成。グラフ構造の分析に用いられるGCN(グラフ畳み込みニューラルネットワーク)ベースのネットワークを用いた物理シミュレーションは最大3倍、深層学習モデルを設計するための一手法であるNAS(構造自動探索)は平均4倍程度の高速化を実現できたという。

深層学習ワークロードにおける「MN-2」と「MN-3」の単位時間あたりの処理性能比較。左から、インスタンスセグメンテーション/オブジェクトディテクション、GCN、NASの比較結果(クリックで拡大) 出典:PFN

深層学習ワークロードにおける「MN-2」と「MN-3」の単位時間あたりの処理性能比較。左から、インスタンスセグメンテーション/オブジェクトディテクション、GCN、NASの比較結果(クリックで拡大) 出典:PFN【訂正】PFNの発表文では当初「インスタンスセグメンテーションにおいて6倍以上」となっていましたが、2021年6月23日付で「インスタンスセグメンテーションだけでなく、オブジェクトディテクションのモデルを含めて6倍以上」という訂正がありました。これに合わせて、本記事の表記を修正し、グラフも差し替えました。

なお、今回の研究開発成果は、2021年6月15日に半導体技術の国際会議「2021 Symposia on VLSI Technology and Circuits」で発表する予定だ。

関連記事

PFNがGreen500で世界記録を達成した理由、独自発想のスパコン用プロセッサとは

PFNがGreen500で世界記録を達成した理由、独自発想のスパコン用プロセッサとは

Preferred Networks(PFN)は2020年11月16日、高い省電力性を特徴とする深層学習用スーパーコンピュータ(スパコン)「MN-3」の開発の意義や狙いを紹介する説明会を開催した。MN-3は同年6月22日に発表されたスパコンの省電力性能ランキング「Green500リスト」で世界1位を、同年11月17日に公表された最新のGreen500リストにおいては世界2位をそれぞれ獲得した。 スパコン性能ランキングで日本がトップに、TOP500は「富岳」でGreen500は「MN-3」

スパコン性能ランキングで日本がトップに、TOP500は「富岳」でGreen500は「MN-3」

2020年6月22日に、オンラインで開催中のHPCの国際会議「ISC2020」で発表された複数のスーパーコンピュータランキングにおいて、日本のシステムが1位を獲得した。TOP500の1位は理化学研究所と富士通が共同開発した「富岳」、Green500の1位はPFNが開発した「MN-3」が入った。 建築現場用ロボット向けの自律移動システムを開発、AI清掃ロボットに導入へ

建築現場用ロボット向けの自律移動システムを開発、AI清掃ロボットに導入へ

鹿島建設とPreferred Networksは、建築現場用ロボット向けの自律移動システム「iNoh」を開発した。実用化の第1弾として、AI清掃ロボット「raccoon」に搭載し、首都圏の現場に導入を開始している。 深層学習技術を用いたX線画像診断補助ツールを肺がん検診に導入

深層学習技術を用いたX線画像診断補助ツールを肺がん検診に導入

Preferred Networks、京都府、京都府医師会、NOBORIは、京都府で実施される肺がん検診で、深層学習技術を用いた胸部X線画像の診断補助ツールを試験導入し、医師の診断負荷および見落としリスクの低減効果について評価する。 PFNがコンピュータサイエンス教育事業に参入、問題解決型人材を育成へ

PFNがコンピュータサイエンス教育事業に参入、問題解決型人材を育成へ

Preferred Networksは2020年7月6日、コンピュータサイエンス教育事業に参入するとオンライン会見で発表した。PFNによる最先端のコンピュータサイエンス技術や、これらの技術を生かした社会問題の解決などのノウハウを生かし、重要度が高まる論理的かつ創造的な思考力を持つ人材育成に取り組む。 PFNがChainerの開発を終了しPyTorchへ移行、西川社長「非常に大きな決断」

PFNがChainerの開発を終了しPyTorchへ移行、西川社長「非常に大きな決断」

Preferred Networks(PFN)は2019年12月5日、同社が開発する深層学習フレームワーク「Chainer」のメジャーアップデートを終了すると発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- パナソニックの弱いロボット「NICOBO」がLLMでさらなる進化、累計販売は1万体に

- ソニーがSTB不要のデジタルサイネージを提案、AIデジタルヒューマンも組み込める

- Rapidusの顧客獲得が進捗、60社以上と協議中で約10社にPDKをライセンスへ

- あなたの家電がサイバー攻撃の踏み台に? 購入時は星マークをチェックしよう

- 家電のノジマがロボットショールームにヒューマノイドや業務用を展示する理由

- スバルが制御統合ECU向けマイコンにインフィニオンの「AURIX TC4x」を採用

- チップレットでASIL Dを支援する車載SoC技術を開発

- 製造業の「SBOM」は誰が構築し運用/管理すべきか【後編】

- 一度の顔登録で複数サービス利用可能 NECの顔認証基盤、トライアルなどで実証導入へ

- 1.5km離れた漁場をWi-Fi HaLowなどで可視化、海洋モニタリングの実証に成功

コーナーリンク