TOP500国内1位のAIスパコン、計算ノード内部を初披露:CEATEC 2018(1/2 ページ)

産業技術総合研究所は、「CEATEC JAPAN 2018」(2018年10月16〜19日、幕張メッセ)で、AI(人工知能)やビッグデータ処理向けスーパーコンピュータ(スパコン)「人工知能処理向け大規模・省電力クラウド基盤(AI Bridging Cloud Infrastructure、以下ABCI)」を利用した機械学習技術などについて展示を行った。

産業技術総合研究所は、「CEATEC JAPAN 2018」(2018年10月16〜19日、幕張メッセ)で、AI(人工知能)やビッグデータ処理向けスーパーコンピュータ(スパコン)「人工知能処理向け大規模・省電力クラウド基盤(AI Bridging Cloud Infrastructure、以下ABCI)」を利用した機械学習技術などについて展示を行った。

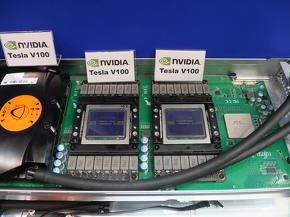

ABCIは富士通が開発を担当し、2018年8月から本格運用を開始した。2018年6月に発表されたスーパーコンピュータ性能ランキングの1つである「TOP500」では、世界5位、国内1位を獲得している。今回の展示では、ABCIの計算ノード内部も公開され、国内初披露となった。

LINPACKピーク性能は19.88PFLOPS

ABCIは、演算を実行する「高性能計算システム」と足回りの役割を担う「大容量ストレージシステム」で構成する。

高性能計算システムは、計算ノードとして富士通製サーバ「PRIMERGY CX2570 M4」を採用し、1088台の計算ノードを集積する。システム全体のメインメモリは476テビバイト(TiB)。理論ピーク性能は、FP16(16ビット浮動小数点)で550PFLOPS、FP64で37.2PFLOPSとし、TOP500でベンチマークとして用いられるLINPACKでは19.88PFLOPSを達成した。

計算ノード1台の構成として、CPUはIntel Xeon Gold 6148を2基(システム合計で2176基)、GPUはNVIDIA Tesla V100を4基(同4352基)、メインメモリはDDR4-2666規格で384ギビバイト(GiB)、ローカルストレージはNVMe(Non-Volatile Memory Express)接続のIntel SSD DC P4600(容量1.6Tバイトモデル)を搭載する。各計算ノード間と大容量ストレージシステムのインターコネクトには、InfiniBandを用いる。

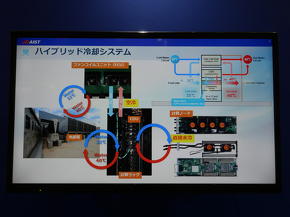

CPUとGPUの冷却では水冷と空冷を併用。「計算ノード内に3系統設置した冷却ラインで、インレット側が30℃、アウトレット側が40℃の温水により直接水冷を行っている。システムの負荷によって、各ノード内に流れる冷却水の流量を調整しており、最小で毎分2L、最大で毎分6Lとなる」(産総研担当者)。

暖められた冷却水は、計算ラック上部に設置されたCDU(冷却水循環装置)とFCU(ファンコイルユニット)で熱交換され、発生した熱気は屋外設置されたパッシブ冷却塔とアクティブチラーにより冷却する。この冷却システムにより、ABCIの平均PUE(電力使用効率)は1.1以下となった。

Copyright © ITmedia, Inc. All Rights Reserved.

製造マネジメントの記事ランキング

- 生産性100倍に、富士通がソフトウェア開発をAIエージェントで自動化する開発基盤

- 従業員のスキルに応じた「ランク認定制度」も 三菱電機が推進するDX人材育成施策

- 日本は本当に遅れているのか? AI×現場力で始まる日本型モノづくりの逆襲

- 「好きなことは楽しめる間にとことん楽しむ」という考え方の重要性について

- パナソニックは新技術拠点「Technology CUBE」で“実装力のあるR&D”を強化

- アイリスオーヤマなど、無線制御技術を軸に建設業界の課題解決に向けた協業開始

- IOWN APNと画像認識AIにより、約300km離れた工場での外観検査に成功

- AIエージェントが代わりに働くようになったら人は何をするの?

- 永守氏がニデック完全退任、「経営者としての私の物語にピリオド」

- 「中国のスペースX」銀河航天は衛星をどう量産するのか 製造デジタル基盤の全貌

コーナーリンク