10nm採用の第3世代「Xeon SP」はエッジでも展開、AI性能はNVIDIA「A100」の1.3倍:組み込み開発ニュース(1/2 ページ)

インテル日本法人がデータセンター向けの「Xeonスケーラブル・プロセッサー(以下、Xeon SP)」の第3世代品を発表。10nmプロセスを採用することで、14nmプロセスの第2世代Xeon SPと比べて平均46%の性能向上を果たした。主な用途は、クラウド、エンタープライズ、HPC、5Gの他、IoTなどエッジでの利用も可能としている。

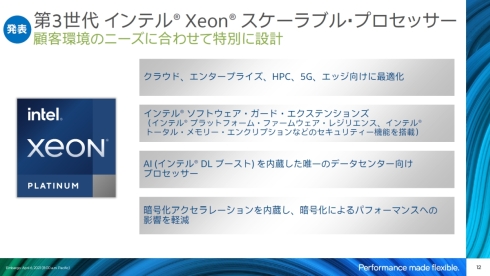

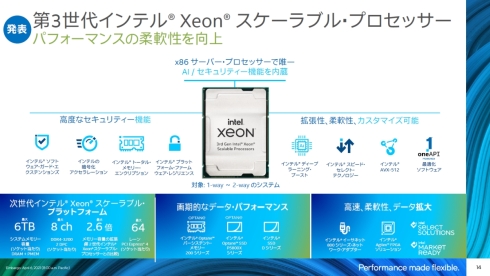

インテル日本法人は2021年4月7日、オンラインで会見を開き、データセンター向けの「Xeonスケーラブル・プロセッサー(以下、Xeon SP)」の第3世代品(開発コード名:Ice Lake)について発表した。10nmプロセスを採用することで、14nmプロセスの第2世代Xeon SP(開発コード名:Cascade Lake)と比べて平均46%の性能向上を果たすとともに、AI(人工知能)による推論のアクセラレーション機能や高度なセキュリティ機能、暗号化アクセラレーション機能などを内蔵することで顧客の求めるさまざまな用途に柔軟に対応できる。主な用途としてクラウド、エンタープライズ、HPC、5Gを挙げている他、IoT(モノのインターネット)などエッジでの利用も可能としている。2021年1〜3月期の時点で、幅広い業界に対して既に20万ユニット以上を出荷しているという。

インテル日本法人 社長の鈴木国正氏は「当社が注力しているクラウド、HPC、AI、5G、エッジなどの分野ではビジネスニーズと需要がダイナミックに変化している。これに対しては、Performance made flexible=パフォーマンスの向上が優れた柔軟性を実現する、という考え方に基づき取り組みを進めている」と語る。

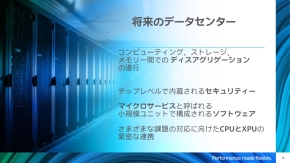

また、クラウドをはじめとしたデータセンターでは、コンピューティング、ストレージ、メモリといった各機能のディスアグリゲーション(細分化)、チップレベルで内蔵されるセキュリティ、マイクロサービスと呼ばれる小規模ユニットで構成されるソフトウェア、さまざまな課題の対応に向けたCPUとXPU(CPU以外のプロセッサユニット)の緊密な連携という4つの技術が重要になると指摘。「そしてこれら4つの技術を支えるのが、新たな製造戦略『IDM 2.0』だ」(鈴木氏)として、IDM 2.0を提唱した米国本社CEOのパット・ゲルシンガー(Pat Gelsinger)氏の下で取り組みを進めていくことを言明した。

「Xeon SP」は2017年から累計5000万個以上を出荷

Xeon SPは、2017年に第1世代が投入されてから5000万個以上が出荷され、800社以上のクラウドベンダーが採用するなどデータセンターを支えるインフラとなっている。今回発表した第3世代のXeon SPでは、クラウド、エンタープライズ、HPC、5G、エッジなど各分野の顧客が求めるさまざまな要求を1つのプロセッサ製品でどのようにサポートしていくかに主眼を置いて開発が進められた。

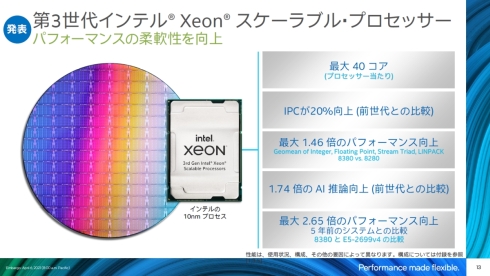

とはいえ、第2世代から第3世代に進むことで第一に求められるのは性能向上だ。第3世代Xeon SPは10nmプロセスを採用しており、搭載可能な最大コア数は、第2世代の28コアから40コアに拡大した。コア単位での性能についても、第2世代比でIPC(クロックサイクル当たりの実行可能命令数)が20%向上している。これらの掛け合わせにより、プロセッサ単位での性能は同46%の向上を果たした。さらに、AI推論の性能についても同74%向上できている。インテル日本法人 執行役員常務 技術本部 本部長の土岐英秋氏は「データセンターの設備更新タイミングを迎えている5年前のシステム(Xeon E5-2699)と比較すると最大2.65倍の性能向上になる」と強調する。

Xeon SPはプロセッサ単体としての性能向上もさることながら、メモリやSSD、ネットワークアダプターなどを含めたプラットフォームとの組み合わせで、先述した各分野の顧客が求めるさまざまな要求に対応する柔軟性を提供している。まず。メモリのバンド幅の強化に向けて、1ソケット当たりの最大メモリ容量は6TB、DDR4-3200に対応するメモリチャネル数は最大8となり、PCI-Express 4の最大レーン数も64となった。また、インテル独自の「Optane パーシステント・メモリ」や、超高速SSDである「Optane SSD」に対応しており、イーサネットネットワークアダプターは最大200Gbpsの伝送速度に対応する「800シリーズ」を用意した。加えて、第3世代Xeon SPと同じく10nmプロセス採用の最新FPGA「Agilex」との組み合わせで最大400Gbpsのイーサネット接続も可能になるという。

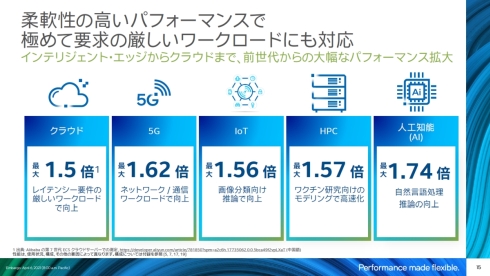

Xeon SPが第2世代から第3世代に進化することによる性能向上については、クラウド、5G、IoT、HPC、AIといった現在需要が高まっている用途で重視される項目でも紹介した。例えば、レイテンシ要件の厳しいワークロードを扱うクラウドで最大1.5倍、IoTにおける画像分類向け推論では最大1.56倍、ワクチン研究向けのモデリングに用いるHPCの高速化で1.57倍などだ。

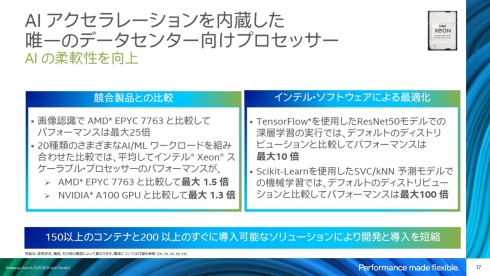

競合となるAMDの「EPYC 7763」やNVIDIAの「A100 GPU」と、第3世代Xeon SPの性能比較も披露した。EPYC 7763との比較では、画像認識では最大25倍の性能を発揮できることを確認した。また、20種類のさまざまなAI/ML(機械学習)ワークロードを組み合わせた比較では、第3世代Xeon SPの性能はEPYC 7763の最大1.5倍、A100 GPUの最大1.3倍になったという。土岐氏は「インテルで最適化したソフトウェアを用いればさらなる性能向上が可能になる。例えば、TensorFlowを使用したRestNet50の深層学習では、最適化により10倍の性能向上が得られる」と説明する。なお、これらのAI処理性能の高さは「DLブースト」と呼ぶAIアクセラレーション機能に基づくものだ。

Copyright © ITmedia, Inc. All Rights Reserved.

組み込み開発の記事ランキング

- 急成長中の中国ヒューマノイド大手AgiBotの技術戦略

- 光通信入門事始め――古代の人々ののろしと同じように光で信号を送ってみよう

- イチから全部作ってみよう(29)3つのノート整理法からたどるRDBMSの基礎知識

- AIスパコンやロボット活用で「稼げる農業」へ、農研機構と東京工科大が連携協定

- デジタルツイン向けマルチLiDAR異常検知技術を開発

- OKIエンジが北関東校正センターを設立「計測器校正は第三者校正が主流に」

- 宇宙用途向け耐放射線FPGAが欧州の宇宙用部品規格の認定を取得

- IIJの法人モバイル契約数が350万回線に、マルチプロファイルSIM2.0の特許も取得

- IoTゲートウェイの課題はデータの欠損と変換、IIJ子会社が新コンセプトで解決へ

- マイクロチップがエッジAI向けフルスタックソリューションを拡充

コーナーリンク

インテル日本法人の鈴木国正氏

インテル日本法人の鈴木国正氏