製造業のAI活用に欠かせないコンテナ、導入の鍵は“情シス”か:AI開発環境

製造業のAI活用に期待が高まる一方で、実際にはAI導入が依然として進んでいない状況がある。これにはどういった理由があるのだろうか。数多くの製造業にNVIDIAの製品やサービスを中心にAI関連のソリューションを提案してきたマクニカ クラビス カンパニー所属の北島佑樹氏と山田智教氏に話を聞いた。

AI(人工知能)への注目が、社会のあらゆる場面で高まっている。既にAIが導入された業務やサービスでは、大量で複雑な処理が自動化されている。そして、顧客満足度の向上やサプライチェーンの最適化、予測確率のアップといった成果が得られている。

製造業でもAIの活用によるさまざまな成果が期待できる。しかし、長年AI活用が求められているにもかかわらず、製造業へのAI導入が依然として進んでいない状況がある。これにはどういった理由があるのだろうか。数多くの製造業にNVIDIAの製品やサービスを中心にAI関連のソリューションを提案してきたマクニカ クラビス カンパニー所属の北島佑樹氏と山田智教氏に話を聞いた。

AI開発とサービス提供、各インフラに対する課題とは

AI開発のインフラ構築を中心に手掛ける北島氏は「日本の製造業におけるAI開発の段階は、まだ初期フェーズにあります」という認識を示す。現在の段階は、各部署でさまざまなPoC(概念実証)が行われ、ユースケースの検証、検討が行われているところにある。

ここで問題になるのが、AI開発に向けて担当部門が開発インフラを個別に調達してしまうことだ。例えば、当初は数少ないAI技術者1人に対して1台のGPUサーバ/ワークステーションを割り当てる。しかしこのやり方を続けていくと、AI開発のフェーズが進行して技術者が増えたときにGPUリソースの効率的な運用ができなくなる。AIの開発規模が大きくなり必要なリソースが増えたときに課題として顕在化するというわけだ。

AI開発のGPUリソースを最適化するには、技術者ごとにハードウェアを用意するのではなく、AI開発のためのクラスタ化されたGPUインフラを作る必要がある。このクラスタ化されたインフラの構築、運用を担当するのは、既存のIT管理部門、いわゆる“情シス”になる。しかし、情シス部門には、AI開発インフラの構築と運用を避けたい本音が見え隠れする。今までに経験のない新しい技術の導入や理解、整備の手間などが増えるからだ。

もしAI開発環境を構築でき、AIを活用した製品やサービスを投入できた後にも課題が出てくる。AI開発環境とは別に、製品やサービスに用いるAIを適宜アップデートするための別途のインフラ整備が必要になるが、ここでもその構築や運用は情シス部門が担当することになる。

これらAI関連インフラの整備は大きな投資であり、経営陣の決断が必要なことは確かだ。しかし、それにも増して、情シス部門をいかに取り込むかが重要になってくるのである。

多品種少量生産はAI導入の難易度が高い

一方、製造ラインへのAI導入やエッジAI機器の開発を支援する山田氏は、高い付加価値のモノづくりができるとして国内工場に残された多品種少量生産が、モノづくり現場でのAI導入が遅れている理由として挙げる。同じ製品を一気に作るわけではない製造環境は、AIによる自動化の効果を出しにくい。また、多様な工作機械や製造機が並ぶ製造現場では、AIの導入がそもそも困難な場合も多い。

この他「AIを導入する際のROI(投資利益率)に関して見積もりがしにくい場面も多くあります」(山田氏)という。AIによる自動化を行うには、その製造ラインを熟知している必要があり、AI開発担当者などの外部の人間がそれを理解するのは困難だ。そのため、導入効果の見極めが甘い状態にもかかわらず、高額の見積もりが出たりする。

効果を検証するためにPoCが行われることも多いが、期間が長く、工数が必要な割にその効果測定がしづらいことも課題になっている。また、データ共有などで製造現場以外の部署との連携も必要になるPoCでは、その連携がうまく機能しないという問題が顕在化することもある。

これは、先の情シス関連と同様、組織的な課題だ。製造業でAIを導入するには、組織としての対応が必要になるということを示している。山田氏は「PoCで効果が出ない場合、当然ながら実運用には進めないので、PoC倒れになってしまう企業をたくさん見てきました。PoCに過度な期待をしてしまいがちなのですが、必ずしも一発で成功するとは限りません。AI導入には根気強いトライ&エラーが必要です。すなわち、経営層のコミットメントを中心とした事業部門、DX部門、IT部門などの“全ての関係者”が現状や課題の認識を共有しアクションにつなげていくことが重要です」と指摘する。

AI活用のベースとなるコンテナ技術

AI開発環境のプラットフォームとして、既に標準となりつつあるのが仮想環境の一種であるコンテナだ。コンテナは、ホストOS上のコンテナエンジンによって管理され、従来の仮想環境のようにホストOS上でゲストOSを起動するようなOSの二段重ねが不要であり、リソースを効率的に活用できる。また、ライブラリやミドルウェア、アプリケーション、ツールなどをパッキングして配布できるため、AI開発のフレームワークを含め、開発に必要な環境を手軽に構築/管理できる。

北島氏は「AI開発において『Docker』や『Kubernetes』などのコンテナ技術はほぼデファクト」とし、コンテナ以外を使う余地はないと語る。そして、コンテナによって技術者がAI開発環境の準備や立ち上げなどにリソースを割くことなく、開発業務そのものにフォーカスできるとメリットを説明する。

ただし、製造業におけるコンテナの活用はまだ進んでいないようだ。一部の大手企業では積極的に活用する例もあるが、中堅中小企業に限れば「コンテナ」という単語が出るまでにも至っていないケースが多いという。

山田氏は、この理由を「セキュリティの懸念やローカルデバイスの監視をオンプレミス環境で行っている現状にあるため」と推測する。例えば、製造の現場では、NC装置やHMI、PLCといった多様なローカルデバイスの監視や制御をオンプレ環境で行っている場合が多い。ここにコンテナを導入しようとすると、現在ある全ての環境を再構築する必要が出てくる。これを毛嫌いして、コンテナの導入が進まないという流れは想像しやすい。

北島氏は、これに加えて「情シス部門にとって、クラウドネイティブのアプリケーション環境としてのコンテナは、ハードルがまだまだ高い」と話す。ただし、製造業がAIモデルを作り、それをエッジデバイスに展開した際には、その管理にコンテナは必須となるとも。コンテナを使えば、新しいイメージを再配布するだけでバージョンアップやモデルの再学習ができる。これは、AIを活用する上で非常に魅力的な要素となる。

コンテナによるAI開発を容易にする「NGC」と「NVIDIA AI Enterprise」

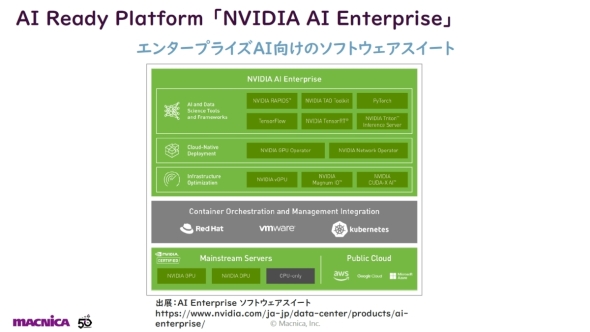

AI関連の技術開発で業界をけん引するNVIDIAは、コンテナによるAI開発を容易にするソリューションの整備を進めてきた。代表的なのが、2017年5月発表の「NGC」と、2021年8月発表の「NVIDIA AI Enterprise」である。

まずNGCは、AI開発で使用可能なさまざまなコンテナイメージをクラウド上で提供するものだ。ユーザーは、これらの中から必要なものをダウンロードし自身のPCにインストールすればよい。これだけで、最適化されたAI開発環境が得られる。従来のようにGPUドライバのインストールや機械学習プラットフォームのバージョンの組み合わせなどに気を使う必要はない。開発環境の構築が自動化されるので、技術者が本来業務であるAI開発にフォーカスできるのだ。またNGCには、学習済みのAIモデルも多数用意されているので、これらをベースにして効率良くAI開発を進められることもメリットになる。

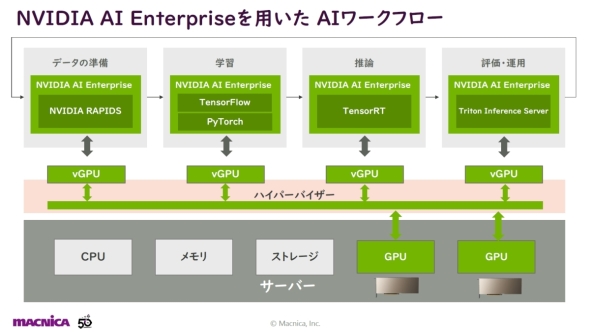

一方、NVIDIA AI Enterpriseは、企業内におけるAI開発のワークフローを効率的に回せるようにするソフトウェアスイートである。AI開発のワークフローでは、データの準備、学習、推論、評価と運用というプロセスサイクルを繰り返して回していくことになるが、NVIDIA AI Enterpriseには各プロセスで用いられるソフトウェアがパッケージされているので、企業としてAI開発環境を導入する際に利用しやすい。

そして、NVIDIA AI Enterpriseの最大の特徴はVMwareの仮想化ソフトウェア「VMware vSphere」に対応している点だろう。一般的に、コンテナの実行環境にはLinuxが用いられている。しかし、製造業の情シス部門がオンプレミスで稼働するLinux環境(しかもGPUあり)を運用している事例は少なく、このことがAI開発環境を企業内で効率的に導入する際の障壁になっていた。しかし、ITインフラの統合で広く用いられているVMware vSphere上で動作するNVIDIA AI Enterpriseは、製造業の情シス部門にとって導入しやすいソリューションになっているのだ。

「NGC」で力を発揮するロボット開発プラットフォーム「NVIDIA Isaac」

製造業がモノづくりの現場や、開発している製品・サービスにAIを導入する上でも、NGCやNVIDA AI Enterpriseは大いに役立つ。例えばNGCは、ロボット開発プラットフォームとして提供している「NVIDIA Isaac(以下、Isaac)」を活用する際に力を発揮する。BMWが、車両ごとに平均100種類用意されているオプション装備に対応した高効率な生産の実現を目指して採用したことでも知られている。

Isaacは、AGV(無人搬送ロボット)やAMR(自律搬送ロボット)、ピッキングロボットなどの開発に用いられている。シミュレーション環境である「Isaac Sim」は、バーチャル空間の中でAIモデルの学習を積み重ねることが可能であり、開発したAIモデルをリアル空間のロボットに実装して試験するなど、いわゆるバーチャルとリアルから成る“デジタルツイン”の活用を容易にしてくれる。NGCであれば、これらのAIモデルやシミュレーション環境がコンテナ化されているので容易に開発環境を構築できる。

NVIDIA AI Enterpriseは、NGCやIsaacを活用して開発したAIモデルを企業内で多部署にまたがって運用する際には不可欠なソリューションになる。AIモデルは一度開発したらそれで終わりではなく、さらに得られたデータを基に改善のための学習を積み重ねていくことになる。この再学習によって改善されたAIモデルを製品やサービスに展開する際に、AI開発のワークフロー全般をカバーするNVIDIA AI Enterpriseを介して各担当部署への受け渡しを行うことで、いわゆる「MLOps」へ発展させていくことが可能になってくるのである。

サービスソリューションプロバイダーを目指して加速中

ここまでNVIDIAのNGCやNVIDIA AI Enterprise、Isaacの強みを紹介してきたが、これらを手掛けるマクニカならではの強みはどういったところにあるのだろうか。

山田氏が挙げたのが「ソリューションの提供力」である。もともとNVIDIAの製品やサービスは、先進的な技術に裏付けられた競争力があるため、商材として顧客に提案しやすい。しかし、マクニカが“半導体商社”の状態にとどまっていては新たな価値を生み出せない。NVIDIAとの信頼関係をベースにしたソリューションの提供力は、その回答の一つだ。マクニカは、NVIDIA Jetsonに代表される多くのNVIDIA製品を扱ってきた。また、AIモデルの開発に関してもIsaacを含むソリューションをサポートし、NVIDIAと強い関係性を構築してきた。これらの実績を通じて蓄積した経験やノウハウがマクニカの強みとなる。

山田氏は、マクニカが目指すものを「サービスソリューションプロバイダー」と表現する。そして、「NVIDIA製品やサービスを活用して社会にAIを実装していく上では、当社の競合は半導体商社ではありません。将来的には、コンサルティングも可能なサービスソリューションプロバイダーを目指す必要があります」と述べる。

北島氏はマクニカの強みを技術力の高さから説明する。マクニカは、社員の3分の1が技術者だ。当然ながら、その技術力を顧客への大きな付加価値に位置付けている。この技術の対象は、JetsonやGPUサーバ、GPUカードはもちろん、NGCやNVIDIA AI Enterpriseといったソフトウェアにも及ぶ。「これらを総合的に技術サポートして、お客さまの課題に合ったものや関連するものを先取りして提案できるところに強みがあります」(同氏)。

今後の製造業におけるAI開発では、より高度なデジタルツインを可能にする3Dコラボレーション/シミュレーション基盤「NVIDIA Omniverse Enterprise」の活用も必須になってくるだろう。マクニカは、多数のパートナーから成るエコシステムも構築しており、より高いレベルのAI開発の要求に対応できる体制も整備している。製造業がAI活用を進める際には、サービスソリューションプロバイダーを目指す同社に相談してみてはいかがだろうか。

製造現場のAI活用をテーマにしたオンラインセミナーを開催!

マクニカが、製造現場の画像解析技術をテーマにしたオンラインセミナー「製造現場で活きるAI〜検知/検査自動化と最新画像解析テクノロジーの活用事例」を開催します(参加費無料)。詳細は以下のWebサイトをご確認ください。

開催日時:2022年7月29日(金)13:00〜14:30

Webサイト:https://www.macnica.co.jp/business/semiconductor/events/nvidia/141368/

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

提供:エヌビディア合同会社

アイティメディア営業企画/制作:MONOist 編集部/掲載内容有効期限:2022年9月2日

株式会社マクニカ クラビス カンパニー 第1技術統括部 技術第3部 部長代理 北島佑樹氏 提供:マクニカ

株式会社マクニカ クラビス カンパニー 第1技術統括部 技術第3部 部長代理 北島佑樹氏 提供:マクニカ 株式会社マクニカ クラビス カンパニー ビジネスソリューション第2統括部 営業第2部 第2課 課長 山田智教氏 提供:マクニカ

株式会社マクニカ クラビス カンパニー ビジネスソリューション第2統括部 営業第2部 第2課 課長 山田智教氏 提供:マクニカ