製造業IoTとは何か、インダストリアル・ビッグデータが分かれば見えてくる!:IoTやAIは魔法の杖じゃない

製造業にとって、IoTやAI、ビッグデータの活用は喫緊の課題となっているが、なかなか良い成果が得られないという意見も多い。それは、製造業が扱う「インダストリアル・ビッグデータ」に最適なソリューションではないからかもしれない。

インダストリアル・ビッグデータの特性を理解する4つのポイント

「今、製造業ではIoT(モノのインターネット)やAI(人工知能)、ビッグデータなどを活用し、課題を解決したいという企業が増加しています。これを成功させるためには、製造業のビッグデータである『インダストリアル・ビッグデータ』の特性を理解し、課題解決の用途に応じた適切なデータ活用ソリューションを導入することが不可欠です」

こう力説するのは、ISID 営業推進本部 インダストリアル・ビッグデータ営業推進部長の冨岡広氏だ。

「インダストリアル・ビッグデータ」とは、米シンシナティ大学の教授で米国立科学財団のIMS産業連携研究センター創始者であるジェイ・リー博士が提唱した考え方である。広義では産業界全般で使われるビッグデータのことで、製品の開発や生産、販売、使用などの活動で生み出されるデータ全般を指す。中でも、特に製造や保全など、エンジニア知見が必要な領域で用いられるデータに特徴的な特性である。

一言で「ビッグデータ活用」といっても、Webマーケティングなどに利用する商業ビッグデータと、インダストリアル・ビッグデータでは、「関係性」「質/量」「影響の大きさ」「透明性」などの観点において、データの特性そのものが根本的に異なる。冨岡氏は、「残念ながら現在は、マーケティング向けビッグデータ分析で成功している手法を、そのまま製造業のエンジニアリング業務に展開し、結果を出せないでいるケースが多い。これでは、製造業のビッグデータ活用の市場成長や発展を期待できません」と警鐘を鳴らす。

「関係性」の観点では、商業ビッグデータが相関関係や統計的な優位性が重要であるのに対し、インダストリアル・ビッグデータはデータポイントの関係性や構造などの因果関係が重要になる。「機器の構造によるシステム全体と、コンポーネント間の関係が複雑に関連している製品、機器や生産設備においては、物理法則などの因果関係を踏まえたうえでデータ分析をしないと、よい結果を導き出せません。この辺りをあまり意識せずに分析できる商業ビッグデータとの違いを理解することが大切です」(冨岡氏)。

また、データの「質/量」においては、重要なデータポイントをどれだけ網羅し、分析に不可欠な質の高いデータを収集できるかがカギとなる。マーケティング向けビッグデータのように「取りあえず収集した大量データから相関分析し、何らかの知見を可視化する」という手法では期待する結果は得られない。

さらに考慮すべきは分析結果の影響の大きさだ。例えば、故障予知分析で間違いがあったとしよう。マーケティング向けビッグデータ分析であれば、「間違ったユーザー層に広告を表示してしまった」で済む。しかし、インダストリアル・ビッグデータ分析では、本来、修理が必要だった製造ラインやマシンを分析ミスで見落としてしまった場合、人命に関わる深刻なアクシデントを引き起こす。予測精度が低い不正確な分析は、製造業に利用できないだろう。

そして何よりも重要なのが、データ活用の「透明性」と「説明性」である。市場には故障予知をうたうソリューションが存在するが、その多くは分析のアルゴリズムを公開しない「ブラックボックス型」である。あるいは深層学習手法などはそもそもなぜそのような結果となったのかの説明が出来ない。人命に関わる機器を稼働させるのに、どのようなロジックが利用されたのか分からない結果を妄信的に信じることは危険だ。

冨岡氏は、「エンジニアリングの知見が必要とされる領域でデータ分析に携わる人は、この4つの観点を理解していただきたい」と指摘する。

ホワイトボックス型の「IMS/知的保全」

ではインダストリアル・ビッグデータを正しく、そして効率的に活用するためには何が必要なのか。ISIDではインダストリアル・ビッグデータの活用に有効な3つのソリューションの展開に注力している。

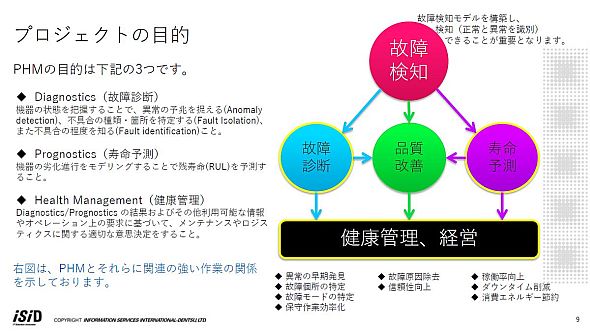

1つ目はPHM(Prognostics and Health Management)向けサービスである「IMS/知的保全」だ。PHMとは、製造現場の設備や製品に対する故障予知・保全に関するシステム工学的アプローチを指す。具体的には、製品・生産設備の故障検知や不具合カ所の特定・診断、残寿命の予測などを行い、ゼロダウンタイムの実現など経営課題の解決を目指すものだ。

冨岡氏は「IMS/知的保全」の特徴として「ツールベースの『ブラックボックス型』ではなく、お客様の技術課題に対して中身が分かる形で分析の予測モデルを作る『ホワイトボックス型』であること」を挙げる。

現在市場にあるほとんどのPHMソリューションはツールベースで提供されており、その分析エンジンの多くはブラックボックスだ。使いやすさをウリにしたツールや統計解析パッケージは、稼働状況などの可視化はできるものの、複雑なデータ構造を有するインダストリアル・ビッグデータを分析し、高精度で故障予知をするには力不足なのである。

冨岡氏は、「予測精度の高い故障予知を実現するには、データアプローチだけでなく、固有の設計思想に基づいたチューニングアップが必要です」と説明する。ISIDは単にツールを提供するだけではなく、顧客とともにエンジニアリングの知見を生かしながら“中身が分かる”分析モデルを構築し、それを顧客の環境に移管するというプロセスを採用している。「お客様とともに故障予知モデルを育てていくイメージですね。データ分析技術だけでもダメで、お客様が持つドメイン知見とうまく掛け合わせてあげなければいけません。これをわれわれは『ハイブリッド型』データ分析と呼んでいます」(冨岡氏)。

また、ISIDは従来コンサルティングで提供していた高度な分析ノウハウがライブラリやテンプレートとして備わった、PHMに特化したノンプログラミング分析モデル構築ツール「PDX Sandbox」を2018年1月より提供開始予定だという。これは「IMS/知的保全」のデータサイエンスパートナーである米国のPredictronics社が擁する豊富な故障予知プロジェクトの経験を基に作成されたものだ。PDX Sandboxについて冨岡氏は「ブラックボックスでは解決できない、自分達の製品・生産設備の実情を踏まえた故障予知をこれから始めたいというお客様に対応するものです」と説明する。

ホワイトボックスを売りにするPredictronics社だが、唯一ブラックボックス型サービスとして産業用ロボット向け故障予知アルゴリズムも開発している。これを用いてGEの産業用IoTクラウドプラットフォーム「PREDIX」で稼働する「Analytics Service」としてISIDが開発し、提供を開始する予定だ。PREDIXサイト上では、2017年11月現在で125件のAnalytics Serviceが公開されているが、GE以外が提供するサードパーティー製Analytics Serviceとしては、同社が初となる見込みだ。なお、今後はマイクロソフトのIoTプラットフォーム「Azure」にも対応する予定で、シーメンスの産業用IoTプラットフォーム「MindSphere」や三菱電機が旗揚げしたFA用IoTプラットフォーム「Edgecross」などへの展開も検討しているという。

さらにISIDでは「PHM Design」をコンセプトに、製品の構想設計段階からPHMを念頭に置き、最適なセンサー設計を行う活動の推進も計画している。具体的には故障予知を目的とした時に、どこにどのようなセンサーを組み込むべきか、最適なセンサーアーキテクトを検証できるソリューションを提供していくイメージだ。

「原因」と「結果」を見極められる「CALC」

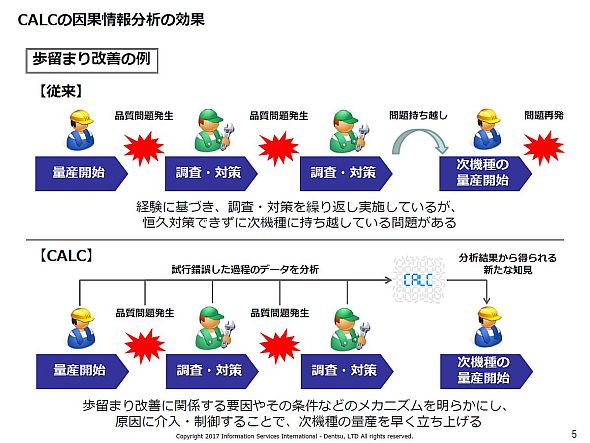

2つ目の取り組みは、モノづくりにおける技術開発の根幹を担う「メカニズム解明」の領域である。一般的なデータ分析では多くの相関が得られるが、相関関係と因果関係は異なる。そして、製造業に必要なのは「原因」と「結果」の因果関係を見極めることだ。

ソニーコンピュータサイエンス研究所(以下、ソニーCSL)でリサーチャーを務める磯崎隆司氏は、「一般的なビッグデータ分析は統計解析アプローチで、膨大な相関関係から何らかのパターンを探し出します。しかし、こうした分析手法では複雑な相関関係しか導き出せず、『結果』に対する『原因』の特定が難しいのです」と説明する。

そのような課題を解決する分析ツールが、ISID、ソニーCSL、クウジットの3社によって提供される「CALC」である。データから因果関係を分析してメカニズムの理解を助ける同ツールは、ソニーCSLが独自開発したAI技術を搭載。従来の解析手法では推定が難しいデータ間の因果関係を高い精度で抽出し、課題解決のための選択肢を明確化する。磯崎氏は「因果関係を把握することで仮説を裏付け、結果の制御や業務改善のPDCAを迅速に回すことができます」と語る。

例えば、多変量解析では、数万の関係性を解明するため、膨大な工数が必要であると同時に、解析は属人的で、解析結果にバラツキが生じる。しかし「CALC」は事象の振る舞いに影響を与えている固有の因子(直接相関)を抽出できる。そのため、故障の要因を絞り込んだり、立てた仮説が正しいかどうかを短時間で検証したりできるというわけだ。

さらに特徴的なのは、「カテゴリーデータと数値データを同時に扱えること」だと磯崎氏は説明する。

「例えば、歩留まりの改善施策を実施する場合には『どの装置を使ったのか』『どの生産ラインを使ったのか』『どのくらいのスキルレベルの従業員が作業したのか』『どのサプライヤーの部品を使ったのか』といったカテゴリーデータと、計測機器やセンサーから収集した数値データを組み合わせ、歩留まり低下の原因を特定する必要があります。一般に統計的な分析で通常の分析ツールでは両者を多数混合させて分析することはかなり難しいのです。仮に分析をしようとした場合には、膨大な工数が掛かったり、データの分布を仮定するなどの大きな制約が必要になったりします。しかし、CALCはそうした作業がほとんど必要ありません。『カテゴリーデータ』か『数値データ』かを意識せずに因果的分析ができるのです」(磯崎氏)

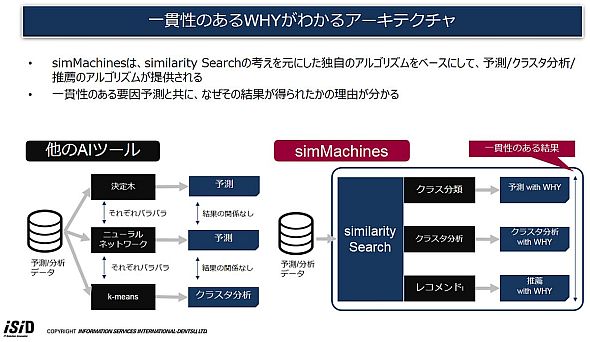

「なぜ」を説明する人工知能「simMachines」

3つ目の取組みはAIだ。製造業においても、従来の統計解析手法だけでなく、深層学習に代表されるAIで歩留まり向上させたり、設計を効率化したり、匠の技を有効活用したり、実験データを予測したりしたいというニーズは大きくなっている。ただし、ほとんどの深層学習分析は、「なぜその結果を導き出したのか」の理由を説明できないのが現状だ。

ISID 戦略ビジネス推進本部 インダストリアル・インターネット部長の芝田潤氏は、「お客様は分析部分をブラックボックス化せず、『どうしてこの結果が導き出されたのか』の理由を説明できるソリューションを求めている。それを具現化した機械学習ソフトウェアが『simMachines』です」と説明する。

simMachinesは、Webベースで予測モデルを生成・要因分析するソフトウェアだ。Similarity Based Machine Learningという独自の手法により、あらゆる予測の背後にある「なぜその予測結果を出したのか」を導き出せる。機械学習で不得意とされている予測/分析結果の要因が分かることで、説明責任を透明化し、PDCA運用を加速させることができるというアドバンテージがある。

さらに、データコード単位でも“なぜ(WHY)”の要因が分かるという。芝田氏は「ニューラルネットワークのような予測系アルゴリズムを採用しているAIツールは、複数のアルゴリズムを同時に実行し、予測精度が高い(いちばんよい)結果を選び出すという手法を採用しています。一方、simMachinesの予測アルゴリズムは、類似性を指標にした1つのアルゴリズムで予測、クラスタ分析、推薦アルゴリズムが構築されています。そのため、データレコード単位で一貫性のある要因と結果が得られるのです」と説明する。

ノンプログラミングで予測AIを生成し、APIとして利用できるのも他製品との差異化ポイントだ。データからAI予測器を生成し、すぐに予測モデルを既存の業務システムに組み込むことが可能だ。

つまり過去のデータを学習してできたモデルが、エキスパートの判断/評価代替支援を行うことが可能である。芝田氏は「各工程で収集したデータと、人の判定情報をひも付けます。ひも付けたデータから、人の判定要因が抽出されます。その上で、次々生成される未知のデータに対してモデルを適用することで、人の判断を自動化したり、支援するといった施策につなげられます」と説明する。

これらのようにISIDでは、インダストリアル・ビッグデータ分析に必要なソリューションを提供している。ただし、これらのソリューションは顧客側で「何を実現したいか」といった明確な目的があってこそ役立つ。冨岡氏は、「お客様側が目的を実現するために最適なやり方を見極めることが成功の要となります。IoT/データソリューションは、導入すれば課題とその解決方法が自動的に導き出されるような『魔法の杖』ではありません」と重ねて指摘している。

問い合わせ先

株式会社電通国際情報サービス 営業推進本部 インダストリアル・ビッグデータ営業推進部

TEL:03-6713-6134

E-mail:g-industrial-big-data@group.isid.co.jp

Copyright © ITmedia, Inc. All Rights Reserved.

提供:株式会社電通国際情報サービス

アイティメディア営業企画/制作:MONOist 編集部/掲載内容有効期限:2017年12月31日

ISID 営業推進本部 インダストリアル・ビッグデータ営業推進部長の冨岡広氏

ISID 営業推進本部 インダストリアル・ビッグデータ営業推進部長の冨岡広氏

ソニーCSL リサーチャーの磯崎隆司氏

ソニーCSL リサーチャーの磯崎隆司氏

ISID 戦略ビジネス推進本部 インダストリアル・インターネット部長の芝田潤氏

ISID 戦略ビジネス推進本部 インダストリアル・インターネット部長の芝田潤氏