ニュース

AIによる医用画像診断の根拠が専門医の所見と一致するとは限らない:医療技術ニュース

東北大学は、深層学習モデルが医用画像を診断した際の根拠と専門医の所見との一致度は必ずしも高くないことを確認した。医学的に妥当でない根拠は思わぬ診断結果を招く危険があるため、安全なAIの開発が期待される。

東北大学は2024年2月28日、深層学習モデルの医学的妥当性を詳しく検証し、AI(人工知能)による医用画像診断において、診断に至った根拠と専門医の所見との一致度は必ずしも高くないことを確認したと発表した。

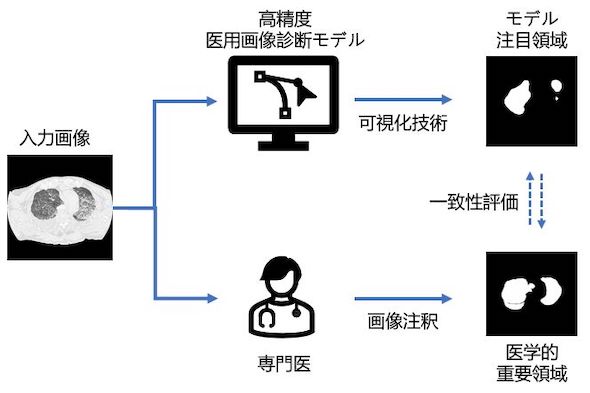

研究グループは、深層学習モデルが医用画像中のどこに注目して診断したのかを可視化する技術を用いて、法医学における死後画像を用いた溺水診断を例に検証を実施した。

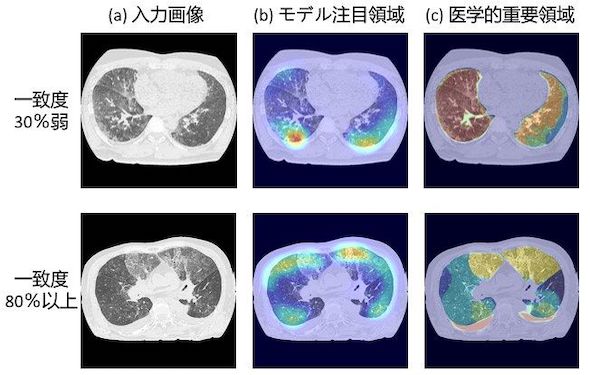

深層学習モデルが注目した画像の特徴をモデルの注目領域とし、放射性診断医の画像所見に基づく画像領域を医学的な重要領域として、両者を比較した。

その結果、モデルの注目領域は、少ない場合では30%しか医学的な重要領域と一致しなかった。また一致度が80%程度の場合でも、領域中で重要視する位置は異なっていた。

今回検証した深層学習モデルは、先行研究で90%以上の高い正答率で水死を分類できると報告されている。このことから、高い分類性能があっても、深層学習モデルと臨床上の医学的所見の間に大きなずれがあることが示された。

深層学習などAIの医用画像診断への応用が進んでいる。その一方で、AIが訓練データから何を学んだかについてはこれまで十分に解明されていなかった。医学的に妥当でない不適切な根拠は、思わぬ診断結果を招く危険があるため、今後、さらに多角的な医学的基準に沿った訓練法を開発するなど、より安全性の高いAIの開発が期待される。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

ウェアラブル心電計の開発、販売における資本業務提携を締結

ウェアラブル心電計の開発、販売における資本業務提携を締結

マクニカとココロミルは、次世代機器のサービスソリューションの共同開発と現行製品の販売を目的とした資本業務提携を締結した。マクニカは、ココロミルのウェアラブル心電計および解析サービスの販売を開始する。 大腸内視鏡画像をAIが解析する診断支援ソフトウェアを発売

大腸内視鏡画像をAIが解析する診断支援ソフトウェアを発売

オリンパスは、NBIモードで撮影した大腸内視鏡画像を、AIが検査中にリアルタイムで解析する内視鏡画像診断支援ソフトウェア「EndoBRAIN-X」を発売した。同社製の大腸汎用スコープで使用できる。 口臭を増強させる特定の口腔細菌の共生を発見

口臭を増強させる特定の口腔細菌の共生を発見

大阪大学とマンダムは、特定の口腔細菌が共生するだけで、強い臭気を発する口臭原因物質であるメチルメルカプタンの産生量が増加する「口臭増強機構」を発見し、そのメカニズムを解明した。 脳画像データから精神病発症を判別する機械学習器を開発

脳画像データから精神病発症を判別する機械学習器を開発

東京大学は、国際共同研究コンソーシアムのMRIによる脳構造画像データを機械学習することにより、のちの精神病発症を判別する機械学習器を開発した。精神病ハイリスク群を70%超の精度で判別可能だ。 ナノイーを照射した花粉ではアレルギー反応が抑制される

ナノイーを照射した花粉ではアレルギー反応が抑制される

パナソニックと麻布大学は、帯電微粒子水「ナノイー」で抗原性が抑制された花粉では、アレルギー反応が抑えられることを細胞レベルで明らかにした。 プエルトリコ工場に新棟建設、血管内治療用デバイスの生産力向上へ

プエルトリコ工場に新棟建設、血管内治療用デバイスの生産力向上へ

テルモは、血管内治療用の止血デバイス「アンジオシール」の生産能力向上を目的に、プエルトリコ工場に新棟を建設する。新棟建設と生産設備導入に関する投資額は約3000万ドルだ。