NVIDIAのGPUインフラが生成AI開発でも優位性を発揮できる理由とは:製造ITニュース

本稿ではNVIDIAが開催したオンラインイベント「NVIDIA 生成AI Day 2023 Fall」での講演、「生成AIの開発と運用を支えるエヌビディアの最新インフラ」の内容を紹介する。

NVIDIAは2023年11月25日、生成AI(人工知能)技術のビジネス活用などをテーマとしたオンラインイベント「NVIDIA 生成AI Day 2023 Fall」を開催した。本稿では、同社の日本法人であるエヌビディアでソリューションアーキテクチャ&エンジニアリング シニア ソリューションアーキテクトを務める佐々木邦暢氏による講演「生成AIの開発と運用を支えるエヌビディアの最新インフラ」の内容を紹介する。

GPU間の高速通信が大きな強みに

講演冒頭で佐々木氏は、大規模言語モデル(LLM)のパラメータサイズが年々巨大化しているとしたうえで、「GPUの強力な並列演算性能をもってしても、AIモデルのトレーニングに非常に長い時間がかかるというのが大きな課題となりつつある」と指摘した。そして、この解決に向けてNVIDIAがどのようなサーバ向けGPUやソフトウェアを提供しているかを紹介した。

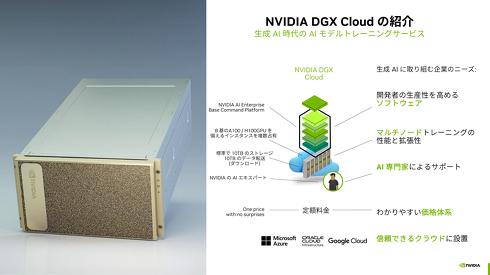

最初に取り上げたのが、エンタープライズのAI開発向けクラウドプラットフォーム「NVIDIA DGX Cloud」(DGX Cloud)だ。NVIDIAのサーバ向けGPU「NVIDIA DGX A100」(DGX A100)やその最新版である「NVIDIA DGX H100」(DGX H100)を8基組み合わせ、GPU間の高速な通信を可能にする「NVSwitch」で結んだGPUサーバをクラウド経由で提供する。同サーバはすでに、マイクロソフトのクラウドサービス「Azure」やOracleの「Oracle Cloud」、Googleの「Google Cloud」などで採用されている。DGX Cloudのユーザーは、エンタープライズレベルのAI開発を支援するソフトウェア「NVIDIA AI Enterprise」やAIモデルのトレーニング用プラットフォーム「Base Command Platform」なども併せて利用可能だ。

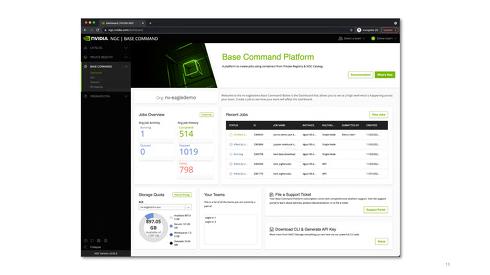

ユーザーはBase Command Platformを使うことで、GPUやサーバの使用規模の指定や、学習元のデータセットの選択、GPUの演算量やネットワークの通信量の確認など、AI開発に必要なインフラ環境の操作や情報把握がダッシュボード上で簡単に行えるようになる。複数人によるコラボレーション開発にも対応しており、ダッシュボード上で自身とチーム別のストレージ残量や使用量、システム稼働状況などを一元的に確認できるうえ、ユーザーごとの権限管理設定も簡単に行える。Base Command PlatformはNVIDIAの社内でも、画像生成AI「StyleGAN」などの開発で活用された実績があるという。

DGX Cloudの優位性について、佐々木氏は「AIモデルのトレーニングでは、各GPUが個々別々に動作するのではなく、演算結果を互いに交換しつつ進める必要がある。このためGPU間の通信も高速で行う必要があるが、これに対応できるサーバを提供できるのがDGX Cloudの大きな特徴の1つだ」と説明した。

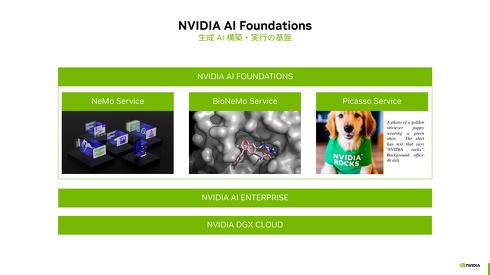

DGX Cloudを基盤に据えた生成AIプラットフォーム「NVIDIA AI Foundations」も紹介した。NVIDIAが開発した学習済み生成AIモデルを目的別サービスとして提供するもので、LLM開発向けの「NeMo Service」や創薬向けの「Bio NeMo」、画像や動画生成向けの「NVIDIA Picasso」の3つが利用できる。いずれもDGX Cloud上で動作するサービスで、目的に応じて最適なパラメーター数のモデルを選び、独自データを連携させて生成AIの独自アプリケーションを開発できる。

ソフトバンクの国産LLM開発基盤に採用

さらに佐々木氏はGPUサーバを複数組み合わせてクラスタリングした「DGX SuperPOD」も取り上げた。これまでNVIDIAが自社内で蓄積してきたDGXのクラスタリングのベストプラクティスを基にして、DGX A100の場合は20台、DGX H100の場合は32台を組み合わせたリファレンスアーキテクチャとなっている。

最大の特徴はGPUの計算能力を大きく引き出すために4種類のネットワークを採用した点だ。GPU1基ずつに1つのネットワークが割り当てられて相互の通信干渉を防ぐとともに、計算のための通信とストレージアクセス用の通信を別に用意するなどの工夫が取り入れられている。

このDGX SuperPODのアーキテクチャは、DGX A100で構築されたNVIDIAのスーパーコンピュータ「Selene」で採用されている。また、2023年10月31日にソフトバンクが3500億パラメーターの国産LLM開発を目指すと発表したが、この計算基盤としても使われている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

NVIDIAの最新AI開発環境を無償で試せる、マクニカの「AI TRY NOW PROGRAM」

NVIDIAの最新AI開発環境を無償で試せる、マクニカの「AI TRY NOW PROGRAM」

マクニカ クラビス カンパニーは、最新のNVIDIAソフトウェアプラットフォームを自社への導入前に無償で検証できる「AI TRY NOW PROGRAM」を構築し、サービス提供を開始したと発表した。 AIデータセンターの性能が20倍に、NVIDIAがAmpere世代のGPU「A100」を発表

AIデータセンターの性能が20倍に、NVIDIAがAmpere世代のGPU「A100」を発表

NVIDIA CEOのジェンスン・フアン氏は、YouTubeでオンデマンド配信した「GTC 2020」の基調講演において、新たなアーキテクチャ「Ampere」を採用したGPU「NVIDIA A100」を発表した。 NVIDIAによるArm買収、フアンCEOは「顧客や関連業界に多大な利益」と強調

NVIDIAによるArm買収、フアンCEOは「顧客や関連業界に多大な利益」と強調

NVIDIAとソフトバンクグループ(SBG)は、半導体IPベンダー大手のArmについて、NVIDIAがSBGとソフトバンク・ビジョン・ファンドから約400億米ドル(約4兆2400億円)で買収することで最終合意したと発表した。 NVIDIAが新GPUアーキテクチャ「Hopper」を発表、AI処理性能は4000TFLOPSへ

NVIDIAが新GPUアーキテクチャ「Hopper」を発表、AI処理性能は4000TFLOPSへ

NVIDIAは「GTC 2022」の基調講演において、新たなGPUアーキテクチャである「NVIDIA Hopperアーキテクチャ」と、Hopperを搭載するGPU「NVIDIA H100 GPU」を発表。H100は、800億ものトランジスタを集積しており、自然言語認識AIの開発で用いられているトランスフォーマーモデルの精度を落とすことなく処理性能を大幅に向上できるという。 NVIDIAがOmniverseを強化、デジタルツイン用システムやクラウドサービス発表

NVIDIAがOmniverseを強化、デジタルツイン用システムやクラウドサービス発表

NVIDIAは、オンライン開催のユーザーイベント「GTC 2022」の基調講演において、3Dデザインコラボレーション/リアルタイムシミュレーション基盤である「NVIDIA Omniverse」に関するいくつかの新しい発表を行った。 GPUはこれまでも、そしてこれからもディープラーニングをけん引する

GPUはこれまでも、そしてこれからもディープラーニングをけん引する

エヌビディアが主催するGPUを用いたディープラーニングのイベント「NVIDIA Deep Learning Institute 2017」の基調講演に、米国本社NVIDIAの主席研究員を務めるビル・ダリー氏が登壇。ディープラーニングの進化に果たしてきたGPUの役割を強調するとともに、今後もGPUがけん引役になると強調した。